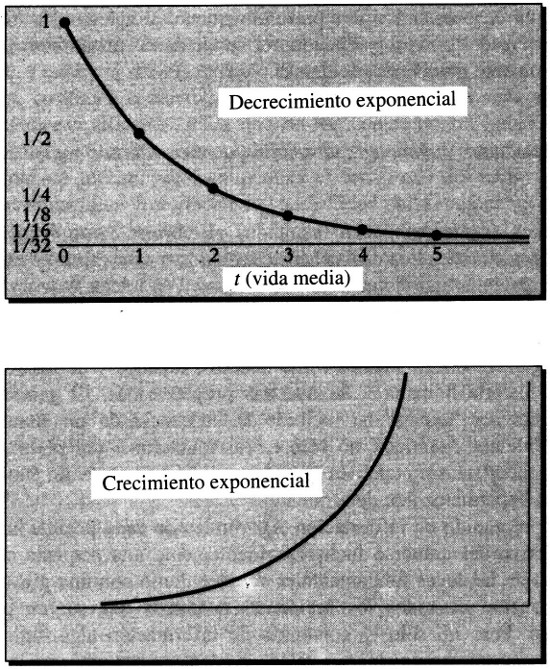

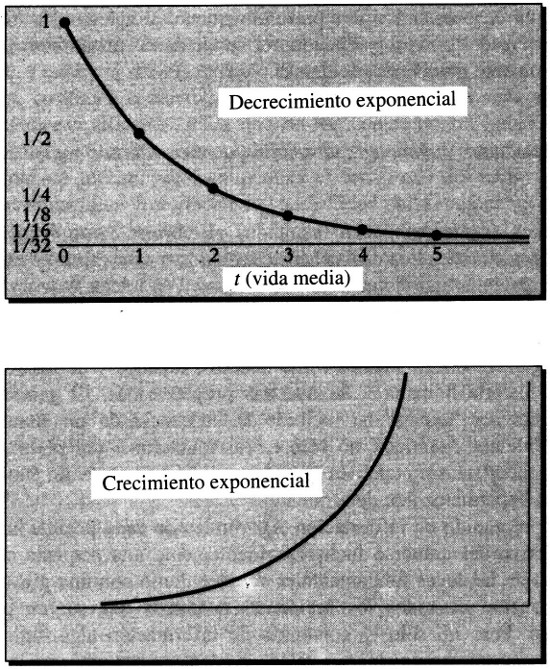

Figura 10. Arriba: Decrecimiento exponencial de la fracción de núcleos radiactivos no desintegrados al cabo de un tiempo t. Abajo: Crecimiento exponencial

Simplicidad y aleatoriedad en el universo cuántico

¿Cuál es el estado actual de las leyes fundamentales de la materia y el universo? ¿Cuánto de ellas está bien establecido y cuánto es mera conjetura? ¿Y qué aspecto presentan estas leyes desde la perspectiva de la simplicidad y la complejidad, o de la regularidad y el azar?

Las leyes fundamentales están sujetas a los principios de la mecánica cuántica, y en cada etapa de nuestro razonamiento los tendremos como referencia. La mecánica cuántica es uno de los mayores descubrimientos llevados a cabo por el hombre, pero es también uno de los más difíciles de aprehender por la mente humana, incluso para los que hemos trabajado con ella a diario durante décadas. Viola nuestra intuición —o, más bien, la intuición que hemos desarrollado ignorando los fenómenos mecanocuánticos—. Esta circunstancia hace que sea de lo más necesario explorar el significado de la mecánica cuántica, especialmente en relación a las nuevas ideas sobre su interpretación. De esta manera, puede resultar más fácil comprender por qué nuestra intuición parece obviar algo tan importante.

El universo consta de materia, y la materia está compuesta por partículas elementales de muchas clases, como los electrones y los fotones. Estas partículas carecen de individualidad —cada electrón del universo es idéntico a cualquier otro, y todos los fotones son intercambiables—. Sin embargo, cada partícula puede ocupar uno entre un número infinito de diferentes «estados cuánticos». Hay dos grandes grupos de partículas: los fermiones, como los electrones, que obedecen el principio de exclusión de Pauli —dos partículas de la misma clase no pueden ocupar el mismo estado simultáneamente— y los bosones, como los fotones, que obedecen una especie de principio de antiexclusión —dos o más partículas de la misma clase muestran una tendencia a ocupar el mismo estado al mismo tiempo—. (Esta propiedad de los fotones hace posible el funcionamiento del láser, en donde fotones en un cierto estado estimulan la emisión de más fotones en ese mismo estado. Dado que los nuevos fotones se hallan en el mismo estado, viajan en la misma dirección y poseen la misma frecuencia, constituyendo el haz del láser. La palabra LÁSER es un acrónimo de Ligth Amplification by Stimulated Emission of Radiation [amplificación de luz por medio de emisión de radiación estimulada].)

Los bosones, dada su tendencia a agruparse en el mismo estado cuántico, pueden incrementar su densidad hasta tener un comportamiento prácticamente clásico, como el de los campos electromagnético y gravitatorio. Las partículas bosónicas se pueden considerar en este caso como los cuantos —paquetes cuantizados de energía— de estos campos. El cuanto del campo electromagnético es el fotón. La teoría requiere también la existencia de un cuanto para el campo gravitatorio, un bosón llamado gravitón. De hecho, todas las fuerzas fundamentales deben estar asociadas a una partícula elemental, el cuanto del campo correspondiente. A veces se dice que el cuanto «transporta» la fuerza correspondiente.

Cuando se dice que la materia está compuesta de partículas elementales —es decir, fermiones y bosones— debería hacerse notar que, bajo ciertas condiciones, algunos de estos bosones pueden comportarse como campos más que como partículas (por ejemplo, el campo eléctrico que rodea una carga). Los fermiones pueden describirse también en términos de campos que, aunque no se comportan en absoluto de manera clásica, pueden sin embargo asociarse, en cierto sentido, con fuerzas.

Toda la materia posee energía, y toda energía está asociada con materia. Cuando se habla a la ligera de la conversión de materia en energía (o viceversa), se está diciendo simplemente que ciertas clases de materia se están convirtiendo en otras. Por ejemplo, un electrón y su antipartícula asociada de carga opuesta, el positrón, pueden interaccionar y convertirse en dos fotones, un proceso que a menudo se describe como «aniquilación» o incluso «aniquilación de materia para producir energía». Sin embargo, no es más que una simple transformación de materia o, si se prefiere, de energía.

Todas las partículas elementales conocidas (excepto el gravitón, partícula exigida por consideraciones teóricas) están descritas provisionalmente por una teoría que se ha dado en llamar el modelo estándar. La trataremos con algún detalle más adelante. Esta teoría parece estar en excelente acuerdo con la observación, pese a que algunos de sus rasgos aún no han sido confirmados experimentalmente. Los físicos esperaban comprobar estas peculiaridades (junto a nuevas e interesantes ideas que van más allá del modelo estándar) en el nuevo acelerador de partículas de altas energías (el «supercolisionador superconductor» o SSC) a medio terminar en Texas. Pero sus aspiraciones se han visto frustradas por la Cámara de Representantes estadounidense, en lo que constituye un conspicuo revés para la civilización humana. La única esperanza reside ahora en el acelerador suizo, de más baja energía, que se está construyendo en el CERN, cerca de Ginebra, reconvirtiendo una máquina antigua. Desafortunadamente, las energías en las que operará puede que sean demasiado bajas.

Los que hemos participado en la elaboración del modelo estándar nos sentimos, naturalmente, muy orgullosos de él, porque ha extraído una buena dosis de simplicidad de una desconcertante variedad de fenómenos. No obstante, hay diversas razones por las que no puede ser la teoría definitiva de las partículas elementales.

En primer lugar, las fuerzas tienen formas muy similares que claman por una unificación dentro de una teoría en la que aparecerían como diferentes manifestaciones de una misma fuerza subyacente; sin embargo, en el modelo estándar estas fuerzas se tratan como diferentes y no unificadas (en contra de lo que se ha dicho algunas veces). En segundo lugar, el modelo no es lo suficientemente simple; distingue más de sesenta clases de partículas elementales, con cierto número de interacciones entre ellas, pero no aporta ninguna explicación sobre tamaña variedad. En tercer lugar, contiene más de una docena de constantes arbitrarias que describen dichas interacciones (incluyendo las constantes que representan las masas de las diferentes partículas); es difícil aceptar como fundamental una teoría en la que tantos números importantes tienen un valor no calculable en principio. Finalmente, la gravitación no está incluida en el modelo, y todos los intentos realizados para incorporarla de una manera directa topan con dificultades desastrosas: los cálculos de las magnitudes físicas relevantes incluyen correcciones infinitas, lo que conduce a resultados que carecen de sentido.

Los teóricos de las partículas elementales intentan corregir estos defectos de dos maneras. La aproximación más directa consiste en generalizar el modelo estándar en lo que algunos han llamado una «teoría de gran unificación», aunque este nombre no esté muy justificado. Veamos cómo procede esta generalización con los cuatro problemas anteriormente expuestos.

Primero, las interacciones del modelo estándar que requieren unificación se consideran de hecho unificadas, junto con otras nuevas, a energías muy altas, con una descripción natural de cómo aparecen separadas en los experimentos actuales de bajas energías. Segundo, en la teoría todas las partículas elementales están agrupadas en unos pocos conjuntos cuyos miembros están íntimamente relacionados; se logra así una gran simplificación, pese a que el número de partículas aumenta sustancialmente (algunas con masas tan elevadas que no podrán ser observadas en un futuro próximo). Tercero, la teoría contiene aún más constantes arbitrarias no calculables que el modelo estándar. Y, finalmente, la gravedad sigue sin estar incluida, y el incorporarla resulta tan difícil como antes.

Una teoría como ésta posiblemente sea válida en un amplio rango de energías. Sin embargo, los puntos tercero y cuarto la invalidan claramente como candidata a teoría fundamental de las partículas elementales.

La búsqueda de esta teoría unificada fundamental nos conduce a la segunda manera de trascender el modelo estándar. Nos recuerda el sueño de Einstein sobre una teoría de campos que unificara de modo natural su teoría de la relatividad general para la gravitación y la teoría de Maxwell del electromagnetismo. En su vejez, Einstein publicó un conjunto de ecuaciones que pretendía satisfacer ese propósito, pero, desafortunadamente, sus argumentos eran puramente matemáticos —no describía interacciones físicas plausibles entre la gravedad y el electromagnetismo—. El físico más grande de la era moderna había perdido sus poderes. En 1979, en Jerusalén, durante la celebración del centenario del nacimiento de Einstein, me lamenté de que una medalla conmemorativa del acontecimiento hubiese sido acuñada con aquellas ecuaciones erróneas en el reverso —qué vergüenza para un científico que en su juventud produjo tantas ecuaciones llenas de belleza, correctas y de importancia capital—. Me molesta también que muchos retratos y estatuas de Einstein (como la de la Academia Nacional de Ciencias de Washington) lo muestren en su vejez, cuando ya no hacía contribuciones importantes a la ciencia, y no cuando era aquel joven atractivo y elegante que hizo tantos descubrimientos decisivos.

La tentativa de Einstein de elaborar una teoría de campos unificada estaba condenada desde un principio, y no sólo por el declive general de sus capacidades, sino por defectos específicos en su aproximación. Entre otras cosas, ignoraba tres importantes características del problema:

Pese a todos sus defectos, los físicos teóricos modernos nos hemos inspirado en una versión actualizada del sueño de Einstein: una teoría cuántica de campos unificada que incluya el fotón, el gravitón y el resto de bosones fundamentales, con sus campos asociados electromagnético, gravitatorio, etc., así como los fermiones, tales como el electrón. Esta teoría estaría contenida en una fórmula simple que describiría la gran multiplicidad de partículas elementales y sus interacciones y que conduciría, con las aproximaciones apropiadas, a la ecuación de Einstein para la relatividad general y a las ecuaciones de Maxwell para el electromagnetismo.

En la actualidad, el sueño de Einstein quizá se haya cumplido. Una nueva clase de teoría, denominada de «supercuerdas», parece poseer las propiedades adecuadas para conseguir la unificación. En particular, la «teoría de supercuerdas heteróticas» es el primer candidato viable para convertirse en la teoría cuántica de campos unificada de todas las partículas y sus interacciones.

La teoría de supercuerdas se desarrolló a partir de un principio de autoconsistencia —lo que los físicos anglosajones llaman bootstrap principle (principio de la lengüeta), denominación que evoca la vieja imagen de alguien que se levanta a sí mismo del suelo tirando de las lengüetas de sus zapatos—. La idea era que un conjunto de partículas elementales podía tratarse de modo autoconsistente como si sus elementos consistiesen en combinaciones de las propias partículas. Todas ellas harían las veces de constituyentes y a la vez (incluidos, en cierto sentido, los fermiones) serían los cuantos asociados a campos de fuerza que las mantendrían unidas; todas las partículas aparecerían como estados ligados de dichos constituyentes.

Hace años intenté describir este concepto ante una audiencia de la Hughes Aircraft Company. El ingeniero encargado del programa de satélites sincrónicos, Harol Rosen, me preguntó si aquello tenía alguna relación con lo que habían descubierto él y su equipo cuando intentaban explicar la presencia de señales parásitas en los circuitos que diseñaban; finalmente habían conseguido explicarlas asumiendo que se encontraban allí y demostrando que podían generarse a sí mismas. Estuve de acuerdo en que la idea del principio de autoconsistencia era, de hecho, algo por el estilo: las partículas, si se asume que existen, podrían generar las fuerzas que las unen entre sí; los estados ligados resultantes serían las propias partículas, y serían las mismas que aquéllas que propagan las interacciones. Si existiese tal sistema de partículas, se habría dado origen a sí mismo.

La primera versión de la teoría de supercuerdas fue propuesta por John Schwartz y André Neveu en 1971, basándose en algunas ideas de Pierre Ramond. Aunque aquella teoría parecía inverosímil por aquel entonces, invité a Schwarz y Ramond a Caltech, con la impresión de que las supercuerdas eran tan hermosas que tenían que servir para algo. Schwarz y varios colaboradores suyos, entre los que destacaba Joël Scherk, desarrollaron la teoría en los quince años siguientes.

Al principio, la teoría se aplicaba únicamente a un subconjunto de partículas, el mismo que los teóricos intentaban explicar por medio del principio de autoconsistencia. Finalmente, en 1974, Scherk y Schwarz sugirieron que la teoría de supercuerdas podría describir todas las partículas elementales. Les convenció de ello el descubrimiento de que la teoría predecía la existencia del gravitón y, por lo tanto, de la gravedad einsteniana. Casi diez años más tarde, cuatro físicos, conocidos colectivamente como el «cuarteto de cuerda de Princeton», anunciaron la versión conocida como teoría de supercuerdas heteróticas.

La teoría de supercuerdas, y en particular su versión heterótica, podría ser la largamente buscada teoría cuántica de campos unificada. En una aproximación adecuada implica, como debería ser, la teoría de la gravedad de Einstein. Más aún, incorpora la relatividad general y los demás campos dentro de una teoría cuántica de campos sin caer en los habituales problemas con los infinitos. Explica también el porqué de la gran multiplicidad de partículas elementales: el número de clases diferentes es en realidad infinito, pero sólo un número finito de ellas (algunos cientos, probablemente) tienen una masa lo suficientemente pequeña como para ser detectadas en el laboratorio. La teoría no contiene, al menos en principio, constantes arbitrarias o listas de partículas o interacciones, aunque en los análisis más minuciosos pueden reaparecer algunas indeterminaciones. Por último, la teoría de supercuerdas emerge de un simple y hermoso principio de autoconsistencia.

De entre todas las cuestiones fundamentales sobre la teoría heterótica de supercuerdas, la que aquí más nos interesa es la siguiente: asumiendo que es correcta, ¿es realmente la teoría de todo? Algunos han empleado esta expresión, incluso la abreviatura TDT, para describirla. Sin embargo, se trata de una caracterización engañosa, a menos que «todo» quiera decir únicamente la descripción de las partículas elementales y sus interacciones. La teoría no puede explicar por sí misma todo lo que es cognoscible sobre el universo y la materia que éste contiene. Se necesitan también otras clases de información.

Parte de esta información adicional se refiere a las condiciones iniciales del universo al principio de su expansión, o cerca. Sabemos que el universo ha estado expandiéndose durante los últimos diez mil millones de años. Esa expansión se revela con claridad a los astrónomos cuando observan cúmulos distantes de galaxias con potentes telescopios, pero no es en absoluto evidente cuando se observan objetos más cercanos. El sistema solar no se está expandiendo, ni nuestra galaxia, ni siquiera el cúmulo de galaxias al que pertenece la Vía Láctea. Las otras galaxias y cúmulos tampoco están expandiéndose. Pero los diferentes cúmulos se alejan unos de otros, y es esta recesión la que revela la expansión del universo. Nos podemos hacer una idea de esta expansión pensando en la cocción de un pastel de pasas: debido a la levadura, la masa del pastel (el universo) se expande, pero las pasas (los cúmulos de galaxias) no, aunque se separan entre sí.

El comportamiento del universo desde el comienzo de su expansión depende, obviamente, de las leyes que rigen el comportamiento de las partículas que lo componen y también de sus condiciones iniciales. Pero estas condiciones iniciales no son algo que sólo se presente en abstrusos problemas de física y astronomía, ni mucho menos. Desempeñan un papel importantísimo en nuestra experiencia cotidiana. En particular, determinan la flecha (o flechas) del tiempo.

Imaginemos la filmación de un meteorito que penetra en la atmósfera terrestre brillando incandescente mientras cruza el firmamento, y que se estrella finalmente contra la Tierra con un tamaño y peso mucho menor que al principio de su vuelo, consumida la mayor parte de su sustancia debido al calor generado por la fricción. Si proyectásemos la película al revés, veríamos una roca parcialmente enterrada en el suelo alzarse en el aire por iniciativa propia, aumentar de tamaño al recoger materia del aire mientras traza un arco en el cielo y alejarse finalmente por el espacio, más grande y más fría. La inversión temporal de la película es una secuencia de sucesos claramente imposible en el mundo real: podemos identificarla inmediatamente como una película proyectada al revés.

Esta asimetría en el comportamiento del universo al avanzar el tiempo hacia adelante o hacia atrás se conoce como la flecha del tiempo. En ocasiones se consideran separadamente diversos aspectos de esta asimetría como diferentes flechas del tiempo. Sin embargo, todas ellas están relacionadas; todas comparten el mismo origen último. Pero ¿cuál es este origen?

¿Puede basarse la explicación de la flecha o flechas del tiempo en las leyes fundamentales de las partículas elementales? Si un cambio en el signo del tiempo en las ecuaciones que describen estas leyes las deja invariables, entonces diremos que son simétricas respecto del sentido del tiempo. Si una inversión del tiempo altera la forma de las ecuaciones, diremos que presentan una asimetría temporal o que violan la simetría temporal. Una violación de este tipo podría dar cuenta, en principio, de la flecha del tiempo y, de hecho, se ha observado la existencia de una pequeña violación de esta simetría, aunque es un efecto demasiado particular para ser el causante de un fenómeno tan general como la flecha del tiempo.

La explicación alternativa es la siguiente: si desde el presente observamos en ambos sentidos del tiempo, encontramos que en uno de ellos, a una distancia de unos diez mil millones de años, el universo presenta un estado muy peculiar. Este sentido recibe un nombre arbitrario: el pasado. El sentido opuesto es el futuro. En el estado correspondiente a las condiciones iniciales, el universo era pequeño, pero esa pequeñez no caracteriza completamente su estado, que también era especialmente simple. Si en un futuro muy distante el universo deja de expandirse y comienza a contraerse, empequeñeciéndose de nuevo, no hay ninguna razón para creer que el estado final resultante sea el mismo que el estado inicial. La asimetría entre pasado y futuro se habrá mantenido.

Dado que ha surgido un candidato viable para convertirse en la ley unificada de las partículas elementales, resulta razonable preguntarse si disponemos también de una teoría plausible para las condiciones iniciales del universo. Efectivamente, existe una, propuesta por Jim Hartle y Steve Hawking a principios de los ochenta. A Hawking le gusta llamarla «condiciones de contorno sin contorno», un nombre válido pero que no transmite lo que tiene de particularmente interesante en lo que respecta a la información. Si las partículas elementales pueden realmente describirse por una teoría unificada (lo que Hartle y Hawking no asumen explícitamente), entonces se podría calcular, a partir de esa teoría, una versión modificada de sus condiciones iniciales, y las dos leyes fundamentales de la física, una para las partículas elementales y otra para el universo, se convertirían en una sola.

Sea o no correcta la idea de Hartle y Hawking, todavía podemos preguntamos lo siguiente: si especificamos la teoría unificada de las partículas elementales y las condiciones iniciales del universo, ¿podemos predecir el comportamiento del universo y de todo lo que contiene? La respuesta es que no, porque las leyes de la física son cuánticas, y la mecánica cuántica no es determinista. Sólo permite predecir probabilidades. Las leyes fundamentales de la física nos capacitan, en principio, para calcular las probabilidades de diferentes historias alternativas del universo que, dadas las condiciones iniciales, describan diferentes sucesiones de acontecimientos. La información sobre cuál de estas historias es la que está ocurriendo realmente sólo puede obtenerse a partir de la observación, y es suplementaria a las propias leyes fundamentales. De modo que es imposible que las leyes fundamentales nos suministren una teoría de todo.

La naturaleza probabilística de la teoría cuántica puede ilustrarse con un ejemplo simple: cualquier núcleo atómico radiactivo tiene una propiedad llamada «vida media», que es el período de tiempo en el que la probabilidad de desintegrarse es de un 50 por ciento. Por ejemplo, la vida media del Pu239 —el isótopo típico del plutonio— es de unos 25 000 años. Después de 25 000 años, hay una probabilidad del 50 por ciento de que un núcleo determinado de Pu239 no se haya desintegrado; tras 50 000 años, la probabilidad es sólo del 25 por ciento; tras 75 000 años, del 12,5 por ciento, etc. El carácter mecanocuántico de la naturaleza implica que esto es todo lo que podemos decir de un núcleo de Pu239 acerca de su desintegración; no hay forma de predecir el momento exacto en que se producirá. Únicamente es posible determinar una probabilidad en función del tiempo transcurrido, como indica la Figura 10. (Esta curva se conoce como decrecimiento exponencial; la función opuesta, el crecimiento exponencial, también se representa. Cualquier función exponencial genera, a intervalos iguales de tiempo, una progresión geométrica, tal como 1/2, 1/4, 1/8, 1/16, … para el decrecimiento, o 2, 4, 8, 16, … para el crecimiento.)

Figura 10. Arriba: Decrecimiento exponencial de la fracción de núcleos radiactivos no desintegrados al cabo de un tiempo t. Abajo: Crecimiento exponencial

Si el momento de la desintegración radiactiva no se puede predecir con exactitud, la dirección en que se produce es absolutamente impredictible. Supongamos que el núcleo de Pu239 está en reposo y que se desintegrará en dos fragmentos cargados eléctricamente, uno mucho mayor que el otro, que se moverán en sentidos opuestos. Todas las direcciones resultan entonces igualmente probables para el movimiento de uno de los fragmentos, pongamos el más pequeño. No hay forma de predecir en qué dirección se moverá.

Si hay tal grado de desconocimiento a priori sobre un núcleo atómico, imaginemos cuánto más fundamental es la impredictibilidad del universo entero, incluso aunque dispongamos de una teoría unificada de las partículas elementales y de sus condiciones iniciales.

Más allá de esos principios presumiblemente simples, cada historia alternativa del universo depende del resultado de un número inconcebiblemente grande de accidentes.

Tales accidentes tienen resultados aleatorios, como requiere la mecánica cuántica, los cuales han contribuido a determinar el carácter de las galaxias individuales (como nuestra Vía Láctea), de cada estrella y planeta (como el Sol y la Tierra), de la vida en la Tierra y de las especies particulares que evolucionaron en nuestro planeta, de los organismos individuales como nosotros mismos y de los sucesos de la historia humana y de nuestras propias vidas. El genoma de cualquier ser humano ha recibido la influencia de un sinnúmero de accidentes cuánticos, no sólo en las mutaciones del plasma germinal ancestral, sino también en la fecundación de un óvulo particular por un espermatozoide determinado.

El contenido de información algorítmica de cada posible historia alternativa del universo incluye evidentemente una pequeña contribución de las leyes fundamentales simples, junto con una gigantesca contribución de todos los accidentes cuánticos que surgen por el camino. Pero no sólo el contenido de información algorítmica del universo está dominado por tales accidentes; aunque son sucesos aleatorios, sus efectos contribuyen en gran medida a la complejidad efectiva.

La complejidad efectiva del universo es la longitud de una descripción concisa de sus regularidades. Como el contenido de información algorítmica, la complejidad efectiva sólo recibe una pequeña contribución de las leyes fundamentales. El resto proviene de las numerosas regularidades que resultan de los «accidentes congelados». Éstos son sucesos aleatorios cuyos resultados particulares tienen múltiples consecuencias a largo plazo, todas relacionadas por sus antecedentes comunes.

Las consecuencias de muchos de estos accidentes pueden resultar trascendentales. El carácter de la totalidad del universo se vio afectado por accidentes que ocurrieron cerca del comienzo de su expansión. La naturaleza de la vida sobre la Tierra depende de sucesos aleatorios que ocurrieron hace unos cuatro mil millones de años. Una vez que el resultado de uno de estos sucesos queda determinado, sus consecuencias a largo plazo pueden tomar el carácter de una ley perteneciente a cualquier nivel, excepto el más fundamental. Una ley geológica, biológica o psicológica puede nacer de uno o más sucesos cuánticos amplificados, cada uno de los cuales podría haber tenido un resultado diferente. Las amplificaciones pueden darse en virtud de multitud de mecanismos, entre ellos el fenómeno del caos, que en ciertas situaciones introduce una sensibilidad indefinidamente grande a las condiciones iniciales.

Para comprender por completo la significación de estos sucesos aleatorios, es necesario estudiar con mayor profundidad el sentido de la mecánica cuántica, la cual nos enseña que el azar juega un papel fundamental en la descripción de la naturaleza.