El mayor punto de inflexión en la historia de la informática tuvo lugar a mediados de los setenta, cuando grupos de fanáticos de la electrónica empezaron a producir pequeños ordenadores que podían comprarse con un sueldo de clase media apañao y tener en casa para… en general, para nada. Aquella gente se aprovechó de la reciente innovación del microprocesador —el «ordenador en un chip», según anunciaba entonces Intel— y de la experiencia adquirida con el desarrollo de calculadoras de bolsillo para construir sus aparatos. Fueron en aquella década lo que los radioaficionados a principios del siglo XX o los creadores de sitios web después: aficionados a una tecnología que en algunos casos terminaron convirtiendo su hobby en profesión o negocio.

La industria establecida al principio ignoró estos cacharros y a los chalados que los crearon, lo que permitió que pequeñas empresas salidas de la nada empezaran a producirlos comercialmente al margen de IBM y los demás grandes. Pese a que finalmente el gigante azul entró en el mercado como elefante en cacharrería, fueron empresas minúsculas nacidas entonces, Apple y Microsoft, las que terminaron llevándose el gato al agua. La difusión de la tecnología a precios ridículos permitió la explosión de productividad de finales de siglo y puso las bases que permitieron la expansión de Internet. Y, para qué negarlo, de los videojuegos. ¿O acaso se cree que ese ordenador que compró a sus hijos para hacer los trabajos de clase se usó para hacer los trabajos de clase? Deje que me ría.

Sí, en los años cincuenta y sesenta se fueron extendiendo los grandes ordenadores, generalmente fabricados por IBM, tanto con fines científicos como administrativos. Pero en buena medida contables, ingenieros y otras gentes de mal vivir seguían haciendo los cálculos a mano o con la ayuda de artilugios como la regla de cálculo.

Desde la invención de las técnicas necesarias para hacer las cuatro reglas de forma mecánica por parte de Jay Randolph Monroe en 1910 y Christel Hamann en 1911, algunos fabricantes como Friden, Marchant, Facit u Olivetti se habían especializado en fabricar calculadoras más o menos portables. El más ingenioso de estos artilugios fue el Curta, un ingenio mecánico en forma de cilindro que cabía en una mano y que permitió a su creador sobrevivir en el campo de concentración de Buchenwald.

El austriaco Curt Herzstark —ahora entendemos por qué el Curta se llama como se llama— era de madre católica y padre judío. En 1938 estaba desarrollando su idea de un ingenio mecánico para hacer cálculos, heredero de la máquina inventada por Leibniz en el siglo XVII cuando se vio felizmente envuelto en el Anschluss (la anexión de Austria por Alemania). La empresa en la que trabajaba, que era la de su padre, se vio forzada a trabajar para los nazis, y él tuvo que olvidarse de su invento. En 1943 fue enviado a los campos, pero le dieron la oportunidad de salvarse si su calculadora les convencía: el plan era regalársela a Hitler cuando ganara la guerra. Pero, claro, ese momento no llegó. No obstante, con esa excusa Herzstark completó su diseño, que comenzaría a fabricar tras la guerra.

Con los enormes tubos de vacío que caracterizaron a los primeros ordenadores, la tecnología electrónica no supuso una gran amenaza para el Curta o el comptómetro, otro de los populares aparatos mecánicos de la época. Pero llegó el transistor y la cosa cambió. Pese a que el circuito integrado fue inventado a finales de la década de los cincuenta, las primeras calculadoras electrónicas que aparecieron a mediados de los sesenta aún empleaban los transistores tradicionales debido al coste de los chips, de modo que no eran aparatos de bolsillo sino de escritorio. Fue Friden la empresa que, temerosa de que se le adelantaran otros competidores y le dejaran sin negocio, puso en el mercado en 1963 la primera calculadora construida completamente a base de transistores: la EC-130, que costaba 2200 dólares, lo cual era tres veces más que los modelos electromecánicos de la época.

En 1965, la empresa de An Wang —inmigrante chino que trabajó con Howard Aiken en Harvard— puso en el mercado la carísima Wang LOCI-2, la primera calculadora programable, a un precio de 6500 dólares, ni más ni menos. Fue el comienzo de una carrera muy exitosa para la empresa. La calculadora incorporaba 1200 transistores, que fundamentalmente se empleaban para calcular logaritmos y antilogaritmos de manera muy precisa; de este modo, multiplicaciones y divisiones se convertían en meras operaciones de sumas y restas de los logaritmos de los números con los que se operaba. Era una versión electrónica de la regla de cálculo, por así decir.

Pero fueron los siguientes modelos de Wang, la serie 300, los que rompieron el mercado, al menos entre el público profesional, gracias a un precio de 1800 dólares, fruto de mejoras en el diseño que lograron reducir el número de transistores hasta unos trescientos. Aunque aparecieron competidores como la HP-9100A o la Olivetti Programma 101, Wang permaneció como líder del mercado hasta la aparición de las primeras calculadoras equipadas con circuitos integrados en 1970, momento en el que decidió enfocarse en otros negocios al prever la guerra de precios que se iba a desatar. Un tipo listo, sin duda.

Empresas japonesas como Sanyo, Sharp, Canon o Busicom se aliaron con fabricantes norteamericanos de semiconductores para crear calculadoras que funcionaran gracias a circuitos integrados, produciendo ingenios casi de bolsillo como la Sanyo ICC-0081, la Canon Pocketronic y la Sharp QT-8B, que costaban menos de 400 dólares. Pero fue Busicom quien crearía la primera calculadora de bolsillo de verdad, la LE-120A, con todas las características que marcarían una época. Incorporaba todas las funciones de cálculo en un solo chip, el Mostek MK6010, una pantalla que representaba los dígitos en formato de siete segmentos mediante LEDs y alimentación a pilas. No obstante, la primera calculadora de éxito en Estados Unidos fue la Bowmar Brain, que se vendió como churros en las navidades de 1971 a un precio de 250 pavos.

La producción en masa de los chips necesarios para fabricar una calculadora produjo un progresivo derrumbe en los precios, colocándose por debajo de 150 dólares en 1972, de 100 en 1973 y de 50 en 1974; poco tiempo después se sustituyeron las pantallas por otras LCD y los chips se fabricaron con tecnología CMOS, lo que abarató y redujo el consumo de las calculadoras aún más. Los modelos de las distintas empresas terminaron siendo casi indistinguibles entre sí, por lo que la tecnología dejó de ser la principal razón del éxito o, llegado cierto punto, la mera supervivencia. El talento a la hora de vender fue clave para determinar el futuro de las empresas que se habían metido en el fregado.

Sólo unos pocos lograron diferenciarse de los demás y no convertirse en una commodity. Hewlett-Packard lo consiguió produciendo en 1971 la primera calculadora científica y, sobre todo, en 1974 con su HP-65, la primera calculadora programable de bolsillo, que fue llevada al espacio al año siguiente en la última misión espacial del programa Apolo por si la computadora de a bordo fallaba. Tenía de hecho mayor capacidad de proceso que esta, diseñada y fabricada durante los años sesenta. Hewlett-Packard la anunció como «ordenador personal», el primer uso del término que se conoce.

Aquella guerra de precios produjo un sinfín de bajas. Los que tuvieron más suerte o fueron más listos, como Wang, Sinclair o MITS, lograron reconvertirse a tiempo y fabricar otras cosas. Otros como Busicom o Bowmar simplemente se arruinaron. Al final quedaron las empresas japonesas Sharp y Casio como reinas de las calculadoras baratas y las norteamericanas Hewlett-Packard y Texas Instruments como dueñas del segmento de calculadoras científicas y programables. En los pocos años que duró, la guerra de las calculadoras había permitido demostrar la efectividad de los circuitos integrados, había hecho nacer al microprocesador y, sobre todo, había llevado la electrónica por primera vez a las masas. Las bases de la informática personal habían quedado establecidas, y los primeros ordenadores personales no tardarían mucho en llegar.

Robert Noyce, uno de los inventores del chip, y Gordon Moore, autor de la ley que lleva su nombre y que predice un progreso constante en la capacidad y precio de esas piezas de silicio que pueblan nuestros ordenadores, decidieron creerse las predicciones de este último e irse de Fairchild para fundar una nueva empresa: Intel.

Era el año 1968, y su propósito declarado consistía en fabricar chips de memoria en lugar de emplear los núcleos de ferrita en ese tiempo habituales. La idea resultaba absurda: los circuitos integrados no eran por entonces mejores, en términos de fiabilidad y capacidad, que sus predecesores. Pero ahí entraba la ley de Moore. Estaban seguros de que en muy poco tiempo tendrían razón. Total, que en 1969 lanzaron el circuito de memoria Intel 1103, de un mísero kilobyte de capacidad… pero que tuvo su éxito y todo. No habían tardado demasiado, la verdad.

Siendo como eran una empresa pequeña, no podían permitirse el lujo de rechazar encargos potencialmente lucrativos, aunque se alejaran del objetivo que se habían marcado. Así que recibieron a los japoneses del fabricante de calculadoras Busicom, que les pidieron que diseñaran los chips necesarios para hacer funcionar una docena de nuevos modelos de calculadora que querían sacar al mercado. Estudiando el tema, llegaron a la conclusión de que nunca recuperarían el coste de diseñar unos procesadores tan específicos. Pero ¿rechazar a un cliente? ¡Jamás!

Ted Hoff, el ingeniero encargado del proyecto, pensó que sería mejor optar por un diseño mucho más general. En lugar de hacer la docena de chips que les habían encargado, podían hacer uno de propósito general y guardar las especificaciones de cada una de las calculadoras en un programa aparte. De este modo, cada aparato tendría sólo tres chips: el procesador, la memoria para almacenar los datos y los resultados de los cálculos y el que albergaba el programa. Todos serían circuitos que podrían reutilizarse.

Hoff fue el encargado de diseñar la arquitectura general del chip, con la ayuda de Stan Mazor, pero pronto empezó a dedicarse a otros proyectos, así que el principal responsable de la difícil tarea de trasladar al silicio las ideas de sus compañeros fue Federico Faggin, con algo de ayuda de Masatoshi Shuma, de una Busicom con la mosca detrás de la oreja. Juntos crearon el Intel 4004, el primer microprocesador o, como lo llamaría Intel más tarde en sus folletos publicitarios, el primer «ordenador en un chip».

Ese eslogan, aunque algo exagerado, no estaba demasiado lejos de la realidad. El Intel 4004 tenía unos 2300 transistores —un poco por debajo de las 3000 válvulas del primer Univac— y sólo 4 bits, porque estaba pensado para calculadoras y le bastaba eso para trabajar con números decimales. Los de ahora andan por los 64 bits y unos pocos 1200 millones de transistores.

El problema es que nuestros hombres concluyeron el encargo en la primavera del año 1971, y para entonces ya estaba desatada la guerra de las calculadoras. Busicom tenía problemas para sobrevivir, y de hecho acabaría echando el cierre; en aquel momento lo que hizo fue pedir a Intel una rebaja en el precio. La empresa de Noyce y Moore accedió, a cambio de poder vender su microprocesador a otras compañías. Ahora sabemos que aquel acuerdo dio comienzo a un negocio multimillonario, pero entonces no estaba muy clara la cosa. De hecho, Noyce creía que el negocio seguía estando en las memorias, porque por cada ordenador se podía vender un solo microprocesador, pero muchos chips de memoria.

Como dándole la razón, el 4004 no tuvo demasiado éxito, entre otras cosas porque su arquitectura de 4 bits lo limitaba a productos como calculadoras o cajas registradoras. Pero puso a Intel a trabajar. En 1972 lanzaron el 8008, que era como su antecesor pero con 8 bits. Fue fruto de un encargo de Computer Terminal Corporation para uno de sus terminales Datapoint, fabricados para conectarlos a los enormes ordenadores de entonces. También diseñado por Faggin, el conjunto de instrucciones que aceptaba fue creado por los muchachos de CTC. Ese conjunto de instrucciones fue llevado por Intel, con algunos cambios, de microprocesador en microprocesador, hasta el 8088, que fue incluido en el primer PC, y de ahí al 80286, al 80386, al 80486, al Pentium, al Pentium Pro, al Pentium III, al Pentium IV, al Core, al Core 2 y a los Core i3, i5 e i7, que son los que empleamos hoy en día.

Al igual que sucediera con Busicom, CTC renunció a la exclusividad a cambio de ahorrarse unos dólares, y el 8008 fue empleado como controlador en muchos aparatos y en sistemas de procesamiento de texto. Pero fue el 8080 el primero que tuvo la calidad suficiente como para ser empleado como corazón de un ordenador. Y vaya si lo fue: el primer ordenador personal, el Altair 8800, usó precisamente ese chip.

El trabajo de Intel fue seguido de cerca por muchos otros, porque la idea del microprocesador estaba en el ambiente y habían jugado con ella empresas como Texas Instruments o Motorola. Pese a los augurios de Noyce, resultó ser un mercado mucho más lucrativo que las memorias, porque estas eran mucho más fácilmente intercambiables entre fabricantes, mientras que los microprocesadores permitían atar a los usuarios a tu compañía, ya que un programa creado para un tipo de microprocesador no puede funcionar directamente para otro. De ahí que un juego de instrucciones creado para un modelo de terminal por CTC, ahora llamado Datapoint, siga funcionando en nuestros ordenadores personales. La compatibilidad, ese arma tan poderosa…

Una vez el mundo se dio cuenta de la importancia de lo que habían hecho en Intel, tanto a Hoff como, en menor medida, a Razor se les honró como es debido. Pero al pobre Faggin lo ocultaron debajo de la alfombra, pese a ser el principal responsable de la creación del microprocesador. Eso le pasa por irse de Intel y encima fundar un competidor. Su empresa se llamó Zilog y su producto estrella, el Z80, fue el corazón de muchos ordenadores personales de los ochenta, como el ZX Spectrum. Y qué decir del pobre Shima, que también cometió la felonía de irse a Zilog y encima era japonés…

A lo largo de los años setenta, los componentes electrónicos de los ordenadores bajaron de precio lo suficiente como para que surgiera toda una hornada de individuos cuyo hobby consistía en montar calculadoras o incluso ordenadores con ellos. Eran personas que si hubieran nacido unas décadas antes se hubieran dedicado a montar y usar equipos de radioaficionado.

Lo que permitió el cultivo de esta afición fue la aparición de los primeros microprocesadores. Con ellos cualquier empresa hubiera podido construir un ordenador personal por alrededor de 2000 dólares de la época; pero a nadie se le ocurrió que ahí podría haber un mercado suculento. De modo que fueron los frikis de entonces, la gente que disfrutaba entre cables y circuitos impresos, los que se pusieron a ello: construyeron en sus casas sus propias computadoras. En general, no hacían nada útil, pues sus orgullosos propietarios eran más aficionados al cacharreo que a la programación, pero fueron la base sobre la que crecería luego la industria del ordenador personal.

De hecho, fue a ese pequeño grupo de entusiastas de la tecnología al que estaba dirigido el Altair 8080, el primer ordenador personal. Fue portada de la revista Popular Electronics en enero de 1975, y se vendía en forma de kit por 397 dólares (498 si se quería ya ensamblado). Era raro que una vez montado aquello tirara; y cuando, tras varios intentos, funcionaba, no hacía nada que pudiera considerarse útil. Tampoco era el objetivo: lo que quería el cliente era tener una computadora, no que hiciera algo…

Por dentro, el Altair consistía en un bus donde se conectaban las tarjetas con los componentes. Las tarjetas eran cinco, incluyendo una para el procesador y otra para la memoria, que alcanzaba la extraordinaria cifra de… 256 bytes. La entrada de datos se hacía por medio de interruptores. Con ellos se programaba el código máquina del Intel 8080, corazón de la computadora y antecesor del 8086 que llevaría el primer PC de IBM. La respuesta la daban una serie de luces rojas.

Sus creadores pertenecían a una muy pequeña empresa llamada MITS (Micro Instrumentation and Telemetry Systems), fundada a comienzos de la década con el objeto de comercializar pequeños productos de telemetría para cohetes caseros. Poco después centró el negocio en las calculadoras, un mercado que estaba en alza en aquella época; pero fue víctima de la competencia, que hizo bajar los precios muy por debajo del coste que suponía para MITS la fabricación de sus aparatejos. Así que Ed Roberts, uno de los dos fundadores de la compañía, pensó que, como las calculadoras comenzaron vendiéndose como kits que el cliente montaba en su casa, igual podría hacerse lo mismo de forma barata con un ordenador.

En sus planes entraba vender unas ochocientas unidades durante el primer año. Pues bien: en agosto ya había enviado cinco mil ordenadores a sus clientes. Y los veinte empleados de la casa habían pasado a ser noventa a finales de año. Además del ordenador, MITS ofrecía todo tipo de productos para expandirlo, de forma que pudiera ser utilizado de algún modo práctico: desde tarjetas de memoria de 1 o 4 Kbytes hasta un interfaz para enchufarle un teletipo con el que poder programarlo… y abandonar los incómodos interruptores. No obstante, la lentitud de la compañía a la hora de proveer esos periféricos permitió a un montón de aficionados y pequeñas empresas ofrecer alternativas compatibles, como sucedió con Processor Technology, que llegó incluso a crear una tarjeta gráfica que permitía al Altair mostrar caracteres en una pantalla.

Sin duda, el Altair 8080 dejó un legado duradero por sí mismo: en los dos años que siguieron a su lanzamiento una miríada de empresas nuevas, de las que a estas alturas sólo Apple sigue en el machito, atacaron el mercado de los ordenadores personales, inundándolo de ofertas más atractivas incluso para el usuario corriente. Pero también se le recuerda por haber comercializado el primer producto de una compañía recién fundada. Quizá les suene de algo. Se llamaba Micro-Soft.

Sus fundadores fueron Bill Gates y Paul Allen, veinteañeros y amigos desde el instituto, donde descubrieron su pasión común por la programación. Ambos afirman que cuando leyeron el ya famoso número de enero de 1975 de Popular Electronics concluyeron que el precio de los ordenadores seguiría cayendo y cayendo, y que el verdadero negocio estaba en vender software para los susodichos. Así que se pusieron manos a la obra con la táctica de asegurar que ya disponían de un producto para generar interés mientras se dedicaban a programarlo.

Su primer movimiento fue enviar una carta a Ed Roberts en la que afirmaban tener un intérprete para su ordenador del popular lenguaje Basic. Calcularon que tenían unos 30 días para ponerlo en marcha si querían que nadie les pisara la idea. Al creador del Altair le entusiasmó la propuesta, especialmente porque le daba la oportunidad de vender más ampliaciones de memoria con un jugoso margen de beneficio, de modo que llamó al número de teléfono que aparecía en la carta, que resultó ser de una casa en California… en la que no tenían ni idea de qué era eso de un ordenador, no digamos ya el Basic. En realidad, Gates y Allen estaban en Boston, y tuvieron que llamar ellos para recibir una respuesta, claro. Quedaron en que en un par de semanas le harían una demostración.

En realidad, les llevó seis semanas de trabajo intenso. No tenían ningún Altair, pero Allen había desarrollado un emulador de un procesador de Intel previo al 8080 que funcionaba en un modelo de ordenador que podían utilizar en Harvard, donde Gates estudiaba; de modo que lo modificó para que emulara correctamente el procesador que usaba el ordenador personal y así poder probar el intérprete de Basic. Mientras, Gates se esforzó en usar todos los trucos de que disponía para programar uno que entrara en unos escasos 4K de memoria. En cuanto lo tuvieron terminado lo grabaron en una cinta perforada, y Allen voló a Albuquerque para hacer la demostración. En el avión se dio cuenta de que no habían escrito ninguna rutina de arranque que cargara el intérprete en la memoria del Altair, así que se puso a ello en pleno vuelo.

Bueno, la cosa arrancó. Fue casi un milagro. Además, la nueva empresa tuvo el acierto de pedir una cantidad en royalties por cada copia vendida en lugar de recibir una única suma. Esto, y las subsiguientes versiones del Microsoft Basic para otros ordenadores personales, permitió a la entonces pequeña empresa sobrevivir… hasta que llegó IBM con el MS-DOS. Pero, como diría el gran Michael Ende, eso es otra historia, y deberá ser contada en otra ocasión. En concreto unas páginas más adelante.

En cuanto a Ed Roberts, cansado de gestionar el negocio, terminó vendiendo la empresa en 1976 por 6 millones de dólares, de los cuales recibió dos, y se retiró al campo. Más tarde estudió medicina y, cual doctor Fleischman en Alaska, acabó en un pueblo de Georgia de unos 5000 habitantes ejerciendo de galeno. Curioso destino para quien creó la ahora gigantesca industria de los ordenadores personales, ¿no?

Los fanáticos de Apple suelen acusar a Microsoft de que su mayor éxito de ventas, Windows, no es más que una vulgar copia del interfaz de su adorado Mac. Pero, siendo cierto, eso no significa que Steve Jobs fuera el rey de los innovadores. Simplemente fue el primero en copiar el trabajo de otra empresa, en este caso Xerox.

¿Xerox, la de las fotocopiadoras? Pues sí, esa misma. Como temía que los japoneses se hicieran con su negocio en cuanto expiraran sus patentes, en 1970 decidió poner en marcha un laboratorio de investigación, el Palo Alto Research Center (PARC), al que procuró dar toda la libertad posible, con el objetivo de que inventara cosas que pudieran comercializarse en el futuro y así conseguir diversificar su producción. Dados los ingresos que obtenía de las fotocopiadoras, el dinero que se gastó en el PARC era casi casi el chocolate del loro, aunque lo cierto es que, en términos absolutos, fue una pasta. Pero al final sólo logró beneficiarse de uno de los productos del ingenio de quienes allí trabajaron: la impresora láser. Andando el tiempo, muchos de sus empleados acabarían fundando empresas, como Adobe o 3com, para comercializar algunos de sus descubrimientos ya que la propia Xerox no se animaba; y otras compañías, como Apple o Microsoft, le copiarían vilmente.

Aquel laboratorio hizo varias aportaciones realmente importantes en aquella década de los setenta, como el estándar de red Ethernet, el lenguaje de descripción de páginas Inter Press o el primer lenguaje orientado a objetos: Smalltalk. No obstante, al final pasaría a la historia por la creación de un interfaz de usuario intuitivo para los ordenadores, que permitió a la gente normal y corriente usar los susodichos sin tener que aprenderse un manual y teclear comandos complicados. Ese interfaz se llamaría posteriormente WIMP, por las iniciales en inglés de sus principales componentes: ventanas, iconos, ratón y menús desplegables.

Pero para llegar hasta ese interfaz que empleamos actualmente —no sólo en ordenadores, también en móviles y otros muchos dispositivos—, la informática tuvo que recorrer un largo camino, desde aquellas primeras máquinas alimentadas por tarjetas perforadas. Fue en el marco de un proyecto iniciado en la Segunda Guerra Mundial cuando se hizo el primer avance clave: la capacidad de los ordenadores para responder de forma inmediata a las órdenes de los usuarios. Se llamó Whirlwind, echó a andar en 1943 y estaba dirigido por Jay W. Forrester. La idea era construir un simulador de vuelo con una cabina idéntica a las de los aviones y que respondiera de inmediato a lo que hiciera el aprendiz de piloto: de ese modo se podrían ahorrar muchas horas de vuelo de entrenamiento y tener más pilotos listos para el combate.

El proyecto no sólo no se terminó a tiempo, sino que jamás se produjo simulador alguno, aunque el ordenador que se creó para la ocasión se empleó posteriormente en un gigantesco sistema de defensa llamado SAGE. No obstante, se acabó resolviendo el problema de la inmediatez atacando el elemento más lento de los diseños de entonces, la memoria. Fue gracias al núcleo de ferrita, elemento que almacenaba la información merced a un campo magnético, tenía un tiempo de acceso de 9 microsegundos y sería la base de la memoria de muchos ordenadores en los años cincuenta y sesenta… y el escudo de mi Facultad de Informática, la de la Universidad Politécnica de Madrid.

Pero el principal avance se lo debemos a un ingeniero eléctrico llamado Douglas Engelbart, quien llevaba desde los años cincuenta imaginando un ordenador que facilitase la comunicación y permitiese acelerar investigaciones y descubrimientos. En los sesenta consiguió financiación del ARPA —agencia creada por el Gobierno estadounidense después del lanzamiento del Sputnik ante el temor generalizado de que Estados Unidos perdiera irremisiblemente la carrera espacial— y creó un grupo de trabajo en Stanford que acabaría alumbrando el NLS, un prototipo de oficina electrónica que incluía, aunque a un precio prohibitivo, adelantos como el ratón y las ventanas que formarían la base del sistema más completo que crearían en Xerox. La demostración que Engelbart hizo en 1968 del invento incluyó la primera videoconferencia, y se considera la madre de todas las presentaciones, incluyendo, sí, las de Steve Jobs y Al Gore.

Los recortes presupuestarios obligaron a algunos de los investigadores de Engelbart a buscarse las castañas en otra parte, y el hecho de que estuviese, como quien dice, en la puerta de enfrente permitió a Xerox PARC reclutar a varios de ellos. Ya en 1972 comenzaron a trabajar en el Xerox Alto, considerado por algunos el primer ordenador personal, aunque hay varios que le disputan el título: parece más razonable colgarle la etiqueta al Altair 8080, el primer ordenador diseñado y terminado como tal. Entre otros defectos, el Alto tenía el de no haber sido comercializado (ni lo sería jamás).

El modelo fue evolucionando con los años. Incluía una conexión de red, la misma que seguimos utilizando ahora, que también habían inventado en PARC: Ethernet. También un ratón algo más evolucionado que el de Engelbart, el de bola, que aún sobrevive en muchos lugares, aunque va siendo reemplazado progresivamente por los ópticos. Los documentos no se veían como una serie de caracteres en algún tipo de letra de paso como hasta entonces, sino tal y como luego se verían impresos, incorporando alguno de los primeros editores Wysiwyg (lo que ves es lo que obtienes). Y, por supuesto, gracias al equipo liderado por Alan Kay, tenía toda la parafernalia de carpetas, iconos, ventanas y menús que forma parte de todos los ordenadores actuales. Steve Jobs tuvo la oportunidad de verlo en 1979… y Apple se lanzó a imitarlo inmediatamente.

Xerox se decidió finalmente a producir un ordenador que incorporase todos esos conceptos y que pudiera vender: el 8010, más conocido como Xerox Star. Fue lanzado en 1981, el mismo año que el PC de IBM, y se convirtió en la estrella tecnológica del momento. Desgraciadamente, como le sucedería al Apple Lisa dos años después, su precio de 16 000 dólares era demasiado alto como para que el mercado al que estaba destinado, el de oficinas, lo comprara. Además, era un pelín lento, sobre todo por el sistema de ficheros elegido, que podía tardar varios minutos en guardar un archivo grande. Aunque en 1985 Xerox logró mejorarlo y reducir el precio a 6000 pavos, el Star estaba condenado, sobre todo con los PC y los Mac ya rondando por ahí…

Al final tuvo que ser una copia de una copia, el Windows de Microsoft, el que finalmente llevara a las masas ese interfaz de usuario que había soñado Engelbart. Y gracias a Internet, la realidad ha acabado siendo muy parecida a su sueño de que las personas tuvieran a su disposición un ordenador propio que les permitiese navegar por un espacio de información y colaborar entre sí para resolver problemas de una forma completamente nueva y más eficaz.

El Altair 8080 abrió las puertas a que muchas pequeñas empresas lanzaran sus propios ordenadores personales. De las compañías que se metieron en los años setenta en el negocio (Commodore, Tandy, Atari, Texas Instruments…) sólo sobrevivió una: Apple; gracias, fundamentalmente, a uno de sus fundadores, Steve Jobs, que acabó siendo recompensado con una patada en salva sea la parte.

Steve Jobs y Steve Wozniak eran dos amigos que se habían conocido en Hewlett-Packard. Fundaron Apple en 1976, junto al hoy desconocido Ronald Wayne, que les abandonó poco después por considerar un riesgo muy alto participar en una empresa en la que el único que tenía bienes dignos de ser embargados era él; de su participación, lo único que queda es el primer diseño del logotipo de la manzana. El objetivo de Apple era comercializar un ordenador personal que había diseñado Woz, que es como se conoce a Wozniak por el pecado de tener semejante apellido. Aunque al principio el técnico no estaba muy seguro de que aquello fuera a tener éxito, Jobs le convenció diciéndole que, si fracasaban, al menos podrían contarles a sus nietos que tuvieron su propia empresa.

Aquel primer producto, el Apple 1, no tenía teclado, ni transformador ni pantalla; ni siquiera caja… No era más que un circuito integrado que, eso sí, usaba una televisión para mostrar caracteres a la lastimosa velocidad de 60 por segundo y podía leer y grabar programas con una cassette, como harían tantos otros ordenadores hasta finales de los años ochenta. No deja de ser un inicio curioso para una compañía que luego sería conocida por el atractivo diseño exterior de sus aparatos. Le pusieron el precio de 666,66 dólares —Woz era un graciosillo—. Llegaron a montar doscientos equipos en casa de los padres de Jobs —primero en el dormitorio de este y más tarde en el garaje—, que vendieron principalmente a través de una tienda de informática local, Byte Shop.

Sí, el Apple 1 era tan cutre porque no tenían dinero para comprar mejores componentes. De hecho, tuvieron que vender la furgoneta Volkswagen de Jobs y la calculadora científica HP de Woz, entre otras cosas, para reunir el capital suficiente para comprar las piezas y poder venderlas ya ensambladas y probadas. Pero con el dinero de las ventas empezaron a planear cómo sería el sucesor de ese primer aparatejo. Jobs tenía claro que, si querían ir más allá del reducido mercado de los fanáticos de la tecnología, tendrían que ofrecer un producto simple, que sólo hubiera que conectar para que el usuario pudiera, efectivamente, usarlo. También necesitaría algo de software para funcionar nada más arrancarlo; al principio sería un intérprete del lenguaje Basic, como el que había desarrollado Microsoft para el Altair 8080. Woz, que pese a no tener estudios era un ingeniero de un talento descomunal, se puso manos a la obra, y en 1977 el Apple II estuvo listo.

El Apple II fue el más exitoso de la denominada Trinidad de 1977; principalmente porque sobrevivió, en varias versiones, hasta nada más y nada menos que 1993, si bien en aquellos años de finales de los setenta se vendía menos que los otros dos integrantes de la tríada: el Commodore PET y el Tandy TRS-80. Pese al éxito del 64 y el Amiga, Commodore fue a la bancarrota en 1994, y Tandy dejó de fabricar ordenadores en los noventa: en 2000 cambió su nombre por el de RadioShack, su cadena de tiendas de computadores y electrónica.

Apple, en cambio, sobrevivió. De milagro. La principal razón no fue el talento ingenieril de Wozniak, sino la capacidad de Jobs para vender burras. Se cuenta, por ejemplo, que cuando tenía trece años llamó por teléfono a uno de los fundadores de HP, el multimillonario William Hewett, para pedirle unos componentes electrónicos que necesitaba para un proyecto escolar. El asombrado empresario no sólo se los envió, sino que le metió en los programas de verano de la compañía, que es donde conocería a Wozniak. Ya en 1977, Jobs tenía claro que si querían sobrevivir debían crecer, y para ello necesitaban que la empresa fuese gestionada por alguien que supiese cómo se hacían esas cosas, financiación suficiente, acceso a los canales de distribución y unas buenas relaciones públicas. Consiguió dinero de un inversor de capital riesgo, Mike Makkula, que le presentó su antiguo jefe en Atari. Este le consiguió un directivo profesional para llevar la empresa, Mike Scott. Y finalmente logró que Regis McKenna lo aceptara como cliente de su agencia de publicidad.

Tecnológicamente, Apple II incorporaba algunas novedades interesantes, como su capacidad para desplegar gráficos en color, razón por la cual el logotipo de Apple cambió —para mostrar una suerte de arco iris—, y su unidad de disco externa, Apple Disk II, fue la primera en resultar asequible gracias a las innovaciones que Wozniak introdujo en su diseño y que permitieron abaratarla lo suficiente.

Se ofreció como un ordenador personal para el hogar. El anuncio mostraba a una mujer en la cocina mientras el marido, en segundo plano, trabajaba con el Apple II. El texto venía a decir que el cacharro en cuestión permitiría llevar la contabilidad de la casa, almacenar recetas, calcular los impuestos y realizar todo tipo de tareas… que en realidad no podía hacer, porque casi no tenía aplicaciones. Sin embargo, todo cambió gracias al lanzamiento, en 1979, de la primera hoja de cálculo de éxito, VisiCalc, que convirtió el ordenador en un objeto de deseo para muchos ejecutivos.

El rumbo de Apple quedaría marcado por la visita que hicieron Jobs y algunos ingenieros de la empresa a los laboratorios de Xerox en Palo Alto. Ahí descubrirían el interfaz de usuario que estaban desarrollando, y decidieron hacer algo similar. Así, en 1983 aparecería Lisa. Era un ordenador extraordinario, con ratón y con los conceptos de las interfaces modernas, como las ventanas, el arrastrar y soltar, las carpetas, los iconos… en fin, todo. Pero costaba 10 000 dólares y, claro, no lo compró ni el tato.

Sin embargo, nadie podía culpar del fracaso a Wozniak o a Jobs. El primero había sufrido un accidente de aviación en 1981 que le produjo problemas con la memoria a corto plazo; luego, cuando se curó, decidió cambiar de vida, abandonar Apple, casarse y volver a la universidad; quizá su participación hubiera permitido construir un producto mucho más barato. En cuanto a Jobs, la junta directiva de la compañía decidió que no era capaz de dirigir un proyecto tan complejo como Lisa. Así que tuvo que conformarse con otro que la empresa consideraba menor, con una plantilla inicial de ocho ingenieros. Se llamaba Macintosh.

La idea era llevar a la realidad esa imagen que aparecía en el anuncio del Apple II: un ordenador suficientemente fácil de usar y a la vez suficientemente barato como para poder convertirse en un electrodoméstico más, al menos en las casas más pudientes. Steve Jobs se equivocaba. No existía aún un mercado para eso. Pero ese enfoque obligó a reducir al máximo los costes, clave para su éxito posterior en nichos de mercado como la edición y el diseño gráfico. Básicamente, su trabajo consistía en rehacer Lisa con componentes más genéricos y mucho más baratos. El sistema operativo y su interfaz de usuario fueron reprogramados en lenguaje ensamblador, lo que permitió hacerlo más rápido y pequeño, aun a costa de complicar el desarrollo.

El fracaso de Lisa puso a Apple en una situación delicada. Su único éxito de ventas era el Apple II, y estaba condenado a morir antes o después en el altar del recién llegado IBM PC. Su sucesor, el Apple III, fracasó estrepitosamente. El intento de situar la compañía como proveedora de ordenadores para las empresas había fracasado. Así que su única posibilidad de sobrevivir era, de nuevo, Steve Jobs y su Mac. El desarrollo se aceleró. De ocupar una pequeña oficina —que adornaron con una bandera pirata para remarcar su condición de outsiders dentro de la empresa—, el proyecto creció hasta ocupar a cuarenta y siete ingenieros: Jobs se empeñó en que todos ellos firmaran en el molde que se usaría luego para fabricar las cajas de plástico que formaban el exterior del ordenador. Su precio iba a rondar los 2000 dólares, aunque finalmente se vendería por 2500 para sufragar los gastos de publicidad en que iba a incurrir la empresa.

Fue en ese periodo cuando Jobs decidió buscar un nuevo jefe capaz de llevar la empresa a buen puerto. Se decidió por John Sculley, que había logrado resucitar Pepsi y convertirla de nuevo en un rival digno de Coca-Cola. Lo convenció con su inagotable talento de vendedor: «¿Qué prefieres, seguir vendiendo bebidas azucaradas a los niños el resto de tu vida o tener una oportunidad de cambiar el mundo?». Sculley decidió que el camino de Apple era diferenciar su producto del PC, que se había convertido rápidamente en un estándar. Su principal arma fue un anuncio de televisión dirigido por Ridley Scott y que fue emitido una sola vez, en la Superbowl de 1984. En él, una heroína sin nombre destruía al Gran Hermano mientras la voz invitaba a descubrir el Mac y así averiguar «por qué 1984 no será como 1984». Repetido incesantemente durante las siguientes semanas en los informativos, logró crear un aprecio por la marca que aún perdura.

Sin embargo, Jobs no pudo disfrutar del éxito. Al principio las ventas del Mac fueron flojas y él se empeñó en culpar a Sculley, al que quiso descabalgar. Se produjo una lucha por el poder entre los dos que terminó con la decisión de la junta directiva de prescindir de Steve: en 1985, al poco de cumplir los treinta años, fue despedido de la empresa que había fundado.

En lugar de hundirse, o retirarse a vivir de las rentas, Jobs vendió todas sus acciones (menos una); con el dinero fundó otra empresa informática, NeXT, y compró a George Lucas un pequeño grupo de animación por ordenador, The Graphics Group, al que después llamaría Pixar. En 1995 estrenó Toy Story, la primera de una increíblemente exitosa serie de películas animadas por ordenador, que salvaron a Disney de la bancarrota y permitieron a Jobs hacer una provechosa venta y, así, convertirse en el mayor accionista individual de la compañía del tío Walt.

En 1996 Apple compró NeXT… y Jobs volvió a dirigir su compañía un año después. Los Mac estaban entonces en franca decadencia, pero el sistema operativo creado en NeXT sirvió de base para el Mac OS X, lo que permitió que, tecnológicamente, Apple volviera a estar en la vanguardia y, poco a poco, alcanzara cifras de venta que nunca antes había tenido. En 2001 lanzó el reproductor musical portátil iPod, del que se han vendido más de 200 millones de unidades; en 2007 le llegó el turno al iPhone, que ha superado los treinta millones de ventas…

Ah, y los Mac son los únicos ordenadores personales que han sobrevivido a la estandarización que supuso la aparición del PC, en 1981.

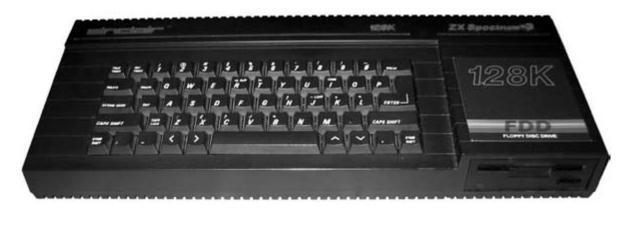

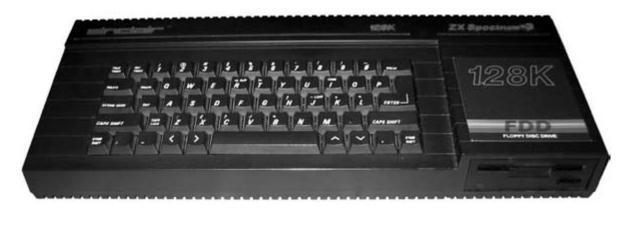

Si en Estados Unidos la revolución del ordenador personal estuvo liderada por el Apple II, en toda Europa, y especialmente en España, la llegada de estos cacharros a los hogares la protagonizó un pequeño aparato negro con teclas de goma: el Sinclair ZX Spectrum.

Su creador, Clive Sinclair, había comenzado muy pronto en esto de la electrónica. Hijo de ingenieros, en lugar de estudiar quiso trabajar pronto a fin de lograr el capital necesario para fundar su propia empresa. Tras unos años en el sector editorial, dirigiendo revistas y escribiendo libros de electrónica, pudo fundar en 1961 su primera compañía, Sinclair Radionics, mediante la cual comenzó a vender sus kits de electrónica para equipos de radio y alta fidelidad. Durante la segunda mitad de los sesenta, su nombre empezaría a hacerse conocido por fabricar los aparatos de radio más pequeños del mundo: Micro-6 y Micromatic, gracias a los cuales ganó a los japoneses en su especialidad.

Sin embargo, sería en los setenta cuando alcanzaría sus mayores éxitos, al involucrarse en la cruenta guerra de las calculadoras. En el verano de 1972 lanzaría la Sinclar Executive, la primera calculadora de bolsillo realmente delgada (9 milímetros frente a los 22 o 35 de sus competidoras), cuyo tamaño era más o menos parecido al de un iPhone. Sus ingenieros lograron reducir el consumo de estos aparatos de 350 a 30 milivatios, cortando la corriente doscientas mil veces por segundo. Al ser tan rápido, ni a la pantalla ni a los chips les daba tiempo a apagarse del todo, de modo que recordaban qué estaban haciendo y podían cumplir su cometido. Gracias a ello pudieron emplear pilas de botón en lugar de las que se empleaban entonces, mucho más grandes y que engordaban la máquina.

Ahora bien, la ruina de Sinclair Radionics era inminente. Y no por las calculadoras, como le sucedería a tantas y tantas empresas de electrónica de la época, sino por el lanzamiento en 1975 de un reloj digital, el Black Watch, un cacharro tremendamente sensible a la electricidad estática, tanto que en muchas ocasiones ya salía de fábrica estropeado, o se fastidiaba cuando lo rozaba una prenda de nylon. Para colmo de males, las baterías duraban sólo diez días, y se atrasaba o adelantaba dependiendo de la temperatura ambiente. Un desastre que arruinó la empresa a base de devoluciones.

El gobierno laborista de entonces la salvó; los intentos de reflotarla mediante un televisor portátil y un ordenador llamado New Brain fracasaron, y en 1979 el gobierno acabó por echar a Clive Sinclair de la que había sido su empresa para proceder a dividirla y vender los pedazos, como hacía el malvado capitalista Richard Gere antes de ser salvado por Julia Roberts en Pretty Woman.

El ingeniero sin título tenía un Plan B. Años atrás había comprado otra compañía sin actividad con la intención de volcar en ella sus esfuerzos si las cosas iban mal en Radionics. Llamada Sinclair Instruments, logró lanzar con éxito una calculadora de pulsera y un microordenador personal en forma de kit, el MK-14, que costaba sólo 40 libras frente a los precios más comunes entonces, de entre 400 y 750 libras; claro, que los demás ordenadores podían hacer cosas útiles y este, como en su día el Altair 8080, era un juguete para aficionados a la electrónica. Pero tuvo éxito y permitió a su fundador encontrar un refugio tras su despido.

Clive Sinclair tendría su epifanía al leer un artículo del Financial Times en el que se auguraba que en el plazo de cuatro o cinco años habría ordenadores por menos de cien libras. Además de cambiar el nombre de su empresa compulsivamente (pasó a ser Science of Cambridge, luego Sinclair Computers y finalmente Sinclair Research), se esforzó por arruinar aquella predicción anunciando ocho meses después, en enero de 1980, el lanzamiento del ZX80.

Con un precio de 80 libras en forma de kit y 100 ya montado, el ZX80 redujo los costes empleando una poco duradera membrana táctil como teclado, un televisor como monitor y un casete como sistema de almacenamiento, estos dos últimos no incluidos, claro. Tenía 1 kilobyte de memoria RAM, los números sólo alcanzaban los cinco dígitos y los decimales… como que no se le daban muy bien. Sinclair, pensando en el mercado educativo, incluyó el lenguaje Basic, lo que terminaría provocando que un buen número de programadores aprendiéramos el oficio con ese lenguaje. Fue un gran éxito para la época, vendiéndose unas 50 000 unidades.

Al año siguiente, Sinclair presentó el ZX81. Prácticamente idéntico a su antecesor, pero empleando menos chips, tenía un precio menor: 50 o 70 libras, dependiendo de si había que montarlo o venía ya completo de fábrica. Pese a errores graves de diseño —por ejemplo, daba 1,3591409 como resultado de la raíz cuadrada de 0,25, en lugar de 0,5—, el ordenador traspasó las fronteras de Gran Bretaña y vendió millón y medio de unidades antes de ser reemplazado por la obra que valdría a Sinclair un huequecito en la historia de la informática: el ZX Spectrum.

Venía en dos versiones, de 16 y 48 Kb, y podía mostrar colores en pantalla y emitir sonidos. El teclado había mejorado, levemente, con la introducción de teclas de goma en lugar de la membrana táctil. Entre el modelo original y sus sucesores se venderían unos cinco millones. Era más caro y ya no se vendía como kit, pero por 125 libras, o 175 si se quería con más memoria, se disponía de un ordenador bastante completo que para muchos, incluyendo a quien escribe esto, supuso su primer contacto con la informática: existe toda una generación Spectrum entre la profesión.

Pese a su intención educativa, lo cierto es que el Spectrum terminó convirtiéndose en una máquina dedicada principalmente a los videojuegos; de ello se encargarían principalmente los mismos jóvenes que gracias a él pusieron sus zarpas encima de un ordenador por primera vez. Se han programado para el Spectrum alrededor de 20 000 títulos, que a pesar de incluir software profesional como bases de datos o procesadores de texto fueron principalmente juegos; aún hoy siguen existiendo máquinas clónicas en el este de Europa, como el Pentagon 1024SL, con cuatro megas de RAM y disco duro, y hay pirados que continúan haciendo videojuegos para él.

Desgraciadamente, los días de vino y rosas duraron poco. Sinclair empezó a ser una figura popular en Gran Bretaña, donde se le conocía como «tío Clive». El Gobierno de Thatcher, al que apoyó incansablemente, le otorgó el título de caballero. Pero como sucediera en Radionics, pronto llegarían los fracasos. El primero fue el ordenador destinado a suceder al Spectrum, al que llamó QL. Lanzado poco antes que el Mac, en 1984, era caro (cerca de 400 libras) y estaba destinado a un mercado más profesional. Pese a disponer de multitarea antes que nadie e incluir un paquete ofimático, se lanzó prematuramente y estaba repleto de errores de diseño. Además, el mercado profesional se comenzaba a volcar hacia el PC, y siendo el QL incompatible con el Spectrum, los propietarios de este no tenían razones para cambiarse.

Pero lo peor, no obstante, fue el desarrollo y lanzamiento del C5, un viejo empeño que arrastraba sir Clive desde los años setenta. Era un vehículo eléctrico que alcanzaba sólo los 25 kilómetros por hora y era incapaz de subir cuestas si no se le ayudaba pedaleando. Encima se presentó en el duro invierno británico, y el cacharro no tenía techo: se vendieron 12 000 unidades. En la ruina, Sinclair se vio obligado a vender su empresa a Amstrad, su principal competidor, que produciría nuevas versiones del Spectrum hasta 1990.

La generación que creció con los ordenadores Sinclair ya se ha convertido en gente importante. Por poner un ejemplo, Linus Torvalds, el creador de Linux, aprendió a programar con un QL, y su segundo de a bordo, Alan Cox, comenzó haciendo juegos para el Spectrum.

El tío Clive sigue en activo, a sus setenta años. Su último producto es una bicicleta plegable hecha con materiales ultraligeros. Y planea lanzar la X1, una bici asistida por un motor eléctrico que recuerda al C5. Eso sí, esta vez con techo.

William Henry Gates III era un programador muy bueno y un empresario con olfato y pocos escrúpulos. Pero sólo con esas cualidades, imprescindibles por otra parte para su éxito, no se hubiera convertido en el hombre más rico sobre la faz de la tierra. Hizo falta otra: la suerte.

Microsoft, la empresa que había fundado junto a Paul Allen, había prosperado bastante desde que le vendieran su intérprete de Basic a Ed Roberts, el creador del primer ordenador personal. Durante la segunda mitad de los años setenta un montón de compañías se dedicaron a lanzar sus propios ordenadores personales basados en el procesador Intel 8080 y casi todos tenían instalados dos productos de software: el Basic de Microsoft y un sistema operativo creado por Digital Research y llamado CP/M, cuya ubicuidad provocó que fuera conocido como el «Unix de los microordenadores».

Así, en 1981 las dos empresas tenían una situación similar. Ambas contaban con unos 100 empleados y facturaban 15 millones de dólares. Sin embargo, unos meses antes Digital Research le había dejado a Microsoft en bandeja la llave de un casi inagotable baúl de dinero. Eso sí, ni uno ni otro lo sabían.

IBM había dejado pasar la revolución del ordenador personal, más que nada porque como hemos visto comenzó como un fenómeno de frikis que tenían el ordenador como hobby. Pero estos pequeños aparatos empezaron a colarse dentro de las empresas, y el gigante azul reaccionó con una velocidad sorprendente y un enfoque revolucionario para una compañía acostumbrada a hacerlo todo en casa. En julio de 1980, el directivo William Lowe propuso al consejo de IBM crear un ordenador personal a base de juntar piezas producidas por otras compañías, de modo que pudieran tenerlo listo lo antes posible, ya que la velocidad parecía fundamental en este nuevo mercado. La propuesta fue aceptada dos semanas después, con la obligación de tenerlo listo en un solo año.

El equipo de IBM encargado del «Proyecto Ajedrez», nombre en clave del futuro PC, no sólo tenía que construir una máquina sino también equiparla con software. Así que se puso en contacto con Microsoft para incluir su Basic e interesarse por alguno de los otros lenguajes de la compañía, Fortran y Cobol. Como no estaban muy puestos en el mercado, preguntaron quién podía proporcionarles un sistema operativo. La respuesta era obvia, pero a Gates no le hacía mucha gracia decirla, porque sus relaciones con Digital Research se habían enfriado bastante desde que se llegaran a plantear una fusión año y medio antes. Tenían entonces un pacto tácito de no agresión según el cual Microsoft no hacía sistemas operativos y Digital Research se abstenía de vender lenguajes de programación. Pero en 1979 la empresa dirigida por Gary Kindall lo violó vendiendo un Basic propio.

Sin embargo, Gates hizo de tripas corazón y llamó a Kindall para decirle que le pasaba unos clientes, que volarían desde Seattle a California al día siguiente por la mañana y que por favor los tratara bien. No lo hizo. Lo que pasó aquel día nunca quedó demasiado claro. Sí sabemos que Kindall estuvo volando con su avión privado, según él en viaje de negocios. Aun así, asegura que llegó a tiempo para la reunión, ya por la tarde. La gente de IBM, en cambio, afirma que nunca le vieron la cara. En cualquier caso, pese al fiasco de aquel primer acercamiento, siguieron intentando llegar a un acuerdo, pero Kindall no estaba seguro de poder cumplir con los estrictos plazos del gigante azul: debía adaptar su CP/M para los nuevos procesadores de 16 bits de Intel y tener una primera versión preliminar para enero y no quiso comprometerse a ello, de modo que finalmente IBM volvió a llamar a la puerta de Bill Gates preguntándole si podía ofrecerles algo.

Bill Gates respondió que sí, que por supuesto, que cuándo firmaban. Su regla era siempre vender primero, aunque luego se incumplieran los plazos pactados y tuvieran que hacer una rebaja. La apuesta era muy arriesgada, porque el único contacto de Microsoft con los sistemas operativos era una adaptación de Unix para microordenadores llamada Xenix que vendían pero no habían desarrollado ellos: una operación producto de la rabieta que les entró cuando supieron que Digital Research vendía un Basic. Gates estimó que el sistema que necesitaba IBM no era tan complicado y lo podrían tener a tiempo. Se equivocaba. Pero le vino Dios a ver en la forma del QDOS.

Seattle Computer Products era una de las decenas de empresas que intentaban vender ordenadores personales en aquella época. Pero dos características la hicieron destacar sobre las demás: que estaba a veinte minutos en coche desde la sede de Microsoft y que, hartos de esperar a que Digital Research sacara una versión de CP/M para los nuevos y más rápidos procesadores de Intel de 16 bits, los 8086, decidieron crear un clon ellos mismos, el «rápido y sucio sistema operativo» o QDOS por sus siglas en inglés. En cuanto se enteró, Gates compró primero una licencia y luego el sistema completo y fichó a su programador Tim Patterson, que lo adaptó a las necesidades de IBM. Ah, también le cambiaron el nombre. Se llamaría MS-DOS.

El IBM PC salió a la venta en agosto de 1981 y sólo con la fuerza de la marca logró convertir al ordenador personal en algo respetable que las empresas podían y hasta debían comprar. Pronto se agotaron y tuvo que cuadruplicar su producción para atender a la demanda. Tanto la máquina como el sistema operativo se convirtieron en el estándar, y sus herederos aún continúan con nosotros, en nuestras casas y nuestras oficinas. Ningún fabricante salvo Apple logró sobrevivir a la estandarización.

IBM y Microsoft vivieron este proceso de formas bien distintas. La única pieza del PC realmente propia de IBM era la BIOS, un pequeño chip que reconoce las distintas partes del ordenador, cada una de su padre y su madre, y las pone en marcha y coordina antes de cargar el sistema operativo. Pronto fue copiado y, como las distintas piezas se podían comprar a sus respectivos fabricantes, pronto aparecieron los llamados clónicos, ordenadores capaces de ejecutar MS-DOS y que hacían las mismas funciones que los de IBM. Pero mucho más barato.

Microsoft, por su parte, se puso a vender su sistema operativo a todos estos fabricantes y creció como la espuma gracias a las ganancias. IBM nunca mostró ninguna intención de comprar ni el sistema operativo ni el Basic que la empresa de Seattle había desarrollado para el gigante azul por temor a las demandas: había perdido varios juicios por encargar programas a terceros, venderlos con su nombre y encontrarse después que el contratista había copiado parte del código de otros. Así que Bill Gates y Paul Allen se forraron vendiendo el MS-DOS tanto a IBM como a sus competidores: era la única pieza imprescindible para poder llamar PC a un PC.

Pero seguían teniendo dos problemas: que el sistema operativo era realmente cutre y que carecían de un entorno gráfico tan atractivo y fácil de usar como el del Macintosh de Apple. Todos nuestros amigos desarrollaron uno: Digital Research hizo el GEM, Microsoft lanzó Windows e IBM uno que llamó TopView. Fracasaron estrepitosamente, porque el PC era aún demasiado poco potente para poder ejecutarlos. Pero sólo Microsoft perseveró, pese a una infructuosa demanda de Apple por copiarles tan descaradamente como los de Steve Jobs le habían hecho a Xerox, hasta que la versión 3.0 alcanzó el éxito.

Sin embargo, Windows 3.0 seguía funcionando bajo el mismo y cutre MS-DOS de siempre. A partir de 1985, IBM y Microsoft empezaron a desarrollar conjuntamente un sucesor, al que llamarían OS/2. Pese a ser muy superior, fracasó por la misma razón por la que Microsoft estaba nadando en una montaña de dinero: porque por más cutre que fuera, MS-DOS era el estándar, y OS/2 era incompatible con él, es decir, no podía ejecutar los miles de aplicaciones y juegos que se habían desarrollado durante estos años para el PC.

El éxito de Windows 3.0 y el fracaso de OS/2 llevaron a Microsoft a divorciarse de IBM a comienzos de los años noventa. El gigante azul empezó a tener pérdidas poco después y tuvo que reinventarse a sí mismo como empresa de servicios para lograr sobrevivir; con el tiempo dejó incluso de fabricar los PC que había inventado. Microsoft, en cambio, gracias a las distintas versiones de Windows, convertido ya en sistema operativo en detrimento del MS-DOS con el que guardó la compatibilidad mucho tiempo, y a sus aplicaciones de ofimática, pasó a ser la primera empresa de informática del mundo.

El tercero en discordia, Digital Research, fue vendido a Novell en 1991, después de que lanzara varias versiones de DR-DOS, un sistema compatible con MS-DOS y, la verdad sea dicha, bastante mejor; tanto que Microsoft pensó en introducir falsos errores en Windows para que no funcionara con él. Kindall se pasó años teniendo que escuchar a todo el mundo que, de no haberse ido en avión aquella mañana, bien podría haber sido el hombre más rico el mundo. Murió en 1994 en una pelea en un bar de motoristas.

Allen se retiró a comienzos de los ochenta tras morir su padre y enfrentarse a un cáncer linfático. Pero siguió siendo amigo de Gates y permaneció en la junta directiva de Microsoft. Bill, el soltero más codiciado de su tiempo, se casó con una empleada en 1994 y se retiró en 2006 para dirigir junto a ella una fundación. Aun sin él, Microsoft sigue siendo la principal empresa de informática del mundo. Y eso sí que no es cuestión de suerte.