Salvo en el caso de las fotovoltaicas, una central eléctrica siempre tiene una parte mecánica destinada a producir un movimiento (un motor de gasoil, por ejemplo) y otra parte eléctrica que aprovecha ese movimiento para producir electricidad (un alternador, por ejemplo).

EL LADO ELÉCTRICO

En el lado eléctrico hay una dualidad práctica: los «alternadores» tienen muy buen rendimiento global y proporcionan corriente alterna, muy fácil de transformar en alta o baja tensión para el transporte y el consumo, aunque hay casos en los que en su lugar se utilizan «dinamos», que producen corriente continua, la cual, pese a ser mucho más difícil de transformar (para pasar de los voltajes altos o muy altos, adecuados para el transporte, a los 220 V del consumo doméstico), tiene ventajas en el transporte a grandes distancias, sobre todo mucho menores pérdidas por radiación.

EL FAMOSO EDISON PERDIÓ, EL EXTRAVAGANTE TESLA GANÓ

En el origen de la historia de la utilización de la electricidad ya compitieron dos de los mayores genios inventores de la historia reciente: Thomas Edison, partidario de la utilización de la corriente continua en la distribución eléctrica, y Nikola Tesla, con sus propuestas de corriente alterna. Tesla trabajó por un tiempo para Edison, que opinaba que su empleado era muy trabajador pero que sus ideas no tenían aplicación práctica y por eso Edison perdió, y perdió mucho dinero, porque la corriente continua, como acabamos de decir, sólo tiene ventajas en la transmisión a muy grandes distancias[23].

Edison vendió sus patentes a una gente de Schenectady, un pueblo de Nueva York y esa empresa hoy se llama General Electric Co., pero ahora todos tenemos corriente alterna en nuestras casas porque Tesla, que le vendió sus patentes a otra empresa, la de un tal George Westinghouse, tenía razón y sus ideas eran muy prácticas, como el fluorescente, la radio (cuya invención se adjudicó al principio a Marconi, pero finalmente se reconoció que Tesla había publicado esas ideas antes que el italiano), el mando a distancia vía radio, la teoría del radar y unos cuantos más.

Entre tanta genialidad Tesla también «dio a luz» otros inventos extravagantes que cimentan su aureola de chiflado como, por ejemplo, un aparato para comunicar con los extraterrestres (recibió un mensaje de Marte cuando lo probaba en Colorado), el «Rayo de la Muerte», que derribaba aviones a cuatrocientos kilómetros de distancia o un generador de terremotos que se fue al campo a probar para no destruir Nueva York. Pero aparte de esto, casi todo lo que hoy comercializa General Electric Co. está basado en las patentes de Tesla, no en las de Edison.

Volviendo a las centrales eléctricas, en el lado en el que se produce la electricidad, ya sea por alternadores o por dinamos, lo más grave que puede pasar es que salten chispazos. Pueden matar a todo el que esté cerca u ocasionar un incendio grave, y si lo que sucede es que revienta un transformador, puede que alguien se entere de que están construidos y rellenos de sustancias bastante tóxicas. Sin embargo, para la mayor parte de la «opinión pública» serían unos «chispazos», conceptualmente no muy distintos de los del enchufe de casa, por lo que se entenderían como un accidente más o menos grave y por su proximidad a lo cotidiano generarían muy poca alarma.

Es el mismo caso de un accidente de coche, que es algo triste e incluso trágico, pero que no suele generar un cambio de legislación o, siquiera, de comportamiento de los conductores. Mientras tanto, un accidente aéreo, incluso de un helicóptero, aunque no cause víctimas, obliga a una exhaustiva investigación de lo sucedido y muchas veces a una recomendación de modificaciones a la normativa de seguridad de esos vehículos o, en ocasiones, a una disminución apreciable de la ocupación de las líneas aéreas si el accidente ha tenido muchas víctimas o se ha publicitado con intensidad informativa.

EL LADO MECÁNICO DE LAS CENTRALES ELÉCTRICAS

Salimos ahora, pues, de la zona eléctrica de las centrales, más comprensible para la mayoría, y entramos en la que suele dar más que hablar.

En el lado mecánico de las centrales eléctricas la variedad de soluciones es mucho mayor, con su correspondiente diversidad de problemas y riesgos. Antes de entrar en su descripción, pongamos unas cifras que por su simplicidad dan una imagen inmediata de la situación, pero que, por la misma simplicidad, se podrían matizar hasta la náusea: el «precio» de la electricidad producida. Lo ponemos sólo para dar una idea del orden de magnitud de las diferencias.

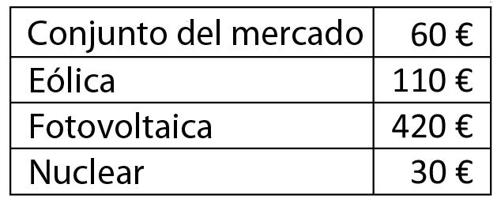

La primera tabla se refiere a precios de 2008 en el mercado español peninsular y es el precio medio del megavatio/hora:

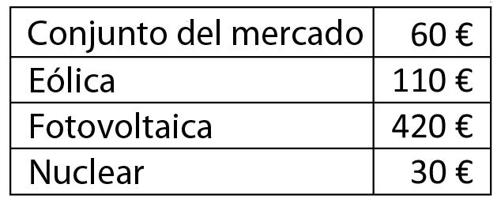

Por supuesto, hay muchas cifras disponibles, evolucionan en el tiempo y no todas coinciden. Por ejemplo, en 2009 (Fuente: periódico El País), se daban estas otras:

También habría que deslindar de estos costes las subvenciones nacionales o locales a determinadas tecnologías, por ejemplo, pero la imagen general muy clara es que el precio medio del conjunto del mercado está determinado, sobre todo, por las centrales térmicas de gas/petróleo/carbón, que son mayoritarias en España; que la nuclear es la económicamente más rentable, y que la eólica tiene un coste todavía superior a la producida en centrales de ciclo combinado cuyo precio, con el tiempo, irá subiendo a la par que lo haga el precio del petróleo, gas, etcétera.

Vamos ahora a trazar una somera comparación de las distintas tecnologías de producción de electricidad, con la idea clara de que cada una de ellas tiene ventajas y desventajas (todo tiene un precio).

EÓLICAS

Cuando el lado mecánico de la central se impulsa con el viento (las centrales eólicas, quizá las más inocuas de todas), las aspas de los molinos de viento son un peligro para las aves y la inversión en terrenos y torres se ve escasamente recompensada por la cantidad de energía que producen y lo errático de su rendimiento, que hace imprescindible otro tipo de centrales para «garantizar», en los momentos sin viento, el «total» del consumo.

EL PROBLEMA DE LAS CENTRALES IMPREDECIBLES

Esto último es muy importante: ningún país puede aspirar a obtener la mayor parte de su energía del viento (o el sol) sin asumir que puede haber días, incluso semanas, sin corriente eléctrica en los hogares y fábricas. Por ello, por mucho que se invierta en este tipo de energías (inversión indudablemente provechosa en términos ecológicos), siempre tendrá que haber, además, otro tipo de centrales eléctricas disponibles y en una cantidad que garantice el total de la demanda.

Por poner un ejemplo numérico, si un país (o región, o zona eléctrica) consume cien gigavatios y planifica que el 50% de su energía tendrá origen eólico (o hidráulico o de otro tipo), deberá construir centrales eólicas para suministrar cincuenta gigavatios o más y, además, mantener centrales eléctricas de otro tipo (carbón, gas, petróleo, nuclear, etc.) para suministrar el total de cien gigavatios cuando no haya viento y sólo cincuenta gigavatios cuando sí lo haya. Sus instalaciones estarán dimensionadas para suministrar hasta ciento cincuenta gigavatios si hiciera falta algún día, pero la mayor parte del tiempo la mitad de sus instalaciones no eólicas estarán paradas y todo eso supone un coste que hay que repartir entre el conjunto de los consumidores.

Por supuesto, cuando se trabaja con grandes cifras se puede suponer que, estadísticamente, es muy difícil que todos los aerogeneradores estén parados a la vez, y apoyándonos en esa genial idea relajar un poco los requisitos, manteniendo nada más que ochenta gigavatios no eólicos disponibles (por ejemplo), pero esa forma de hacer las cosas, estadísticamente también, lleva a que algún día, cada pocos años, la sobrecarga del consumo produce esos espectaculares apagones que dejan una región entera sin electricidad durante largas horas.

Un dato: en España, el 16 de mayo de 2009 había dieciséis mil megavatios eólicos instalados y, en pleno anticiclón, sólo produjeron trescientos en todo el día.

PRESAS HIDROELÉCTRICAS (O NO)

En las centrales hidráulicas, el movimiento mecánico se consigue dejando caer agua desde un depósito superior (presa, río de montaña, etc.) hacia el cauce inferior a través de una turbina. Aparte de las consideraciones ambientales relacionadas con la limitada disponibilidad de agua, están también los cambios en los ecosistemas, a veces terribles, para las especies que pueblan los ríos, o la destrucción de muchas hectáreas de terreno para la construcción de bonitos lagos artificiales (bonitos, pero estériles en la mayoría de los casos) y que dan lugar a interminables demandas que afectan a sociedades rurales enteras. ¿Se acuerda alguien de Riaño[24]?

En resumen, los peligros de esta tecnología, aparte de perder la productividad agrícola de grandes extensiones de terreno, se limitan a la posibilidad de que la presa se colapse, lo que suele tener consecuencias fatales para las poblaciones de bastantes kilómetros río abajo. De nuevo, es un peligro fácil de comprender, y suele ocasionar una razonada oposición social que se termina plasmando en planes de alarma, de evacuación o de compensación por los riesgos y no llega judicialmente más lejos, aunque se prolongue en el tiempo.

Porque esta tecnología tiene una característica que le es propia: una central eólica se puede desmantelar, una térmica se puede apagar e incluso desmontar, pero una hidráulica determina el paisaje para muchas generaciones (la presa Proserpina, en Mérida, data de finales del siglo I) y, para colmo, el resultado es bonito, bucólico; no parece que nada malo pueda provenir de un lago tranquilo rodeado de campos fértiles, pero…

LAS GRANDES PRESAS ENCOGEN Y SE DILATAN CON LAS TEMPERATURAS

En la Comunidad de Madrid más o menos la mitad del agua potable que se distribuye proviene del embalse del Atazar, en el norte de la región, un enorme lago artificial rodeado de montañas cuya contemplación produce paz y permite a los excursionistas de fin de semana volver el lunes a sus trabajos con la sensación de haber pasado un día en la naturaleza. Lo que no saben es que si la presa del embalse se rompiese, la inundación llegaría a las principales avenidas de la capital, y esa posibilidad no es demasiado remota.

Por ejemplo, si se mira con atención, se puede ver que la propia presa tiene varias pequeñas grietas por las que rezuma el agua, a veces (sobre todo en invierno) con un caudal apreciable. Tuvo que ser reparada poco después de su inauguración con resinas específicas y se realiza un seguimiento continuo del estado de la estructura: dentro de la masa de hormigón posee multitud de sensores que fueron dejados allí durante el proceso de construcción y cuyos cables acaban en paneles que muestran las presiones y tensiones de cada punto y son vigilados en todo momento. Las grietas en una obra de ese tamaño no son buenas, aunque tampoco son fáciles de evitar por completo.

Pero no es ese el detalle más preocupante de la presa del Atazar, pues casi todas las grandes presas tienen alguna grietecilla. A cualquiera que se acerque al embalse del Atazar al final de un invierno lluvioso le puede extrañar que no esté lleno hasta rebosar.

—¿No es esta presa para almacenar el agua del invierno y que la bebamos en el verano?

—Sí, para eso se construyó.

—Pues entonces debería llenarse con las lluvias del invierno, ¿no?

Pues sí, pero sólo se puede llenar del todo a partir de la primavera, porque en invierno, con las bajas temperaturas, la enorme bóveda de hormigón que se apoya en las paredes del valle para sujetar la masa de agua está fría, contraída, encogida, y no apoya con la fuerza necesaria en los laterales: cada año hay que esperar a que suban las temperaturas, se dilate y se encaje con fuerza en las laderas de los montes de los lados para sólo entonces dejar que almacene las lluvias de primavera y, si son abundantes, se llena; si no, mala suerte.

En enero de 1959 en Ribadelago, provincia de Zamora, no se tuvo esa precaución (presa fría, pero llena hasta el borde en una noche muy lluviosa) y la presa, construida con materiales de baja calidad, reventó llevándose por delante casi todas las casas (habitantes incluidos, por desgracia) hasta el lago de Sanabria, que absorbió el envite amortiguando el efecto río abajo. La (media) presa que quedó en pie es hoy un curioso y terrible monumento en mitad del valle.

En el Atazar se reforzaron los laterales con más hormigón y, en una presa que se hizo de bóveda para ahorrar este material, en el margen izquierdo se tuvo que utilizar diez veces más hormigón que en la propia presa. Por cierto, es la última que inauguró Francisco Franco (en 1972).

LAS GRANDES PRESAS NECESITAN ESTAR SIEMPRE ATENDIDAS

En el extremo contrario, tampoco es aceptable dejar que el Atazar se vacíe por completo puesto que es una presa «de bóveda», un arco pensado para sostenerse frente a la presión del agua que lo empuja (brutalmente) «desde atrás», para lo cual ese arco de miles de metros cuadrados está incluso inclinado hacia «atrás» (hacia donde le viene el empuje del agua) para aprovechar su peso en la tarea de resistir la presión. Lo malo sería que ese empuje desapareciese: si una presa de bóveda se vacía del todo, el hormigón deja de estar «comprimido» por el agua y pasa a estar «colgando» sobre el cauce; y el hormigón trabaja muy bien en compresión, pero muy mal en extensión. Todos intuimos que si nos apoyamos en una columna de hormigón, el material reacciona de manera muy diferente a si tirásemos de esa masa de hormigón hacia arriba: casi vemos surgir las grietas.

Si una presa de ese tamaño por tanto se vacía, le salen grietas. Y si se llena del todo cuando está fría, hay riesgos de que los montes de los lados no tengan la resistencia suficiente como para no evitar las filtraciones y estas crezcan de manera catastrófica.

A pocos kilómetros de la del Atazar está la presa de la Oliva, construida en el siglo XVIII con unas pocas decenas de metros de altura y anchura y que resultó un fracaso por presentar más o menos los mismos problemas que la del Atazar sin que las técnicas de aquella época permitieran resolverlos y, en algún caso, ni siquiera diagnosticarlos correctamente. Fue abandonada al poco de terminarse por exceso de filtraciones y ahora su única utilidad es como trampolín para los jóvenes que se bañan en el pequeño lago que suele quedar a sus pies durante el verano.

Pero el Atazar no es como la Oliva: una presa gigante no es una masa inerte que pueda dejarse descuidada. Si dejásemos de mantenerla, seguramente habría que dinamitarla para evitar que unos pocos años después, durante algún invierno muy lluvioso, la ciudad de Madrid (y todo lo que hubiere en los sesenta kilómetros antes de llegar a la capital y quién sabe cuántos más cauce abajo) fuese borrado del mapa en un desastre que, en conjunto, no tendría mucho que envidiar a una explosión nuclear.

SOBRE TODO EN DÍAS DE TORMENTA

La primera catástrofe que en España se recuerda si hablamos de presas rotas es la de Tous, que en Valencia provocó inundaciones y muertes cuando en una noche de «gota fría» de 1982 se desbordó. Sin embargo no fue un problema tecnológico sino de grave irresponsabilidad por parte de algunos funcionarios, que no advirtieron correctamente del riesgo meteorológico y no destinaron personal de guardia que pudiese abrir las esclusas de la presa por la noche (a nadie le gusta ese turno) pese a ser octubre la temporada de máximo riesgo: la presa, de piedras sueltas y arena, se desbordó por arriba y el agua fue abriendo un surco que con el aumento del caudal crecía peligrosamente.

LAS PRESAS CAMBIAN LA GEOLOGÍA A SU ALREDEDOR

Desbordarse o romperse no son las únicas maneras en que una construcción de ese tipo puede hacer daño, incluso sin necesidad de saltar a las portadas de los periódicos. Por ejemplo, en la soleada California, la mayor parte del agua potable y no poca energía la produce la presa Hoover, una inmensa masa de agua a cientos de kilómetros de Los Ángeles, construida en una zona famosa por sus terremotos y sus fallas subterráneas que separan placas tectónicas cuyo movimiento hay que vigilar muy de cerca. En esas fallas los movimientos telúricos del terreno hacen que una placa se desplace unos centímetros cada pocos años, pero que se enganche con otra durante un tiempo, a veces siglos y, cuando la tensión es excesiva o ambas se desenganchan de repente por cualquier motivo, se produzca otro terremoto.

Pues bien, la presa Hoover, con sus kilómetros cúbicos de agua concentrada en unos cientos de kilómetros cuadrados, ha hecho que las filtraciones y las corrientes subterráneas aumenten y sigan caminos hasta ahora inéditos, incluso a través de las propias fallas, las cuales resultan lubricadas de forma diferente a como lo estaban antes y, como consecuencia, han producido un espectacular aumento en el número de microterremotos en la zona.

Y LA BIOLOGÍA

En el otro extremo del mapa, tanto desde el punto de vista geográfico como desde el social y político, la presa de Asuán, en Egipto, produce más de dos gigavatios de potencia eléctrica y ha eliminado, parece que para siempre, los ciclos de inundaciones y sequías del valle del Nilo; pero también, aparte de tener que trasladar importantísimos monumentos de la Antigüedad egipcia, ha provocado la proliferación de mosquitos hasta la náusea y que muchas especies, por el contrario, se hayan visto empujadas hacia la desaparición, tanto en el río como en el delta, pues el descenso neto de caudal (ahora se aprovecha casi todo lo posible para riegos) ha hecho que el delta se vea invadido por el Mediterráneo de forma constante y su salinidad ha acabado también con los cultivos de una extensa zona alrededor de la otrora fértil Alejandría. Para colmo, durante la última guerra entre Egipto e Israel se temió que se considerase la presa como objetivo militar, pues una bomba nuclear podría haberla destruido.

Y CONVIERTEN EN BARRO LOS CIMIENTOS DE LAS MONTAÑAS

Incluso a veces, sin necesidad de guerras, lo que sucede es algo violento y que llega al nivel de tragedia. Justo cien kilómetros al norte de Venecia, cerca de Codissago, se construyó en los años cincuenta y sesenta la presa de Vajont, una preciosidad de más de doscientos metros de altura encajada entre laderas escarpadas. El problema allí fue, sobre todo, que al llenarse el embalse (por tercera vez: hicieron varias pruebas llenando y vaciando por completo el embalse y eso empeoró el problema) el aumento de la humedad en las laderas provocó un deslizamiento gradual del monte Toc (toc, en el dialecto de la zona, quiere decir ‘trozo’: algo disgregado y suelto).

La noche del 9 de octubre de 1963, justo cuando el Real Madrid estaba marcando un 6 a 0 al Glasgow Rangers en la copa de Europa, y con todos los vecinos pegados a las pocas televisiones que había, el deslizamiento de tierras se aceleró hasta adquirir proporciones monstruosas: fue tal el volumen de barro y rocas desmoronándose que en unos cuarenta y cinco segundos llenó el embalse avanzando a ochenta kilómetros por hora. El agua saltó valle abajo en una ola de doscientos cincuenta metros de altura que es fácil suponer que causó muy graves destrozos en Codissago y más allá. Pero es que incluso el viento que levantó provocó daños en los alrededores. Hubo cerca de dos mil muertos.

Como siempre, si se analizan las cosas después de la catástrofe aparecen multitud de síntomas de que era inevitable. Por ejemplo, años antes de la tragedia una periodista fue formalmente acusada en un juicio por alarmismo y varios otros pecados porque decía que aquello podía suceder; en el juicio fue declarada inocente porque sus afirmaciones y conclusiones eran exactas y, sin embargo, pese a decirlo un juez no se hizo gran cosa por resolver el problema.

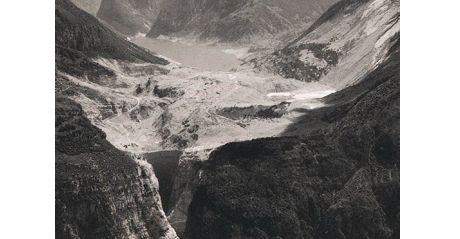

La presa de Vajont, justo después de la catástrofe.

Se planificó incluso un túnel bajo la montaña que después se desplomó, con la intención de drenar la humedad y que, una vez seca, se mantuviese estable, pero aquello no acabó bien. Se llegaron a fotografiar grietas de cientos de metros en el monte pero no se desalojó a la población río abajo porque, simplemente, no se concebía que el desastre alcanzase tamaña magnitud. Curiosamente, la propia presa de Vajont resistió el impacto aunque, evidentemente, llena de piedras ya no produjo electricidad.

QUITARON UN MAR DE LA GEOGRAFÍA DE ASIA

¿Más problemas de los que podamos culpar a las presas? Sí, por supuesto: tienen la culpa de que el mar de Aral haya desaparecido de los mapas.

El mar de Aral era uno de los mayores del planeta. No era muy profundo, pero sí tan extenso como para que junto con el mar Caspio lo tuviésemos que estudiar cuando tocaba la geografía de Asia, aunque el Baikal, pese a sus mil setecientos metros de profundidad, a sus misteriosas focas y a almacenar casi un cuarto de toda el agua dulce del planeta se quedaba en la categoría de «lago».

En las aguas del Aral navegaban flotas enteras de pesqueros que mantenían una potente industria de conservación de pescado que se exportaba a todo el mundo socialista, pero sus alrededores eran bastante estériles. Lo alimentaban los ríos Sir Daria (el más largo de Asia Central) y Amu Daria, alimentados ambos desde lejos por las nieves de las últimas estribaciones occidentales del Himalaya.

Pero a mediados del siglo XX a los responsables de la economía centralizada de la Unión de Repúblicas Socialistas Soviéticas se les ocurrió una idea faraónica y aparentemente brillante, muy del estilo de tantas otras iniciativas que surgen en despachos poblados por políticos profesionales, menos preocupados por la opinión de los técnicos independientes que de tener ocasión de hacer declaraciones espectaculares en la prensa. La idea fue utilizar de forma intensiva el caudal de los ríos Sir Daria y Amu Daria para irrigar campos de algodón y, de paso, las presas que había que construir para esos regadíos podrían producir una interesante cantidad de electricidad que terminaría de llevar esos territorios hasta la era industrial.

La idea no era mala y, de hecho, en esas zonas de Uzbekistán y Kazajistán se produce ahora una importante cantidad de algodón. Lo malo es que casi nada es gratis y la utilización de tanta agua en regadíos, que se evaporaba en los campos antes de llegar al mar de Aral, hizo que el nivel de este descendiese unos veinte metros en pocas décadas.

El resultado (aparte de las toneladas de algodón y los kilovatios de electricidad, por supuesto) es que el mar de Aral ha pasado de tener sesenta y ocho mil kilómetros cuadrados en 1960 a sólo veintiún mil en 2010, que el clima de la zona ha pasado a ser muy acusadamente continental, con primaveras y otoños casi indetectables, que han aumentado las tormentas de arena, que enfermedades como el asma, la bronquitis, el cólera, el tifus o la gastritis han brotado en la zona con la fuerza de epidemias y, sobre todo, que la pesca casi ha desaparecido, con especies enteras exterminadas por la disminución de la superficie y cuadruplicación de su salinidad y concentración de metales pesados.

En los últimos años de la Unión Soviética, en un intento de mantener viva la industria conservera de la zona, se organizó todo un sistema de transporte específico para llegar hasta el centro de las llanuras de Asia Central con trenes de pescado desde el mar Báltico, con el fin de que, en lo que unos años antes era la orilla del mar de Aral lo metieran en latas de conserva. Obviamente, ese patético intento de decir «aquí no pasa nada» no sobrevivió al colapso del comunismo en la zona y ahora lo que nos llega de allí, además de algodón para nuestros pantalones vaqueros, son espectaculares fotos de grandes barcos varados en mitad de una inmensa llanura desértica donde ningún otro síntoma nos hace sospechar que allí hubo una vez un mar.

También en España, por cierto, las presas que se construyeron para regular el cauce del Guadalquivir causaron que a mediados del siglo XX se extinguiese una especie curiosa, valiosa e irrecuperable: el esturión del Guadalquivir que, aunque no daba un caviar tan famoso como el del Volga, supone una pérdida que también puede calificarse como desastrosa.

COMBUSTIBLES FÓSILES

En las centrales eléctricas movidas por carbón, gas o petróleo, como es fácil comprender, el movimiento se obtiene en la parte mecánica de la central por medio de un motor. No debemos, sin embargo, imaginar un motor diésel gigantesco: lo habitual, para las potencias requeridas, es que el combustible mueva una turbina más o menos parecida a los motores de aviación o, sobre todo en el caso del carbón, se caliente agua hasta obtener vapor y sea ese vapor el que, a gran presión, mueva la turbina.

En las centrales de ciclo combinado lo que sucede es que se utilizan las dos técnicas a la vez: queman gas para acelerar una turbina y el calor resultante lo utilizan para producir vapor y mover con él otra. Son las más eficientes: es como si aprovechásemos el calor del tubo de escape de nuestro coche para obtener más potencia, pero en el caso de motores que llenan edificios enteros, el «tubo de escape» tiene más calor que el de nuestro coche.

Las centrales movidas por carbón, petróleo o las más optimizadas de ciclo combinado son, de forma obvia, unas de las mayores contaminadoras del planeta y las causantes de una parte muy significativa del efecto invernadero y el cambio climático.

CONTAMINACIÓN DE NIVEL INDUSTRIAL

Por poner un ejemplo, en Europa quizá la industria concreta e individualizada más contaminante (para la atmósfera) ha sido en los últimos tiempos la central eléctrica de Andorra, una población de Teruel. Pensada para ser cargada de carbón sudafricano con una pequeña mezcla de carbón asturiano, hasta tal punto es significativa su contribución a la lluvia ácida centroeuropea que cuando cambia la composición del carbón con que se alimenta (por problemas de suministro o para ahorrar en las importaciones energéticas) y se aumenta el porcentaje de carbón asturiano (mucho más cargado que el carbón sudafricano en cuanto a azufre y otros contaminantes) quienes lo detectan y levantan la protesta son los servicios medioambientales suecos o alemanes, que es donde la lluvia suele hacer caer los azufres y dioxinas generados en Teruel.

Este es el aspecto que tiene en Google la central de Andorra (Teruel). Las tres chimeneas más gruesas son inofensivas: sólo sale vapor de agua; la chimenea estilizada y más alta es la causante de muchos problemas medioambientales a lo largo de toda Europa.

A estas emisiones y al dióxido de carbono hay que añadir las de dióxido sulfúrico, óxido de nitrógeno, ácido hidroclórico y componentes de manganeso y de arsénico, entre otros veinte subproductos nocivos para la salud.

Pero para colmo, las miles de toneladas de carbón que allí se queman a lo largo de los meses contienen una pequeña dosis de radioactividad (como cualquier material de la naturaleza) y la suma de los elementos radioactivos vertidos a la atmósfera sólo en esa central eléctrica turolense superan en mucho la de todas las centrales nucleares de la península ibérica en el mismo período. Pero esa radioactividad, como no procede de una central nuclear, no alarma a nadie pese a que unos isótopos radioactivos son igual de dañinos que otros, puesto que son los mismos independientemente de cómo los soltemos a la atmósfera.

CON EL TIEMPO DESAPARECERÁ EL PROBLEMA… Y LA ENERGÍA DISPONIBLE

Por otro lado el combustible necesario para las centrales eléctricas no va a estar disponible mucho tiempo, salvo en el caso del carbón (unos doscientos años durarán las reservas de carbón conocidas); en el caso del gas se empezará a agotar, previsiblemente, entre 2050 y 2075 y el petróleo quizá escasee antes. Aunque es difícil predecir el grado de utilización de las reservas cartografiadas, pues siempre hay alguien que confía en que se seguirán descubriendo nuevas bolsas de gas o petróleo de forma indefinida.

En 2010 una compañía española hizo mucha publicidad del descubrimiento de un nuevo yacimiento en la costa de Brasil, el mayor descubrimiento de los últimos años, con millones de barriles, etc. Eso está muy bien para varias cosas, entre otras para que suba la cotización de las acciones de esa petrolera (para eso hacían tanta publicidad y, por supuesto, consiguieron subir en la Bolsa); pero si analizamos las cifras, ese gran descubrimiento, el mayor en mucho tiempo, sólo alarga «un año» el reinado del petróleo en este mundo cada vez más «civilizado»: haría falta un descubrimiento así de excepcional «cada año» para poder mantener el consumo sin agotar las existencias.

El asunto es más complejo en el caso del carbón, porque no se puede saber quién ganará el conflicto entre los que proponen quemar la menor cantidad posible de carbón, por fundamentadas razones ecológicas, y los gobernantes de países emergentes como China e India, con grandes reservas, enormes necesidades energéticas y una tentación irresistible de aportar prosperidad a sus ciudadanos (unos dos mil quinientos millones entre los dos países) a costa de que sean los países ricos los que inviertan grandes sumas en disminuir sus vertidos de CO2 a la atmósfera. En 2011 los planes energéticos chinos incluían poner en marcha centrales como la de Andorra al monstruoso ritmo de una por semana.

En los años setenta del siglo XX era todavía corriente en España que las fábricas, y no sólo las químicas, vertiesen a la atmósfera sus gases más tóxicos sin otra precaución que hacerlo de madrugada y advertir a la población de que no circulase por los aledaños más allá de la medianoche. Es de imaginar que los países que ahora vierten ingentes cantidades de CO2 a la atmósfera vayan adquiriendo con los años una conciencia ecológica más consistente, al igual que va sucediendo en el mundo occidental.

NUCLEARES

Y llegamos a las centrales nucleares. En primer lugar hay que entender que estas tienen una potencia por lo general mucho mayor que las alimentadas por carbón, gas o petróleo, que a su vez son mucho mayores (por el momento) que las eólicas o hidráulicas. Ese gran tamaño es, en sí mismo, un rasgo importante.

Desde un punto de vista esquemático, no son más que una central eléctrica en la que el movimiento mecánico se produce con una máquina (una turbina) de vapor que se obtiene de una olla a presión, que produce ese vapor aprovechando el calor de las reacciones nucleares en lugar de quemando combustibles químicos. Pero tiene unas cuantas peculiaridades. Para empezar es una olla enorme. En la mayoría de las centrales nucleares la «olla» tiene varios pisos de altura.

HAY QUE SEPARAR LO DE DENTRO Y LO DE FUERA

Pero además, y sobre todo, lo que hay dentro de la olla es radioactivo, lo cual quiere decir que es algo que, en dosis por encima de ciertos niveles (y allí dentro está muy por encima de esos niveles) resulta mortal. Como consecuencia de ello es bueno controlar muy bien lo que está dentro y, en lo posible, separarlo muy claramente de lo que está fuera de la olla, y nunca dejar que lo de dentro salga para nada.

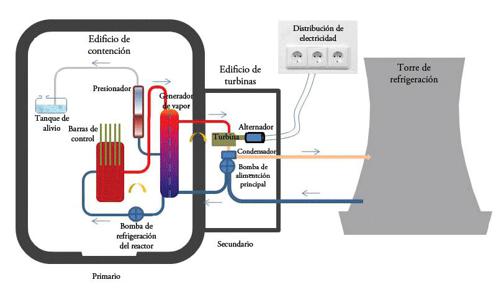

Pero esa olla, que se suele llamar «la vasija», tiene que producir vapor, y ese vapor mover una dinamo o un alternador. Ya que no se puede sacar fuera el vapor que se produce dentro, una opción podría ser meter la turbina y la dinamo dentro y que de la olla sólo saliesen los cables eléctricos con la electricidad. Así se hace en algunos casos. Pero las presiones, las temperaturas del interior de la vasija y la corrosión derivada de esas presiones y temperaturas convierten en poco recomendable hacer trabajar equipos complejos en el interior, por lo que lo normal es que en el interior sólo quede el núcleo (nombre formal con que se suele denominar a la parte de la «olla» en la que reacciona el combustible nuclear, el uranio o plutonio), que produce una enorme cantidad de calor, el cual calienta agua que circula y se lleva de allí el calor. El agua suele tener además la tarea de «frenar» los neutrones para que sean útiles en la reacción atómica; pero eso lo aclararemos mejor al hablar del accidente de Chernóbil para no alargar en exceso esta introducción.

Luego, con esa agua muy caliente, se calienta otro circuito de agua, que se vaporiza, pero que no ha estado nunca dentro de la vasija y que, por lo tanto, no ha recibido radiaciones y es inocua (salvo por la temperatura).

Hay un intercambio de calor entre el primario (el circuito de agua que ha circulado por el núcleo, del que sale a unos 325o C) y el secundario (el agua calentada por el agua del primario), cuyo vapor mueve la turbina; pero, salvo que las cosas vayan escandalosamente mal, el secundario está limpio e impoluto de radioactividad. Y la electricidad que sale de allí es indistinguible de la obtenida por cualquier otro medio.

MUCHA ENERGÍA QUE SE CONFÍA EN QUE SALGA DE ALLÍ

En una simplificación muy llamativa, en la línea de la famosa frase que afirma que «la energía ni se crea ni se destruye, tan sólo se transforma», hemos convertido radiación en calor, calor en electricidad, y la electricidad nos la llevamos de allí.

El agua que está dentro de la vasija, en el interior del edificio de contención, forma lo que se llama circuito primario y, como se la considera radioactiva, no sale de él sin controles muy estrictos (aunque es una radiación de «vida corta», por lo que cuando se saca de allí basta con mantener su aislamiento por un plazo limitado para que deje de tener algún peligro para la salud). El agua/vapor calentada por la del circuito primario, que ha recibido ese calor a través de paredes que dejan pasar el calor pero no la radiación, sí que se puede utilizar con cierta libertad para mover una turbina y producir electricidad; es, como decimos, el circuito secundario.

Una parte que a veces ha sido crítica en el circuito primario son las bombas de alta presión que hacen circular el agua. Es un sistema que tiene cierta complejidad, pues a las bombas hay que añadir un depósito auxiliar que mantenga la presión dentro de ciertos márgenes, con sus correspondientes válvulas de seguridad para casos de sobrepresión y que está conectado a un «tanque de alivio» para cuando, por ejemplo, hay que vaciarlo como parte de un mantenimiento. Volveremos a hablar de estos elementos al contar el accidente de Harrisburg/Three Mile Island (TMI).

LA VASIJA: GRANDE Y VITAL

El tamaño de la vasija es, por lo tanto, el necesario para contener las barras de uranio, por lo normal de cinco metros de longitud, más el margen para sus sujeciones y para que circule el agua de refrigeración que, al sacar el calor de la vasija, es la que calienta el circuito secundario y mantiene el flujo de la energía nuclear-térmica-eléctrica que a la postre define la central. No es un rascacielos, pero sí un edificio de cómo mínimo dos o tres plantas.

Ese tamaño es extrapolable, en el caso de las centrales refrigeradas por agua (pronto hablaremos de otras opciones), a centrales mucho mayores y, lo que es en la práctica mucho más importante, a centrales mucho menores. Las primeras centrales se construyeron para potencias de ciento cincuenta megavatios, pero fueron creciendo hasta un tamaño típico de mil megavatios eléctricos que, con un rendimiento normalmente del orden del 30%, quiere decir que producen algo más de tres mil megavatios de calor y que el 30% de esa energía se transforma en electricidad efectiva. Comparado con otros tipos de centrales es un buen rendimiento.

Pero la razón de que se adoptara este modelo, tanto en occidente como en el bloque socialista, no fue su rendimiento ni su tamaño máximo, sino que en su tamaño mínimo se podían construir centrales lo suficientemente pequeñas como para ser embutidas en el casco de un submarino.

LA REFRIGERACIÓN

Hay formas de obtener mayores rendimientos energéticos de una central nuclear, lo cual pasa por hacer trabajar al circuito primario a mayores temperaturas. Esto, en el caso de centrales refrigeradas por agua, implicaría unas presiones de vapor inaceptables.

Se podría pensar en trabajar con vapor de agua y de hecho hay muchas centrales que trabajan así, pero a temperaturas sólo un poco mayores que las de trabajo normal se corre el riesgo de que las moléculas de agua se descompongan en oxígeno (que, tan caliente, oxidaría cualquier cosa que se encontrase) e hidrógeno, que más adelante veremos lo que puede llegar a incordiar.

Sí que hay unas cuantas centrales refrigeradas por anhídrido carbónico, más estable que el vapor de agua, e incluso helio, que es lo más estable que podemos imaginar, aunque escaso y caro. Y en unas pocas ocasiones se recurre a otros líquidos: por ejemplo el sodio. El sodio es un metal con un punto de fusión bastante bajo: a unos noventa y ocho grados centígrados ya es líquido y, como tal, permanece fluido y estable en una amplia gama de temperaturas. Es lo que se utiliza en las centrales «rápidas» o «breeder» (Fast Breeder Reactor, FBR).

Estas centrales fueron objeto en los años setenta de campañas muy activas en contra de su desarrollo porque en ellas se da la sorprendente circunstancia de que, con un control adecuado de su funcionamiento, «producen más combustible del que consumen», puesto que se rodea el núcleo con barras de uranio no enriquecido y torio fisible (su isótopo de «peso atómico» 233) que, por la radiación recibida durante la producción de electricidad se convierte en uranio radioactivo y, por lo tanto, utilizable para alimentar otras centrales; también se pueden diseñar para producir plutonio y son los militares los que se encargan de llevarse los residuos para hacer bombas: de ahí las críticas que recibía esta tecnología.

Los modelos experimentales venían funcionando desde los años cincuenta con suerte muy variada: por ejemplo, los alemanes nunca consiguieron alcanzar el punto crítico de generar energía neta (hacer funcionar un reactor nuclear no es tarea sencilla). Cerca de Detroit se construyó uno de estos reactores reproductores, en Laguna Beach, Michigan, y funcionó desde 1963 hasta el 5 de octubre de 1966, día en el que una pieza de circonio atascó los inyectores de sodio refrigerante y la temperatura se elevó peligrosamente. Hubo que enfriar todo, limpiar y estudiar lo que había pasado, y así en 1968 localizaron la pieza y resolvieron el problema, pero mientras tanto había aparecido un libro titulado Casi perdimos Detroit (con ese título no hay que insistir en que era alarmista) y también una canción, y aunque volvió a funcionar, le denegaron la renovación de la licencia de explotación en 1972 y se cerró.

También acabaron cerrando los reactores de Francia y Reino Unido, en los que además de las presiones políticas influyó el hecho de que el mantenimiento era más costoso que el de los sistemas de agua a presión, fundamentalmente por los metales licuados que los refrigeran y cuyos escapes suelen ser problemáticos.

Porque aunque el sodio parece ideal para refrigerar una central nuclear, tiene su propia lista de inconvenientes, el principal de los cuales es que reacciona de una forma explosiva con el agua: es otro de los típicos ejemplos de que un experimento de química «de andar por casa» acaba con la habitación hecha un desastre y el científico aficionado dando explicaciones en el comedor con las pestañas quemadas. En otro orden de magnitud, muchos españoles recordarán el incidente del Casón.

UN ACCIDENTE EN LO QUE YA ANTES SE LLAMABA LA «COSTA DE LA MUERTE»

El Casón fue un barco «panameño» que se encontró con un grave problema de desplazamiento de la carga cuando navegaba frente a las costas gallegas en 1987. Escorado frente a la costa, podía haber sido uno más de los naufragios de la «Costa de la Muerte» (uno de los trágicos, con veintitrés muertos entre la tripulación), salvo por el detalle de que su carga la formaban, entre otras finuras, varios cientos de toneladas de sodio.

El metal viajaba en barriles que, tras embarrancar, iban cayendo al mar con los golpes de las olas por la inclinada cubierta y chocaban contra los arrecifes, se dañaban y se abrían soltando el sodio que, al entrar en contacto con el agua, ocasionaba fuertes explosiones que provocaron alarma social en un momento políticamente delicado con un gobierno regional recién elegido después de años de gobernar el partido contrario.

El colmo del esperpento llegó cuando los bidones que se rescataron todavía intactos del barco embarrancado se llevaron a la relativamente cercana factoría de fabricación de aluminio de Alúmina Aluminio en San Cibrao (Lugo), donde se disponía de los medios para mantener estable (léase seco) el cargamento hasta que se determinara su destino final. Al llegar allí, los obreros de la fábrica, alarmados por las explosiones que habían visto en la televisión cuando esos bidones caían al mar y se reventaban al chocar contra las rocas de la costa, abandonaron la fábrica dejando enfriar los hornos de colada continua de la fabricación de aluminio por lo que, solidificados pese al intento de los directivos de mantenerlos en funcionamiento con sus propias manos, hubo que terminar tirando como escombro esos costosos hornos y rehacer por completo las instalaciones tras largos meses de aquella inactividad inducida por los temores ocasionados, a su vez, por la desinformación de la gente que, irónicamente, no se había perdido un solo informativo de los emitidos por la televisión en los últimos días. Por supuesto, a esos obreros que habían ocasionado la ruina técnica de la fábrica hubo que indemnizarles por esos años de paro.

Por cierto, no se llegó a saber cuál fue el destino de esos bidones, teóricamente Shanghái, pero constituía la cantidad adecuada para ser el recambio del refrigerante del circuito primario de una central como la de Dimona, en Israel, refrigerada por sodio y que en esos días estaba en el plazo de su revisión. Casualmente.

En otro orden de cosas, el resto de la carga tampoco eran angelitos del dios ecológico, sino productos industriales que fácilmente entran en la categoría de peligrosos, insalubres o tóxicos, cuando no venenosos, pero que son necesarios para nuestro modelo industrial (actual). Y eran muchas más toneladas que los bidones de sodio, pero como no explotaban y sólo debieron causar un desastre ecológico local (como en tantos naufragios de la «Costa de la Muerte»), poco o nada se publicó sobre ello y no se generó alarma social.

EL EDIFICIO DE CONTENCIÓN

Dejando el terreno de las suposiciones, en cualquier caso es básico mantener todo el contenido del circuito primario (el uranio y el agua, sodio o el refrigerante que sea) controlado en todo momento, por lo que se construye, al menos en las centrales modernas y en las occidentales de todos los tiempos, un edificio de hormigón (al cual se añaden aditivos que mejoran su aislamiento frente a las radiaciones) que contiene la parte principal de la central nuclear y, en todo caso, la vasija y el circuito primario al completo. Ese edificio, sin ventanas y con muy pocas puertas, tiene como misión ser la última línea de defensa frente a un desastre de cualquier tipo, previsible o no, que afecte al circuito primario, impidiendo que la radiación llegue al exterior.

Este edificio de contención es la imagen clásica de una central nuclear: un bloque enorme, sin ventanas. A ello se refería el príncipe Carlos de Inglaterra cuando para mostrar su desagrado por un auditorio de música que inauguraron en Londres (con condiciones acústicas fuera de toda duda) dijo que le parecía una central nuclear en mitad de la ciudad, pues era una caja enorme casi sin ventanas.

MUCHA ENERGÍA EN CIRCULACIÓN… QUE ES PELIGROSO PARAR

Descontando los riesgos de manejar elementos radioactivos, las centrales nucleares tienen otra categoría de riesgos: los propios del manejo de ingentes cantidades de energía.

Por ejemplo, en ese intercambio de calor entre el líquido del circuito primario (no siempre es agua, aunque aquí lo hayamos asumido por simplificar la explicación) y el del secundario (que sí que es agua siempre), se están «sacando» de la olla millones de vatios de energía (térmica) de una forma continua y suave: a la vez que el líquido del circuito primario calienta el del secundario, este enfría el del primario. Podemos suponer con mucha facilidad que si el agua del circuito secundario dejase de fluir, la del circuito primario dejaría de refrigerarse, se acumularía el calor con gran rapidez y ello podría tener consecuencias desastrosas; consecuencias que al principio no tendrían que ver con la radioactividad, sino con el manejo de cantidades de energía a las que hay que tener un gran respeto, independientemente de si se han obtenido rompiendo átomos o quemando carbón.

De hecho, el que deje de circular el agua es un problema incluso en las calefacciones caseras, que también tienen mecanismos automáticos para que se corte la combustión del gas (por ejemplo) si ha dejado de funcionar la bomba del agua. En estos casos, lo que pasa si falla ese mecanismo o aumenta en exceso la temperatura por cualquier causa es que sube la presión, se abre una válvula de alivio y por debajo de la caldera empieza a gotear (o chorrear) el agua del circuito estropeando, en ausencia de «edificio de contención», todo lo que encuentre debajo. Encontraremos más adelante un ejemplo parecido en un conocido accidente nuclear.

FUSIÓN

Un breve apunte sobre la energía de fusión, que no es protagonista de ningún desastre tecnológico por la mísera razón de que no existe. Todavía. El año 1991 es una fecha que dentro de muchas generaciones se considerará memorable para la historia, y no por ser el año de la (primera) Guerra del Golfo Pérsico, por el final del Apartheid sudafricano o por la disolución de la Unión Soviética y del Pacto de Varsovia. Será recordado, creemos, sobre todo porque el sábado 9 de noviembre de ese año se consiguió en laboratorio por primera vez producir energía de fusión de una manera aprovechable.

EL VERDADERO MOTOR DE AGUA

El combustible de un reactor de fusión es, en la práctica, ilimitado: es el agua del mar; y no tiene problemas con las radiaciones ni los residuos. Hasta tal punto la energía de fusión es la panacea que para obtener de una forma más barata el helio-3 (un isótopo caro de obtener en la Tierra) y facilitar la explotación de estas centrales se está empezando a hablar de volver a viajar a la Luna y, si se encuentra en cantidades suficientes allí arriba, explotar su minería, pues podría resultar más efectivo traer el helio-3 desde nuestro satélite preferido que destilarlo «aquí abajo».

Por eso pareció justificado dedicar los siguientes cuarenta años (era el plan, sobre ello pueden llegar los retrasos habituales en proyectos gigantescos gestionados por un comité plurinacional) para diseñar y fabricar el ITER, el primer reactor nuclear de fusión, en Cadarache, en la Provenza del sur de Francia, el cual, una vez puesto en explotación y analizadas sus características, sus ventajas y sus problemas suministrando electricidad durante un tiempo, servirá de modelo para diseñar otro, ya destinado a la explotación comercial, aprovechando esas experiencias y así, esa segunda generación, se podrá fabricar en infinidad de réplicas que proporcionarán energía limpia e ilimitada a lo largo y ancho de todo el planeta.

Ese es el futuro. ¿El problema?: que los plazos de realización harán que no todos nuestros hijos lo vean convertido en cotidiano y quizá tampoco nuestros nietos.

LA ENERGÍA ILIMITADA COMO CEBO

Y una coletilla acerca de un pequeño desastre tecnológico: hablamos de un concepto interesante que pasó con rapidez de ser la esperanza de la humanidad a ser considerado algo anticientífico y que, por el momento, no deja de ser una curiosidad de laboratorio: la fusión fría.

Para «encender» la fusión nuclear hace falta darle al hidrógeno una coz bastante enérgica, calentarlo a millones de grados y eso cuesta mucho, tanto que se tardaron años de trabajos intensos y de muy alto nivel para conseguir que del experimento saliese más energía de la que se gastaba. Porque el concepto fundamental en este asunto es ese: que de allí salga más energía de la que hay que meter para que funcione.

En este escenario aparecieron en marzo de 1989 Martin Fleischmann y Stanley Pons, convocaron una rueda de prensa y allí declararon que habían conseguido la fusión fría y que la reacción generaba cincuenta veces más energía de la suministrada.

Para ello colocaban electrodos de paladio en agua pesada (enriquecida en deuterio y algo de tritio) y hacían pasar la corriente eléctrica, con lo cual en la electrolisis que se produce, el hidrógeno —en este caso deuterio— se deposita en el electrodo y dadas las propiedades del paladio, según ellos se fusionaban los núcleos.

Era la panacea: energía de bajo coste en instalaciones no muy complicadas. En la película Reacción en cadena, con Keanu Reeves y Morgan Freeman, se supone que lo logran por medio de ondas sónicas —sonoluminiscencia—, que es algo que también se ha intentado pero tampoco parece que hasta ahora haya conseguido generar energía sobrante, sino que al igual que otros métodos, precisa un aporte neto de energía para lograr la fusión y luego no se mantiene ni genera excedentes energéticos. Pero en la película sí que se dejaba entrever la clave de ese negocio: era algo capaz de cambiar el mundo si tenía éxito.

Tras el impacto inicial del anuncio de Martin Fleischmann y Stanley Pons, otros laboratorios se dedicaron a repetir el experimento, dado que muchos dudaban de ello y era raro que no lo comunicaran a una revista o en una reunión científica, sino en una rueda de prensa. Ninguno de los que lo intentaron entonces consiguió reproducir el experimento, por lo que el tema pasó a ser pecado. Lo cierto es que Fleischmann y Pons pasaron de ser dioses a parias en menos tiempo que otros científicos, y lo triste es que un tema que prometía se apagó durante años por la mala manera de comunicarlo (vender la moto para la audiencia en vez de contrastar los resultados).

La idea, no obstante, ya la tuvieron dos alemanes en 1926 —Fritz Paneth y Kurt Peters—, que describieron una célula electrolítica igual, también con un electrodo de paladio (es un metal muy curioso: absorbe hidrógeno, mucho hidrógeno, muchos cientos de veces su volumen en hidrógeno), que al rellenarse con agua pesada —que tiene deuterio—, lograban que se generase helio al almacenarse en el paladio átomos de deuterio muy cerca uno de otro. Algún tiempo después escribieron otro artículo donde reconocían honradamente fallos de método que invalidaban el resultado.

Tiempo después, en 1947, Charles Frank, físico inglés, describió que teóricamente se podría conseguir la fusión por medio de muones, y en 1956 el premio Nobel estadounidense Luis Alvarez dijo haberlo conseguido pero tan sólo como curiosidad de laboratorio, pues la reacción no duraba lo suficiente para que se pudiese explotar en generar energía. Todos los experimentos hasta ahora han sido fallidos como fuente de energía por autoconsunción o por requerir un exceso de energía respecto a la generada.

NO PERDAMOS LA ESPERANZA

De todos modos el tema no está muerto ni mucho menos y tras la fase de descrédito inicial ha habido grupos que han retomado el tema, aunque sin lograr por ahora un rendimiento energético detectable. Cuando los colegas de Fleischmann y Pons trataron de reproducir el experimento no lo lograron, con lo que el excedente energético no lo corroboró nadie, y al estudiar el experimento descrito vieron que debía desprender tal cantidad de neutrones que el hecho de contarlo era una señal de falsedad, ya que deberían haber muerto irradiados.

Fue uno de tantos experimentos «no reproducibles», y aunque se sigue trabajando en el tema, por ahora no se ha conseguido que genere más energía de la consumida, que es la idea revolucionaria. En cuanto a conseguir la fusión fría en pequeñas cantidades, parece que algo más de una docena de laboratorios lo han conseguido en el mundo, hasta alguno de aficionado con buen equipamiento lo ha logrado, como el de Gerardo Meiro, en Madrid.

FOTOVOLTAICAS

Otro breve apunte para no dejar sin mencionar esta tecnología trascendental. En ellas, unos paneles de silicio se ponen al sol y sale electricidad. No tiene nada que se mueva de forma crítica: lo más que puede pasar si se atasca un panel en su seguimiento del sol es que producirá menos electricidad hasta que lo reparen.

Realmente no podemos imaginar que una central eléctrica fotovoltaica pueda producir un desastre serio salvo si se utilizan los paneles para producir reflejos molestos en algún edificio cercano o deslumbran a los coches de alguna carretera que pase por allí, o si se instalan en algún campo en el que estorben a la flora o a la fauna.

—¿No tienen ningún problema?

—Sí: que son muy caros.

Por el momento la única manera de que resulten rentables es subvencionar su instalación. En España se ha subvencionado (con altibajos) la producción fotovoltaica y en algún momento los apoyos han sido tan jugosos que ha dado lugar a fraudes muy curiosos: se ha descubierto algún caso de instalaciones que tenían una producción significativa después de la puesta de sol. ¿Cómo? Pues resulta que habían puesto generadores eléctricos de gasoil en la instalación (en una caseta o incluso en una furgoneta allí aparcada) y vendían la electricidad así producida como si fuese de origen fotovoltaico. Las subvenciones eran tan altas que incluso producir electricidad con generadores caseros resultaba rentable. Si no se les hubiese olvidado algún atardecer ir a apagar el generador a tiempo, hubiese sido un truco muy difícil de detectar.

La parte buena de las centrales fotovoltaicas es que su energía es limpia (aunque fabricarlas aporta su cuota de contaminación, pero en eso simplemente son iguales a todas las demás tecnologías) e «ilimitada». Bastaría con cubrir con paneles solares los terrenos estériles del planeta para producir más electricidad de la que podemos consumir, no contribuye al calentamiento global más que de forma marginal y cuando, dentro de muchos miles o incluso millones de años, se agote el agua de mar que alimente a las centrales de fusión, todavía dispondremos de energía solar para muchos miles de millones de años más.

EL PELIGRO NUCLEAR

Al contrario del caso de la carrera espacial, en la que casi todo eran «éxitos» y, si no lo eran, se maquillaban hasta que lo parecían, de las cuestiones energéticas y, sobre todo, de la energía nuclear y de los petroleros o los pozos petrolíferos, sólo llegan a las portadas de los periódicos los fracasos y, cuando no lo son, siempre tiene una importante cuota de pantalla cualquiera que pueda cambiar esa percepción por otra que, a veces, llega al catastrofismo.

El caso es que cuando se habla de desastres tecnológicos, es la energía atómica la que primero suele venir a la mente de muchos. Quizá por el explosivo final de la Segunda Guerra Mundial y por supuesto olvidando sus principios (los camiones de radio en Francia, para los tratamientos del cáncer) y los grandes beneficios que la radioterapia aporta hoy en áreas clave de la medicina.

EL MIEDO A LO DESCONOCIDO E INVISIBLE

Quizá se trata, en gran medida, del miedo a lo que en el ámbito social ni se ve ni se entiende. Es un miedo muy antiguo, pero que evoluciona a la vez que evoluciona la sociedad en conjunto o, al menos, evoluciona en la medida en que un porcentaje significativo de sus miembros va adquiriendo una mayor comprensión del mundo que nos rodea.

Así, en el siglo XIX aparecieron multitud de profetas que vaticinaban grandes males para la humanidad por la utilización de la electricidad. Y los monstruos, como Frankenstein sin ir más lejos, eran despertados en el momento oportuno por una descarga de alto voltaje. La tecnología punta del siglo XIX era la electricidad.

Tiempo después, en el amanecer nuclear, Godzilla era sacado de su letargo de forma accidental por las radiaciones atómicas. Eso tuvo varias consecuencias, como películas de terror que no sólo asustaban por los monstruos de cartón piedra que mostraban, sino que metían en el inconsciente colectivo la idea de que las radiaciones hacían casi cualquier cosa (horrible) que pudiésemos imaginar. También consiguieron que nos terminásemos aprendiendo el nombre de actores japoneses de segunda fila. Pero hoy esas películas nos parecen muy primarias y la mayoría de la gente está convencida de que las radiaciones, sean del sabor que sean, no son capaces de resucitar un dinosaurio enfadado y así, más recientemente, los tiranosaurios de Parque Jurásico son ahora vueltos a la vida por el arquetipo moderno de lo que la mayoría no entiende y casi nadie ve: la biotecnología, aunque no ha conseguido aterrorizar a casi nadie todavía.

En resumen: siempre ha sido sencillo crear alarma (que es una de las formas más pobres de crear interés) acudiendo a lo desconocido. Pero si lo desconocido, además, se llama parecido a lo que puede formar un hongo espectacular mientras convierte en cenizas una ciudad entera, el éxito está asegurado. Convencer a los que compran en un supermercado de los horrores de adquirir una lata de ensaladilla que contiene maíz transgénico cuesta bastante más (y la propia lata algo menos).

La mejor vacuna contra el temor incontrolado es el conocimiento, que deja las preocupaciones en su justa medida. Así es que antes de describir los grandes desastres relacionados con la energía, sobre todo la nuclear, hemos querido abordar una descripción mínimamente simplificada de cómo funcionan las centrales eléctricas, cuáles son sus puntos críticos y qué sistemas se utilizan en general para evitar accidentes.

Pero ahora vamos a ver los casos en los que, pese a todo, salió mal.