SENADOR JOHN PASTORE: ¿Hay algo que tenga alguna relación con las esperanzas que suscita este acelerador y que, de una forma o de otra, afecte a la seguridad de este país?

ROBERT R. WILSON: No, señor. No lo creo.

PASTORE: ¿Nada en absoluto?

WILSON: Nada en absoluto.

PASTORE: ¿Carece de importancia en lo que a ella se refiere?

WILSON: Sólo tiene que ver con el respeto con que nos miramos unos a otros, la dignidad de los hombres, nuestro amor por la cultura. Tiene que ver con: ¿somos buenos pintores, buenos escultores, grandes poetas? Me refiero a todas las cosas que realmente veneramos y honramos en nuestro país y que excitan nuestro patriotismo. No tiene nada que ver directamente con la defensa de nuestro país salvo que hace que merezca la pena defenderlo.

Tenemos una tradición en el Fermilab. Cada primero de junio, llueva o haga sol, a las siete de la mañana se invita a la plantilla a correr los más de seis kilómetros alrededor del anillo principal del acelerador por la carretera de la superficie, que sirve además de pista de jogging. Corremos siempre en la dirección en que se aceleran los antiprotones. Mi último tiempo oficioso alrededor del anillo fue de 38 minutos. El actual director del Fermilab, mi sucesor John Peoples, comunicó, el primer verano que ocupó el puesto, que invitaba a la plantilla a correr el 1 de junio con «un director más joven y que corre más». Correr, corría más, pero ninguno de nosotros es lo suficientemente rápido para batir a los antiprotones. Completan el circuito en unas 22 millonésimas de segundo, lo que quiere decir que cada antiprotón me dobla unos cien millones de veces.

La plantilla del Fermilab sigue siendo humillada por los antiprotones. Pero vamos a la par; fuimos nosotros los que diseñamos los experimentos. Conducimos a los antiprotones a que choquen de frente contra los protones que corren justo a la misma velocidad en dirección contraria. El proceso de conseguir que las partículas choquen es la esencia de este capítulo.

El examen de los aceleradores que vamos a hacer será un poco un desvío. Hemos corrido a lo largo de siglos de progreso científico como un camión sin frenos. Vayamos un poco más despacio. No vamos a hablar aquí tanto de descubrimientos, ni de físicos siquiera, como de máquinas. Los instrumentos están unidos inseparablemente al progreso científico, del plano inclinado de Galileo a la cámara de chispas de Rutherford. Ahora, un instrumento ocupa el escenario central. No se puede entender la física de las últimas décadas si no se conoce la naturaleza de los aceleradores y la serie de detectores que los acompañan, los instrumentos dominantes en la especialidad durante los últimos cuarenta años. Al aprender sobre los aceleradores, aprendemos además mucha física, pues esta máquina incorpora muchos principios que los físicos han perfeccionado gracias a siglos de trabajo.

A veces pienso en la torre de Pisa como si hubiera sido el primer acelerador de partículas, un acelerador (casi) vertical que Galileo utilizó en sus estudios. Pero la historia verdadera empieza mucho más tarde. El desarrollo del acelerador dimana de nuestro deseo de llegar hasta el átomo. Dejando aparte a Galileo, la historia empieza con Ernest Rutherford y sus alumnos, que se convirtieron en maestros del arte de sacar provecho de la partícula alfa para explorar el átomo.

La partícula alfa es un regalo. Cuando un material radiactivo por naturaleza se desintegra espontáneamente, lanza estas partículas pesadas y de gran energía. La energía característica de una partícula alfa es de 5 millones de electronvoltios. Un electronvoltio (eV) es la cantidad de energía que un solo electrón recibiría si cruzase desde la carcasa (negativa) de la pila de 1 voltio de una linterna a su polo positivo. Cuando hayáis terminado los dos capítulos siguientes, el electronvoltio os será tan familiar como el centímetro, la caloría o el megabyte. Estas son cuatro abreviaturas que deberíais conocer antes de seguir adelante:

KeV: mil electronvoltios (K de kilo)

MeV: un millón de electronvoltios (M de mega)

GeV: mil millones de electronvoltios (G de giga)

TeV: billón de electronvoltios (T de tera)

Más allá del TeV recurrimos a la notación de potencias de diez: 10¹² eV es un TeV. La tecnología previsible no pasa de 1014, y ahí entramos en el dominio de las partículas de los rayos cósmicos, que bombardean la Tierra desde el espacio exterior. El número de partículas de los rayos cósmicos es pequeño, pero sus energías pueden tornar cualquier valor hasta 10²¹ eV.

En la física de partículas, 5 MeV no es mucho; las alfas de Rutherford a duras penas rompían los núcleos de los átomos de nitrógeno en las que quizá fueron las primeras colisiones nucleares deliberadas. Y de ellas sólo salieron vislumbres tentadores de lo que había que descubrir. La teoría cuántica nos dice que cuanto menor sea el objeto que se estudia, más energía hace falta; es como afilar el cuchillo de Demócrito. Para partir eficazmente el núcleo necesitamos energías de muchas decenas o incluso cientos de MeV. Cuanto mayores sean, mejor.

Una digresión filosófica. Como contaré, los científicos de partículas iban construyendo tan contentos aceleradores cada vez más poderosos por todas las razones por las que cualquiera de nosotros, sapiens, hacemos algo: la curiosidad, el ego, el poder, la avaricia, la ambición… Muy a menudo, unos cuantos, en quieta contemplación ante una cerveza, le daremos vueltas a la cuestión de si el mismísimo Dios sabe qué producirá nuestra próxima máquina (por ejemplo, el «monstruo» de 30 GeV que en 1959 estaba a punto de terminarse en Brookhaven). ¿No estaremos acaso inventándonos nuestros propios problemas al conseguir esas nuevas, inauditas energías? ¿Dios, en Su inseguridad, mira por encima del hombro de GellMann o Feynman u otros de Sus teóricos favoritos para descubrir qué hay que hacer a esas energías gigantescas? ¿Convoca a un comité de ángeles residentes —Rabí Newton, Einstein, Maxwell— con el objeto de que le indiquen qué hay que hacer a los 30 GeV? La brusquedad de la historia de la teoría da de vez en cuando alas a este punto de vista, como si a Dios se le ocurriesen las cosas a medida que nosotros vamos hacia adelante. Sin embargo, el progreso en la astrofísica y en la investigación de los rayos cósmicos nos certifica enseguida que eso no es más que una tontería «del viernes por la noche antes del sabbath». Nuestros colegas que miran hacia arriba nos dicen con seguridad que al universo sí le importan mucho los 30 GeV, los 300 GeV, hasta los 3.000 millones de GeV. El espacio es barrido por partículas de energías astronómicas (¡uf!), y lo que hoy es un acontecimiento raro, exótico en un punto de colisión infinitesimal de Long Island o Batavia o Tsukuba era, nada más haber nacido el universo, ordinario, cotidiano, uno entre tantos.

Y ahora volvamos a las máquinas.

El acelerador más potente que existe hoy, el Tevatrón del Fermilab, produce colisiones a unos 2 TeV o 400.000 veces la energía que se creaba en las colisiones de las partículas alfa de Rutherford. El Supercolisionador Superconductor, aún por construir, se ha concebido para que opere a unos 40 TeV.

40 TeV suena como si fuese muchísima energía, y de hecho lo es cuando se invierte en una sola colisión de dos partículas. Pero deberíamos poner esto en perspectiva. Cuando encendemos una cerilla, participan unos 10²¹ átomos en la reacción, y cada proceso libera unos 10 eV, así que le energía total es aproximadamente 10²² eV, o unos 10.000 millones de TeV. En el Supercolisionador habrá 100 millones de colisiones por segundo, cada una de las cuales liberará 40 TeV, lo que da un total de unos 4.000 millones de TeV, ¡una cantidad no muy distinta de la energía que se libera al encender una cerilla! Pero la clave es que la energía se concentra en unas pocas partículas y no en los billones y billones y billones de partículas que hay en una pizca de materia visible.

Podemos ver todo el complejo del acelerador —de la estación de energía alimentada con petróleo, pasando por las líneas de energía eléctrica, al laboratorio donde los transformadores llevan la energía eléctrica a los imanes y las cavidades de radiofrecuencia— como un gigantesco dispositivo que concentra, con una eficiencia bajísima, la energía química del petróleo en unos insignificantes mil millones o así de protones por segundo. Si la cantidad macroscópica de petróleo se calentase hasta que cada uno de los átomos que la constituyen tuviese 40 TeV, la temperatura sería de 4 × 1017 grados, 400.000 billones de grados en la escala Kelvin. Los átomos se derretirían en los quarks que los forman. Ese era el estado del universo entero menos de una mil billonésima de segundo tras la creación.

Entonces, ¿qué hacemos con toda esa energía? La teoría cuántica exige que, para estudiar cosas cada vez menores, los aceleradores sean cada vez más potentes. Esta es una tabla de la energía aproximada que hace falta para descerrajar varias estructuras interesantes:

| Energía (aproximada) | Estructura | Tamaño |

|---|---|---|

| 0,1 eV | Molécula, átomo grande | 10−8 metros |

| 1,0 eV | Átomo | 10−9 m |

| 1.000 eV | Región atómica central | 10−11 m |

| 1 MeV | Núcleo gordo | 10−14 m |

| 100 MeV | Región central del núcleo | 10−15 m |

| 1 GeV | Neutrón o protón | 10−16 m |

| 10 GeV | Efectos de quark | 10−17 m |

| 100 GeV | Efectos de quark | 10−18 m (con más detalle) |

| 10 TeV | Partícula Divina | 10−20 m |

Observad lo predeciblemente que la energía necesaria aumenta a medida que el tamaño disminuye. Observad, además, que para estudiar los átomos sólo hace falta 1 eV, pero se necesitan 10.000 trillones de eV para empezar a estudiar los quarks.

Los aceleradores son como los microscopios que utilizan los biólogos, sólo que para estudiar cosas muchísimo menores. Los microscopios corrientes iluminan con luz la estructura de, digamos, los glóbulos rojos de la sangre. Los microscopios electrónicos, tan queridos por los cazadores de microbios, son más poderosos precisamente porque los electrones tienen mayor energía que la luz del microscopio óptico. Gracias a las longitudes de onda más cortas de los electrones, los biólogos pueden «ver» y estudiar. Es la longitud de onda del objeto que bombardea la que determina el tamaño de lo que podemos «ver» y estudiar. En la teoría cuántica sabemos que a medida que la longitud de onda se hace más corta la energía aumenta; nuestra tabla no hace otra cosa que demostrar esa conexión.

En 1927, Rutherford, en un discurso dado en la Royal Society Británica, expresó su esperanza de que un día los científicos hallasen una forma de acelerar las partículas cargadas hasta energías mayores que las proporcionadas por la desintegración radiactiva. Previó que se inventarían máquinas capaces de generar muchos millones de voltios. Había, aparte de la pura energía, una razón para construir máquinas así. A los físicos les hacía falta disparar un número mayor de proyectiles a un blanco dado. Las fuentes de partículas alfa que proporciona la naturaleza no eran precisamente boyantes: se podían dirigir hacia un blanco de un centímetro cuadrado menos de un millón de partículas por segundo. Un millón parece mucho, pero los núcleos ocupan sólo una centésima de una millonésima del área del blanco. Hacen falta al menos mil veces más partículas aceleradas (1.000 millones) y, como ya se ha dicho, mucha más energía, muchos millones de voltios (los físicos no estaban seguros de cuántos), para sondear el núcleo. A finales de los años veinte, esta tarea parecía poco menos que imponente, pero los físicos de muchos laboratorios se pusieron a trabajar en el problema. A partir de ahí vino una carrera hacia la creación de máquinas que acelerasen el enorme número de partículas requerido hasta al menos un millón de voltios. Antes de examinar los avances de la técnica de los aceleradores, deberíamos hablar de algunos conceptos básicos.

No es difícil explicar la física de la aceleración de partículas (¡prestad atención!). Conectad los bornes de una batería DieHard a dos placas metálicas (las llamaremos terminales), separadas, por ejemplo, unos treinta centímetros. A este montaje se le llama el hueco. Encerrad los dos terminales en un recipiente del que se haya extraído el aire. Organizad el equipo de forma que una partícula cargada eléctricamente —los electrones y los protones son los proyectiles primarios— pueda moverse con libertad a través del hueco. Un electrón, con su carga negativa, correrá satisfecho hacia el terminal positivo y ganará una energía de (mirad la etiqueta de la batería) 12 eV. El hueco, pues, produce una aceleración. Si el terminal metálico positivo es una rejilla en vez de una placa sólida, la mayoría de los electrones lo atravesarán y se creará un haz directo de electrones de 12 eV. Ahora bien, un electronvoltio es una unidad de energía pequeñísima. Lo que hace falta es una batería de 1.000 millones de voltios, pero Sears no trabaja ese artículo. Para conseguir grandes voltajes es necesario ir más allá de los dispositivos químicos. Pero no importa lo grande que sea un acelerador; hablemos de un Cockcroft-Walton de los años veinte o del Supercolisionador de 87 kilómetros de circunferencia, el mecanismo básico es el mismo: el hueco a través del cual las partículas ganan energía.

El acelerador toma partículas normales, respetuosas de la ley, y les da una energía extra. ¿De dónde sacamos las partículas? Los electrones son fáciles de obtener. Calentamos un cable hasta la incandescencia y los electrones manan. Tampoco cuesta conseguir los protones. El protón es el núcleo del átomo de hidrógeno (los núcleos de hidrógeno no tienen neutrones), así que lo único que hace falta es gas hidrógeno del que está a la venta. Se pueden acelerar otras partículas, pero tienen que ser estables —es decir, sus vidas medias han de ser largas— porque el proceso de aceleración lleva tiempo. Y han de tener carga eléctrica, pues está claro que el hueco no funciona con una partícula neutra. Los candidatos principales a ser acelerados son los protones, los antiprotones, los electrones y los positrones (los antielectrones). También se pueden acelerar núcleos más pesados, los deuterones y las partículas alfa, por ejemplo; tienen usos especiales. Una máquina inusual que se está construyendo en Long Island, Nueva York, acelerará los núcleos de uranio hasta miles de millones de electrón volts.

¿Qué hace el proceso de aceleración? La respuesta sencilla, pero incompleta, es que acelera a las afortunadas partículas. En los primeros tiempos de los aceleradores, esta explicación funcionó muy bien. Una descripción mejor es que eleva la energía de las partículas. A medida que los aceleradores se hicieron más poderosos, pronto consiguieron velocidades cercanas a la suprema: la de la luz. La teoría de la relatividad especial de Einstein de 1905 afirma que nada puede viajar más deprisa que la luz. A causa de la relatividad, el concepto de «velocidad» no es muy útil. Por ejemplo, una máquina podría acelerar los protones a, digamos, el 99 por 100 de la velocidad de la luz, y una mucho más cara, construida diez años después, llegaría al 99,9 por 100. Un montón. ¡Vete a explicárselo al congresista que votó por semejante rosquilla sólo para conseguir otro 0,9 por 100!

No es la velocidad la que afila el cuchillo de Demócrito y ofrece nuevos dominios de observación. Es la energía. Un protón a un 99 por 100 de la velocidad de la luz tiene una energía de unos 7 GeV (el Bevatrón de Berkeley, 1955), mientras que uno a un 99,95 por 100 la tiene de 30 GeV (Brookhaven AGS, 1960) y uno a 99,999 por 100, de 200 GeV (Fermilab, 1972). Así que la relatividad de Einstein, que rige la manera en que la velocidad y la energía cambian, hace que sea ocioso hablar de la velocidad. Es la energía lo que importa. Una propiedad relacionada con ella es el momento, que para una partícula de alta energía se puede considerar una energía dirigida. Dicho sea de paso, la partícula acelerada se vuelve también más pesada a causa de E = mc². En la relatividad, una partícula en reposo aún tiene una energía dada por E = m0c², donde m0 se define como la «masa en reposo» de la partícula. Cuando se acelera la partícula, su energía, E, y por lo tanto su masa crecen. Cuanto más cerca se esté de la velocidad de la luz, más pesada se vuelve y por consiguiente más difícil es aumentar su velocidad. Pero la energía sigue creciendo. La masa en reposo del protón es alrededor de 1 GeV, lo que viene muy bien. La masa de un protón de 200 GeV es más de doscientas veces la del protón que reposa cómodamente en la botella de gas hidrógeno. Nuestro acelerador es en realidad un «ponderador».

Ahora bien, ¿cómo usamos esas partículas? Dicho con sencillez, las obligamos a que produzcan colisiones. Como este es el proceso central gracias al que podemos aprender acerca de la materia y la energía, debemos entrar en detalles. Está bien olvidarse de las distintas peculiaridades de la maquinaria y de la manera en que se aceleran las partículas, por interesantes que puedan ser. Pero acordaos de esta parte. El meollo del acelerador está por completo en la colisión.

Nuestra técnica de observar y, al final, de conocer el mundo abstracto del dominio subnuclear es similar a la manera en que conocemos cualquier otra cosa, un árbol, por ejemplo. ¿Cuál es el proceso? Para empezar, nos hace falta luz. Usemos la del Sol. El flujo de fotones que viene del Sol se dirige hacia el árbol y se refleja en las hojas y en la corteza, en las ramas grandes y en las pequeñas, y nuestro ojo recoge una fracción de esos fotones. El objeto, podemos decir, dispersa los fotones hacia el detector. La lente del ojo detecta los fotones y clasifica las distintas cualidades: el color, el matiz, la intensidad. Se organiza esta información y se envía al procesador en línea, el lóbulo occipital del cerebro, que se especializa en los datos visuales. Al final, el procesador fuera de línea llega a una conclusión: «¡Por Júpiter, un árbol! ¡Qué bonito!».

Puede que la información que llega al ojo haya sido filtrada por gafas, para ver o de sol, lo que añade distorsión a la que el ojo introduce de por sí. Toca al cerebro corregir esas distorsiones. Reemplacemos el ojo por una cámara, y ahora, una semana después, con un grado mayor de abstracción, se ve el árbol proyectado en un pase de diapositivas familiares. O una grabadora de vídeo puede convertir los datos ofrecidos por los fotones dispersados en una información electrónica digital: ceros y unos. Para aprovechar esto, se pone en funcionamiento mediante la televisión, que reconvierte la señal digital en analógica, y un árbol aparece en la pantalla. Si se quisiera enviar «árbol» a nuestros colegas científicos del planeta Uginza, puede que no se convirtiese la información digital en analógica, pero aquélla transmitiría, con la máxima precisión, la configuración a la que los terráqueos llamamos árbol.

Por supuesto, las cosas no son tan simples en un acelerador. Las partículas de tipos diferentes se usan de maneras diferentes. Pero todavía podemos llevar la metáfora otro paso adelante para las colisiones y dispersiones nucleares. Los árboles se ven de forma diferente por la mañana, al mediodía, al ponerse el sol. Cualquiera que haya visto los numerosos cuadros que Monet pintó de la fachada de la catedral de Ruán a diferentes horas del día sabe hasta qué punto la cualidad de la luz establece diferencias. ¿Cuál es la verdad? Para el artista la catedral tiene muchas verdades. Cada una reverbera en su propia realidad: la luz neblinosa de la mañana, los duros contrastes del sol al mediodía o el rico resplandor del final de la tarde. A cada una de esas luces se exhibe un aspecto diferente de la verdad. Los físicos trabajan con el mismo enfoque. Necesitamos toda la información que podamos obtener. El artista emplea la luz cambiante del sol. Nosotros emplearnos partículas diferentes: un flujo de electrones, un flujo de muones o de neutrinos, a energías siempre cambiantes.

Las cosas son como sigue.

De una colisión se sabe qué entra y qué sale (y cómo sale). ¿Qué pasa en el minúsculo volumen de la colisión? La desquiciadora verdad es que no podemos verlo. Es como si una caja negra cubriese la región de colisión. En el mundo cuántico, fantasmagórico, lleno de reflejos, los detalles mecánicos internos de la colisión no son observables —apenas si somos capaces siquiera de imaginarlos—. Lo que tenemos es un modelo de las fuerzas que actúan y, donde sea pertinente, de la estructura de los objetos que chocan. Vemos qué entra y qué sale, y preguntamos si nuestro modelo de lo que hay en la caja predice los patrones.

En un programa educativo del Fermilab para niños de diez años les hacemos afrontar ese problema. Les damos una caja cuadrada vacía para que la midan, la meneen, la pesen. Ponemos a continuación algo dentro de la caja, un bloque de madera, por ejemplo, o tres bolas de acero. Pedimos entonces a los estudiantes que otra vez pesen, meneen, inclinen y escuchen, y que nos digan todo lo que puedan acerca de los objetos: el tamaño, la forma, el peso… Es una metáfora instructiva de nuestros experimentos de dispersión. Os sorprendería cuán a menudo aciertan los chicos.

Pasemos a los adultos y a las partículas. Supongamos que se quiere descubrir el tamaño de los protones. Tomémosle la idea a Monet: mirémoslos bajo diferentes formas de luz. ¿Podrían los protones ser puntos? Para saberlo, los físicos golpearon los protones con otros protones de una energía muy baja con el objeto de explorar la fuerza electromagnética entre los dos objetos cargados. La ley de Coulomb dice que esta fuerza se extiende al infinito, disminuyendo su intensidad con el cuadrado de la distancia. El protón que hace de blanco y el acelerado están, claro, cargados positivamente, y como las cargas iguales se repelen, el protón blanco repele sin dificultad al protón lento, que no llega nunca a acercarse demasiado. Con este tipo de «luz», el protón parece, en efecto, un punto, un punto de carga eléctrica. Así que aumentemos la energía de los protones acelerados. Ahora, las desviaciones en los patrones de dispersión de los protones indican que van penetrando con la hondura suficiente para tocar la llamada interacción fuerte, la fuerza de la que ahora sabemos que mantiene unidos a los constituyentes del protón. La interacción fuerte es cien veces más intensa que la fuerza eléctrica de Coulomb, pero, al contrario que ésta, su alcance no es en absoluto infinito. Se extiende sólo hasta una distancia de unos 10−13 centímetros, y luego cae deprisa a cero.

Al incrementar la energía de la colisión, desenterramos más y más detalles de la interacción fuerte. A medida que aumenta la energía, la longitud de onda de los protones (acordaos de De Broglie y Schrödinger) se encoge. Y, como hemos visto, cuanto menor sea la longitud de onda, más detalles cabe discernir en la partícula que se estudie.

Robert Hofstadter, de la Universidad de Stanford, tomó en los años cincuenta algunas de las mejores «imágenes» del protón. En vez de un haz de protones, la «luz» que utilizó fue un haz de electrones. El equipo de Hofstadter apuntó un haz bien organizado de electrones de, digamos, 800 MeV a un pequeño recipiente de hidrógeno líquido. Los electrones bombardearon los protones del hidrógeno y el resultado fue un patrón de dispersión, el de los electrones que salían en una variedad de direcciones con respecto a su movimiento original. No es muy diferente a lo que hizo Rutherford. Al contrario que el protón, el electrón no responde a la interacción nuclear fuerte. Responde sólo a la carga eléctrica del protón, y por ello los Científicos de Stanford pudieron explorar la forma de la distribución de carga del protón. Y esto, de hecho, revela el tamaño del protón. Claramente, no era un punto. Se midió que el radio era de 2,8 × 10−13 centímetros; la carga se acumula en el centro, y se desvanece en los bordes de lo que llamamos el protón. Se obtuvieron resultados parecidos cuando se repitieron los experimentos con haces de muones, que también ignoran la interacción fuerte. Hofstadter recibió en 1961 un premio Nobel por su «fotografía» del protón.

Alrededor de 1968, los físicos del Centro del Acelerador Lineal de Stanford (SLAC) bombardearon los protones con electrones de mucha mayor energía —de 8 a 15 GeV— y obtuvieron un conjunto muy diferente de patrones de dispersión. A esta luz dura, el protón presentaba un aspecto completamente distinto. Los electrones de energía relativamente baja que empleó Hofstadter podían ver sólo un protón «borroso», una distribución regular de carga que hacía que el electrón pareciese una bolita musgosa. Los electrones del SLAC sondearon con mayor dureza y dieron con unos personajillos que correteaban dentro del protón. Fue la primera indicación de la realidad de los quarks. Los nuevos y los viejos datos no se contradecían —como no se contradicen los cuadros de la mañana y del anochecer de Monet—, pero los electrones de baja energía sólo podían revelar distribuciones de carga medias. La visualización que ofrecieron los electrones de energía mayor mostró que nuestro protón contiene tres constituyentes puntuales en movimiento rápido. ¿Por qué el experimento del SLAC mostró este detalle, y el estudio de Hofstadter no? Una colisión de energía que sea lo bastante alta (determinada por lo que entre y lo que salga) congela los quarks en su sitio y «siente» la fuerza puntual. Es, de nuevo, la virtud de las longitudes de onda cortas. Esta fuerza produce inmediatamente dispersiones a grandes ángulos (recordad a Rutherford y el núcleo) y grandes cambios de energía. El nombre formal de este fenómeno es «dispersión inelástica profunda». En los experimentos previos, los de Hofstadter, el movimiento de los quarks se emborronaba y los protones parecían «regulares» y uniformes por dentro a causa de la menor energía de los electrones sondeadores: Imaginad que se saca una fotografía de tres bombillas diminutas que vibran rápidamente con una exposición de un minuto. La película mostraría un solo objeto grande, borroso, indiferenciado. El experimento del SLAC usó —hablando burdamente— un obturador más rápido, que congelaba las manchas de luz para que se las pudiese contar fácilmente.

Como la interpretación basada en los quarks de la dispersión de los electrones de gran energía se salía mucho de lo corriente y era de tremenda importancia, estos experimentos se repitieron en el Fermilab y en el CERN (acrónimo del Centro Europeo de Investigaciones Nucleares) con muones cuya energía era diez veces la energía del SLAC (150 Gev) y con neutrinos. Los muones, como los electrones, comprueban la estructura electromagnética del protón, pero los neutrinos, impermeables a la fuerza electromagnética y a la interacción fuerte, tantean la llamada distribución de la interacción débil. La interacción débil es la fuerza nuclear responsable de la desintegración radiactiva, entre otras cosas. Cada uno de estos experimentos enormes, efectuados en acalorada competencia, llegó a la misma conclusión: el protón está formado por tres quarks. Y aprendimos algunos detalles de cómo se mueven los quarks. Su movimiento define lo que llamamos «protón».

El análisis detallado de los tres tipos de experimentos —con electrones, con muones y con neutrinos— acertó también a detectar un nuevo tipo de partícula, el gluón. Los gluones son los vehículos de la interacción fuerte, y sin ellos los datos no se podrían explicar. Este mismo análisis dio detalles cuantitativos de la manera en que los quarks dan vueltas los unos alrededor de los otros en su prisión protónica. Veinte años de este tipo de estudio (el nombre técnico es «funciones de estructura») nos han dado un depurado modelo que explica todos los experimentos de colisión en los que se dirijan protones, neutrones, electrones, muones y neutrinos, y además fotones, piones y antiprotones, contra protones. Esto es Monet exagerado. Quizá el poema de Wallace Stevens «Trece maneras de mirar a un mirlo» sería una comparación más oportuna.

Como podéis ver, aprendemos muchas cosas para explicar qué entra y qué sale. Aprendemos acerca de las fuerzas y de cómo originan estructuras complejas del estilo de los protones (formados por tres quarks) y los mesones (compuestos por un quark y un antiquark). Con tanta información complementaria, cada vez importa menos que no podamos ver dentro de la caja negra donde en realidad sucede la colisión.

Uno no puede por menos que sentirse impresionado por la secuencia de «semillas dentro de las semillas». La molécula está formada por átomos. La región central del átomo es el núcleo. El núcleo está formado por protones y neutrones. El protón y el neutrón están formados por quarks. Los quarks están formados por… ¡so, quietos! No se pueden descomponer los quarks, pensamos, pero, por supuesto, no estamos seguros. ¿Quién se atrevería a decir que hemos llegado al final del camino? Sin embargo, el consenso es ese —en el momento presente— y, al fin y al cabo, Demócrito no puede vivir para siempre.

Tenemos todavía que examinar un proceso importante que puede ocurrir durante una colisión. Podemos hacer partículas nuevas. Pasa todo el rato en casa. Mirad la lámpara que valientemente intenta iluminar esta oscura página. ¿Cuál es la fuente de la luz? La electricidad, a la que agita la energía eléctrica que se vierte en el filamento de la bombilla o, si sois eficientes en el uso de la energía, en el gas de la lámpara fluorescente. Los electrones emiten fotones. Ese es el proceso. En el lenguaje más abstracto del físico de partículas, el electrón puede radiar en el proceso de colisión un fotón. El electrón (por mediación del enchufe de la pared) proporciona la energía gracias a un proceso de aceleración.

Ahora tenemos que generalizar. En el proceso de creación, nos constriñen las leyes de la conservación de la energía, el momento, la carga y el respeto a todas las demás reglas cuánticas. Además, el objeto que, de la forma que sea; es responsable de la creación de una nueva partícula tiene que estar «conectado» a la partícula que se crea. Ejemplo: un protón choca con otro, y se hace una nueva partícula, un pión. Lo escribimos de esta forma:

p+ + p+ = p+ + π+ + n

Es decir, los protones (p+) chocan y producen otro protón, un pión positivo (π+) y un neutrón (n). Todas estas partículas están conectadas mediante la interacción fuerte; se trata de un proceso de creación típico. De forma alternativa, cabe ver este proceso como un protón que está «bajo la influencia» de otro protón, que se disuelve en un «pi más» y un neutrón.

Otro tipo de creación, un proceso raro y apasionante que lleva el nombre de aniquilación, tiene lugar cuando chocan la materia y la antimateria. La palabra aniquilación se usa en su más estricto sentido del diccionario, en el de que algo desaparezca de la existencia. Cuando un electrón choca con su antipartícula, el positrón, la partícula y la antipartícula desaparecen, y en su lugar aparece momentáneamente energía en la forma de un fotón. A las leyes de la conservación no les gusta este proceso, así que el fotón es temporal y deben crearse pronto dos partículas en su lugar (por ejemplo, otro electrón y otro positrón). Con menor frecuencia el fotón se puede disolver en un muón y un antimuón, o incluso en un protón positivo y un antiprotón negativo. La aniquilación es el único proceso que es totalmente eficiente en convertir masa en energía de acuerdo con la ley de Einstein, E = mc². Cuando estalla una bomba nuclear, por ejemplo, sólo una fracción de un 1 por 100 de su masa atómica se convierte en energía. Cuando chocan la materia y la antimateria, desaparece el 100 por 100 de la masa.

Cuando estamos haciendo partículas nuevas, el requisito primario es que haya bastante energía, y E = mc² es nuestra herramienta de contabilidad. Por ejemplo, ya mencionamos que la colisión entre un electrón y un positrón puede dar lugar a un protón y un antiprotón, o un p y un p barra, como los llamamos. Como la energía de la masa en reposo de un protón es de alrededor de 1 GeV, las partículas de la colisión original deben aportar al menos 2 GeV para que se produzca el par p y p barra. Una energía mayor aumenta la probabilidad de este resultado y da a los objetos recién producidos alguna energía cinética, lo que hace más fácil detectarlos.

La naturaleza «glamourosa» de la antimateria ha suscitado la noción de ciencia ficción de que podría resolver la crisis de la energía. La verdad es que un kilogramo de antimateria proporcionaría suficiente energía para que los Estados Unidos tirasen durante un día. La razón es que toda la masa del antiprotón (más el protón que se lleva a la aniquilación total) se convierte en energía según E = mc². Al quemar carbón o petróleo sólo una mil millonésima de la masa se convierte en energía. En los reactores de fisión ese número es el 0,1 por 100, y en el suministro de energía por la fusión, hace tanto tiempo esperado, es de alrededor del (¡no contengáis la respiración!) 0,5 por 100.

Otra forma de considerar estas cosas es imaginarse que todo el espacio, hasta el espacio vacío, está barrido por partículas, todas las que la naturaleza en su infinita sabiduría puede proporcionar. No es una metáfora. Una de las consecuencias de la teoría cuántica es que en el vacío saltan partículas verdaderamente a la existencia y salen de ella. Esas partículas, de todos los tamaños y formas son sin excepción temporales. Se crean, y enseguida desaparecen; es un bazar de frenética actividad. Como quiera que ocurra en el espacio donde nada hay, en el vacío, no ocurre en realidad nada. Es una fantasmagoría cuántica, pero quizá sirva para explicar qué pasa en una colisión. Aquí aparece y desaparece un par de quarks encantados (un cierto tipo de quark y su antiquark); allí se juntan un quark bottom y su antiquark. Y esperad, por allá, ¿qué es eso? Bueno, cualquier cosa: un X y un anti-X aparecen, algo que no conozcamos todavía en 1993.

Hay reglas en esta locura caótica. Los números cuánticos deben sumar cero, el cero del vacío. Otra regla: cuanto más pesados sean los objetos, menos frecuente será su evanescente aparición. Toman «prestada» energía al vacío para aparecer durante la más insignificante fracción de segundo; luego desaparecen porque deben devolverla en un tiempo que especifican las relaciones de incertidumbre de Heisenberg. La clave es esta: si se puede proporcionar la energía desde el exterior, la aparición virtual transitoria de estas partículas originadas en el vacío puede que se convierta en una existencia real, que quepa detectar con las cámaras de burbujas o los contadores. ¿Proporcionada cómo? Bueno, si una partícula de gran energía, recién salida del acelerador y a la caza de nuevas partículas, puede permitirse pagar el precio —es decir, por lo menos la masa en reposo del par de quarks o de X—, se lo reembolsa al vacío, y decimos que nuestra partícula acelerada ha creado un par quark-antiquark. Está claro que cuanto más pesadas sean las partículas que se quieran crear, más energía necesitaremos que nos dé la máquina. En los capítulos 7 y 8 conoceréis muchas partículas nuevas que vinieron a la existencia justo de esa manera. Dicho sea de paso, esta fantasía cuántica de un vacío que todo lo impregna lleno de «partículas virtuales» tiene otras consecuencias experimentales; modifica, por ejemplo, la masa y el magnetismo de los electrones y los muones. Lo explicaremos con detalle más adelante, cuando lleguemos al experimento «g menos 2».

A partir de la era de Rutherford se puso en marcha la carrera cuya meta era la construcción de dispositivos que pudiesen alcanzar energías muy grandes. A lo largo de los años veinte las compañías eléctricas contribuyeron a este esfuerzo porque la energía eléctrica se transmite más eficazmente cuando el voltaje es alto. Otra motivación fue la creación de rayos X para el tratamiento del cáncer. El radio ya se usaba para destruir tumores, pero era carísimo y se creía que una radiación de mayor energía supondría una gran ventaja. Por lo tanto, las compañías eléctricas y los institutos de investigación médica apoyaron el desarrollo de generadores de alto voltaje. Rutherford, como era característico en él, marcó la pauta cuando planteó a la Metropolitan-Vickers Eléctrical Company de Inglaterra el reto de que «nos diese un potencial del orden de los diez millones de voltios que pudiese instalarse en una sala de tamaño razonable… y un tubo en el que se haya hecho el vacío capaz de soportar ese voltaje».

Los físicos alemanes intentaron embridar el inmenso voltaje de las tormentas alpinas. Colgaron un cable aislado entre dos picos de montaña; canalizó cargas de nada menos que 15 millones de voltios e indujo chispas enormes que saltaron cinco metros y medio entre dos esferas metálicas. Espectacular, pero no muy útil. Este método se abandonó cuando un científico murió mientras estaba ajustando el aparato.

El fracaso del equipo alemán demostró que se necesitaba algo más que energía. Había que encerrar los terminales del hueco en un tubo de rayos o en una cámara de vacío que fuese un aislante muy bueno. (A los grandes voltajes les encanta formar arcos entre los aislantes a menos que el diseño sea muy preciso). El tubo tenía que ser además lo suficientemente resistente para soportar que se le extrajese el aire. Era esencial un vacío de alta calidad; si quedaban muchas moléculas residuales flotando en el tubo interferían con el haz. Y el alto voltaje tenía que ser lo bastante estable para que acelerase muchas partículas. Se trabajó en estos y otros problemas técnicos de 1926 a 1933, hasta que se resolvieron.

La competencia fue intensa en toda Europa, y las instituciones y los científicos estadounidenses se unieron al jaleo. Un generador de impulsos construido por la Allgemeine Elektrizität Gesellschaft en Berlín llegó a los 2,4 millones de voltios pero no producía partículas. La idea pasó a la General Electric en Schenectady, que mejoró la cantidad de energía y la llevó a los 6 millones de voltios. En la Institución Carnegie de Washington, distrito de Columbia, el físico Merle Tuve consiguió con una bobina de inducción varios millones de voltios en 1928, pero tenía un tubo de rayos adecuado. Charles Lauritsen, del Cal Tech, fue capaz de construir un tubo de vacío que soportase 750.000 voltios. Tuve tomó el tubo de Lauritsen y produjo un haz de 10¹³ (10 billones) de protones por segundo a 500.000 voltios, en teoría una energía y un número de partículas suficiente para sondear el núcleo. Tuve, en realidad, consiguió que hubiese colisiones nucleares, pero sólo en 1933, y por entonces otros dos proyectos se le habían adelantado.

Otro corredor en la carrera fue Robert Van de Graaff, de Yale y luego del MIT, que construyó una máquina que llevaba las cargas eléctricas con una banda de seda sin fin a una gran esfera metálica, aumentando gradualmente el voltaje de la esfera hasta que, al llegar a unos pocos millones de voltios, lanzaba un tremendo arco a la pared del edificio. Este era el hoy famoso generador de Van de Graaff, conocido por los estudiantes de física de bachillerato en todas partes. Al aumentar el radio de la esfera se pospone la descarga. Meter la esfera entera en nitrógeno líquido servía para incrementar el voltaje. Al final, los generadores de Van de Graaff serían las máquinas preferidas en la categoría de menos de 10 millones de voltios, pero hicieron falta años para perfeccionar la idea.

La carrera continuó durante los últimos años de la década de 1920 y los primeros de la siguiente. Ganó una pareja de la banda del Cavendish de Rutherford, John Cockcroft y Ernest Walton, pero por un pelo. Y (tengo que reconocerlo a regañadientes) tuvieron la preciosa ayuda de un teórico. Cockcroft y Walton intentaban, tras numerosos fracasos, llegar al millón de voltios que parecía necesario para sondear el núcleo. Un teórico ruso, George Gamow, había estado visitando a Niels Bohr en Copenhague, y decidió darse una vuelta por Cambridge antes de volver a casa. Allí tuvo una discusión con Cockcroft y Walton, y les dijo a estos experimentadores que no les hacía falta tanto voltaje como se traían entre manos: Argumentó que la nueva teoría cuántica permitía que se penetrase con éxito en el núcleo aun cuando la energía no fuese lo bastante alta para superar la repulsión eléctrica del núcleo. Explicó que la teoría cuántica daba a los protones propiedades ondulatorias que podían atravesar como por un túnel la «barrera» de la carga nuclear; lo hemos examinado en el capítulo 5. Cockcroft y Walton tomaron por fin nota y modificaron el diseño de su aparato para que diese 500.000 voltios. Por medio de un transformador y un circuito multiplicador de voltaje aceleraron los protones que salían de un tubo de descarga del tipo que J. J. Thomson había utilizado pura generar los rayos catódicos.

En la máquina de Cockcroft y Walton se aceleraban erupciones de protones, alrededor de un billón por segundo, por el tubo de vacío, y se las estrellaba contra blancos de plomo, litio y berilio. Era 1930 y por fin se habían provocado reacciones nucleares mediante partículas aceleradas. El litio se desintegró con protones de tan sólo 400.000 eV, muy por debajo de los millones de electronvoltios que se había creído eran necesarios. Fue un acontecimiento histórico. Se disponía, pues, de un nuevo tipo de «cuchillo», si bien todavía en su forma más primitiva.

La acción pasa ahora a Berkeley, California, adonde Ernest Orlando Lawrence, nativo de Dakota del Sur, había llegado en 1928 tras un brillante comienzo en la investigación física en Yale. E. O. Lawrence inventó una técnica radicalmente diferente de acelerar las partículas; empleaba una máquina que llevaba el nombre de ciclotrón, por la que recibió el premio Nobel en 1939. Lawrence conocía bien las engorrosas máquinas electrostáticas, con sus voltajes enormes y sus frustrantes derrumbamientos eléctricos, y se le ocurrió que tenía que haber un camino mejor. Rastreando por la literatura en busca de maneras de conseguir una gran energía sin grandes voltajes, dio con los artículos de un ingeniero noruego, Rolf Wideröe. A Wideröe se le ocurrió que cabía doblar la energía de una partícula sin doblar el voltaje si se la hacía pasar por dos huecos en fila. La idea de Wideröe es el fundamento de lo que hoy se llama un acelerador lineal. Se pone un hueco tras otro a lo largo de una línea, y las partículas toman energía en cada uno de ellos.

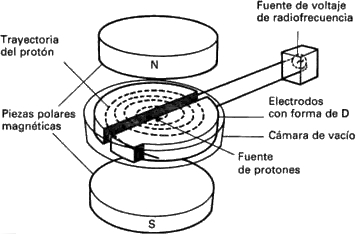

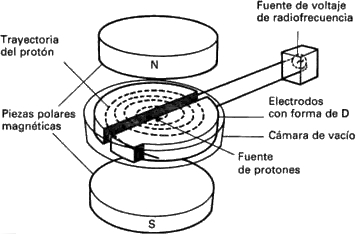

El artículo de Wideröe, sin embargo, le dio a Lawrence una idea aún mejor. ¿Por qué no usar un solo hueco con un voltaje modesto, pero por el que se pasase una y otra vez? Lawrence razonó que cuando una partícula cargada se mueve en un campo magnético su trayectoria se curva y se convierte en un círculo. El radio del círculo está determinado por la intensidad del imán (a imán más fuerte, radio menor) y el momento de la partícula cargada (a mayor momento, mayor radio). El momento es simplemente la masa de la partícula por su velocidad. Esto quiere decir que un imán intenso guiará a la partícula de forma que se mueva por un círculo diminuto, pero si la partícula gana energía y por lo tanto momento, el radio del círculo crecerá.

Imaginaos una caja de sombreros emparedada entre los polos norte y sur de un gran imán. Haced la caja de latón o de acero inoxidable, de algo que sea fuerte pero no magnético. Extraedle el aire. Dentro de la caja hay dos estructuras de cobre huecas en forma de D que casi llenan la caja: los lados rectos de las D están abiertos y se encaran con un pequeño hueco entre ambas, los lados curvos están cerrados. Suponed que una D está cargada positivamente, la otra negativamente, con una diferencia de potencial de, digamos, 1.000 voltios. Una corriente de protones generados (no importa cómo) cerca del centro del círculo se dirige, a través del hueco, de la D positiva a la negativa. Los protones ganan 1.000 voltios y su radio de giro crece porque el momento es mayor. Giran dentro de la D, y cuando vuelven al hueco, gracias a una conmutación inteligente, ven de nuevo un voltaje negativo. Se aceleran otra vez, y tienen ahora 2.000 eV. El proceso sigue. Cada vez que cruzan el hueco, ganan 1.000 eV. A medida que ganan momento van luchando contra el poder constrictivo del imán, y el radio de su trayectoria no deja de crecer. El resultado es que describen una espiral a partir del centro de la caja hacia el perímetro. Allí dan en un blanco, ocurre una colisión, y la investigación empieza.

La clave de la aceleración en el sincrotrón estriba en asegurarse de que los protones vean siempre una D negativa al otro lado del hueco. La polaridad tiene que saltar rápidamente de D a D de una manera sincronizada exactamente con la rotación de las partículas. Pero, os preguntaréis quizá, ¿no es difícil sincronizar el voltaje alterno con los protones, cuyas trayectorias no dejan de describir círculos cada vez mayores a medida que continúa la aceleración? La respuesta es no. Lawrence descubrió que, gracias a lo listo que es Dios, los protones que giran en espiral compensan que su camino sea más largo acelerándose. Completan cada semicírculo en el mismo tiempo; a este proceso se le da el nombre de aceleración resonante. Para que las órbitas de los protones casen, hace falta un voltaje alterno de frecuencia fija, técnica que se conocía bien gracias a la radiofonía. De ahí el nombre del mecanismo conmutador de la aceleración: generador de radiofrecuencia. En este sistema los protones llegan al borde del hueco justo cuando la D opuesta tiene un máximo de voltaje negativo.

Lawrence elaboró la teoría del ciclotrón en 1929 y 1930. Más tarde diseñó, sobre el papel, una máquina en la que los protones daban cien vueltas con una generación de 10.000 voltios a través del hueco de la D. De esa forma obtenía un haz de protones de 1 MeV (10.000 voltios × 100 vueltas = l MeV). Un haz así sería «útil para el estudio de los núcleos atómicos». El primer modelo, construido en realidad por Stanley Livingston, uno de los alumnos de Lawrence, se quedó muy corto: sólo llegó a los 80 KeV (80.000 voltios). Lawrence se convirtió por entonces en una estrella. Consiguió una subvención enorme (¡1.000 dólares!) para que construyese una máquina que produjera desintegraciones nucleares. Las piezas polares (las piezas que hacían de polos norte y sur del imán) tenían veinticinco centímetros de diámetro, y en 1932 la máquina aceleró los protones hasta una energía de 1,2 MeV. Se utilizaron para producir colisiones nucleares en el litio y en otros elementos sólo unos cuantos meses después de que lo hiciese el grupo de Cockcroft y Walton en Cambridge. En segundo lugar, pero Lawrence todavía se encendió un puro.

Lawrence fue un emprendedor y agitador de energía y capacidad enormes. Fue el padre de la Gran Ciencia. La expresión se refiere a las instalaciones centralizadas y gigantescas de gran complejidad y coste compartidas por un gran número de científicos. En su evolución, la Gran Ciencia creó nuevas formas de llevar a cabo la investigación con equipos de científicos. Creó también agudos problemas sociológicos, de los que hablaremos más adelante. No se había visto a nadie como Lawrence desde Tycho Brahe, el Señor de Uraniborg, el laboratorio de Hven. En el terreno experimental, Lawrence hizo de los Estados Unidos un serio participante en el mundo de la física. Contribuyó a la mística de California, a ese amor por las extravagancias técnicas, por las empresas complejas y caras. Eran retos que irritaban a la joven California y, en realidad, a los jóvenes Estados Unidos.

A la altura de 1934 Lawrence había producido haces de deuterones de 5 MeV con un ciclotrón de noventa y cuatro centímetros. El deuterón, un núcleo formado por un protón y un neutrón, se había descubierto en 1931, y se había demostrado que era un proyectil más eficaz que el protón para producir reacciones nucleares. En 1936 tenía un haz de deuterones de 8 MeV. En 1939 una máquina de metro y medio operaba a 20 MeV. Un monstruo que se empezó a construir en 1940 y se completó tras la guerra tenía un imán que pesaba ¡10.000 toneladas! Por su capacidad de desentrañar los misterios del núcleo se construyeron ciclotrones en distintas partes del mundo. En medicina se usaron para tratar tumores. Un haz de partículas dirigido al tumor deposita bastante energía en él para destruirlo. En los años noventa, hay alrededor de mil ciclotrones en uso en los hospitales de los Estados Unidos. La investigación básica de la física de partículas, sin embargo, ha abandonado el ciclotrón en favor de un nuevo tipo de máquina.

El impulso para crear energías aún mayores se intensificó y se extendió por todo el mundo. A cada nuevo dominio de energía se hicieron nuevos descubrimientos. Nacieron también nuevos problemas que había que resolver y que no hacían sino que creciera el deseo de obtener energías mayores. La riqueza de la naturaleza parecía oculta en el micromundo nuclear y subnuclear.

Al ciclotrón lo limita su propio diseño. Como las partículas giran en espiral hacia afuera, el número de órbitas queda, como es obvio, limitado por la circunferencia del aparato. Para obtener más órbitas y más energía, hace falta un ciclotrón mayor. Hay que aplicar el campo magnético a toda el área espiral, así que los imanes deben ser grandes… y caros. Entra el sincrotrón. Si se pudiera lograr que la órbita de las partículas, en vez de describir una espiral hacia afuera, mantuviese un radio constante, sólo se necesitaría el imán a lo largo de la trayectoria estrecha de la órbita. A medida que las partículas ganasen energía, se podría incrementar sincrónicamente el campo magnético para mantenerlas encerradas en una órbita de radio constante. ¡Inteligente! Se ahorraron toneladas y toneladas de hierro, pues así era posible reducir las piezas magnéticas polares, transversales al camino del haz, a un tamaño de unos cuantos centímetros, en vez de decímetros.

Deben mencionarse dos detalles importantes antes de que procedamos con los años noventa. En un ciclotrón, las partículas cargadas (protones o deuterones) viajan a lo largo de miles —a ese número se llegó— de vueltas en una cámara de vacío pinzada entre los polos de un imán. Para evitar que las partículas se desperdigasen y golpeasen las paredes de la cámara, era absolutamente esencial que hubiese algún tipo de proceso de enfoque. Lo mismo que una lente enfoca la luz de un destello en un haz (casi) paralelo, la fuerza magnética se usa para comprimir las partículas en un haz bien apretado.

En el ciclotrón esta acción de enfoque la provee la forma en que el campo magnético cambia a medida que los protones se mueven hacia el borde exterior del imán. Robert R. Wilson, joven alumno de Lawrence que más tarde construiría el acelerador del Fermilab, fue el primero en percatarse del efecto, sutil pero decisivo, que tenían las fuerzas magnéticas de evitar que los protones se desperdigasen. En los primeros sincrotrones se daba a las piezas polares unas formas que ofreciesen esas fuerzas. Más tarde se usaron unos imanes cuadripolares especialmente diseñados (con dos polos nortes y dos polos sur) para que enfocasen las partículas, mientras, aparte, unos imanes dipolares las conducían por una órbita fija.

El Tevatrón del Fermilab, una máquina de un billón de electronvoltios que se terminó en 1983, es un buen ejemplo. Las partículas son llevadas por una órbita circular mediante poderosos imanes superconductores, de manera parecida a como las vías guían el tren por una curva. El conducto del haz, donde se ha hecho un alto vacío, es un tubo de acero inoxidable (no magnético) de sección oval, de unos ocho centímetros de ancho y cinco de alto, centrado entre los polos norte y sur de los imanes. Cada imán (guiador) dipolar tiene 64 metros de largo. Los «quads», los imanes cuadripolares, miden metro y medio. Hacen falta más de mil imanes para cubrir la longitud del tubo. El conducto, el haz y la combinación de los imanes completan un círculo cuyo radio es de un kilómetro; toda una diferencia con respecto al primer modelo de Lawrence, que medía diez centímetros. Podéis ver aquí la ventaja del diseño sincrotrónico. Se necesitan muchos imanes, pero no son, hasta cierto punto, muy voluminosos; su ancho es el justo para cubrir la conducción de vacío. Si el Tevatrón fuera un ciclotrón, nos haría falta un imán cuyas piezas polares tuvieran un diámetro de ¡dos kilómetros, para cubrir los más de seis de longitud de la máquina!

Las partículas dan 50.000 vueltas por segundo a esa pista de seis kilómetros y pico. En diez segundos viajan más de tres millones de kilómetros. Cada vez que pasan por un hueco —en realidad una serie de cavidades especialmente construidas—, un voltaje de radiofrecuencia les propina una energía de alrededor de 1 MeV. Los imanes que las mantienen enfocadas las dejan desviarse de las rutas que se les asignan apenas un cuarto de centímetro en todo el viaje. No es perfecto, pero sí lo bastante bueno. Es como apuntar con un rifle a un mosquito que está en la Luna y darle en el ojo que no es. Para mantener los protones en la misma órbita mientras se los acelera, la intensidad de los imanes debe aumentar en sincronía precisa con la ganancia de energía de aquéllos.

El segundo detalle importante tiene que ver con la teoría de la relatividad: los protones se vuelven, de forma detectable, más pesados cuando su energía supera los 20 MeV, más o menos. Este incremento de la masa destruye la «resonancia ciclotrónica» que Lawrence descubrió y gracias a la cual los protones que giran en espiral compensan con exactitud la mayor longitud de su trayectoria acelerándose. Gracias a esa resonancia se puede sincronizar la rotación con una frecuencia fija del voltaje que acelera las partículas a través del hueco. A una energía mayor, el tiempo de rotación crece, y ya no se puede aplicar un voltaje de radiofrecuencia constante. Para contrarrestar la ralentización, la frecuencia aplicada debe disminuir y por ello se utilizan voltajes aceleradores de frecuencia modulada (FM), con los que se sigue el incremento de masa de los protones. El sincrociclotrón, un ciclotrón de frecuencia modulada, fue el primer ejemplo del efecto de la relatividad en los aceleradores.

El sincrotrón de protones resuelve el problema de una manera aún más elegante. Es un poco complicado, pero se basa en que la velocidad de la partícula (99 coma lo que sea por 100 de la velocidad de la luz) es esencialmente constante. Suponed que la partícula cruza el hueco en esa parte del ciclo de radiofrecuencia en que el voltaje acelerador es cero. No hay aceleración. Aumentemos ahora el campo magnético un poco. La partícula describe un círculo más cerrado y llega un poco antes al hueco; ahora la radiofrecuencia está en una fase que acelera. La masa, pues, crece, el radio de la órbita también y estamos de vuelta a donde empezamos pero con una energía mayor. El sistema se corrige a sí mismo. Si la partícula gana demasiada energía (masa), su radio de giro aumentará, llegará más tarde al hueco y verá un voltaje desacelerador, lo que corregirá el error. El aumento del campo magnético tiene el efecto de incrementar la energía de masa de nuestra heroína la partícula. Este método depende de la «estabilidad de fase», que se estudia en este mismo capítulo, más adelante.

Uno de los primeros aceleradores me fue cercano y querido: el sincrociclotrón de 400 MeV de la Universidad de Columbia, construido en una finca de Irvington-on-Hudson, Nueva York, a no muchos minutos de Manhattan. La finca, a la que se puso el nombre de la ancestral montaña escocesa Ben Nevis, fue creada en la época colonial por Alexander Hamilton. Más tarde la poseyó una rama de la familia Du Pont, y luego la Universidad de Columbia. El ciclotrón de Nevis, construido entre 1947 y 1949, fue uno de los aceleradores de partículas más productivos del mundo durante sus veintitantos años de funcionamiento (1950-1972). Produjo además ciento cincuenta y tantos doctores, alrededor de la mitad de los cuales se quedaron en el campo de la física de partículas y fueron profesores de Berkeley, Stanford, Cal Tech, Princeton y muchas otras instituciones de tres al cuarto. La otra mitad fue a todo tipo de sitios: pequeñas instituciones de enseñanza, laboratorios gubernamentales, a la investigación industrial, a las finanzas…

Yo era un estudiante graduado cuando el presidente (de Columbia) Dwight Eisenhower inauguró la instalación en junio de 1950 con una pequeña ceremonia celebrada sobre el césped de la hermosa finca —árboles magníficos, arbustos, unas cuantas construcciones de ladrillo rojo—, que se inclinaba hacia el impresionante río Hudson. Tras el correspondiente discurseo, Ike le dio a un botón y por los altavoces salieron los «pitidos» amplificados de un contador Geiger, que señalaban la existencia de radiación. Producía los pitidos una fuente radiactiva que yo sostenía cerca de un contador de partículas porque la máquina había escogido justo ese momento para romperse. Ike nunca se enteró.

¿Por qué 400 MeV? La partícula de moda en 1950 era el pión, o mesón pi, como se le llama también. Un físico teórico japonés, Hideki Yukawa, predijo el pión en 1936. Se creía que era la clave de la interacción fuerte, en esos días el gran misterio. Hoy pensamos en ella basándonos en los gluones. Pero volviendo a aquellos días, los piones, que van y vienen entre los protones y los neutrones para mantenerlos muy juntos en el núcleo, eran la clave, y necesitábamos hacerlos y estudiarlos. Para producir piones en las colisiones nucleares, la partícula que sale del acelerador debe tener una energía mayor que mpión c², es decir, mayor que la masa en reposo del pión. Al multiplicar la masa en reposo del pión por la velocidad de la luz al cuadrado, nos sale 140 MeV, la energía de esa masa en reposo. Como sólo una parte de la energía de colisión va a parar a la producción de partículas nuevas, necesitábamos una energía extra, y nos quedamos en 400 MeV. La máquina de Nevis se convirtió en una fábrica de piones.

Pero esperad. Antes hay que decir unas palabras acerca de cómo supimos que existían los piones. A finales de los años cuarenta, los científicos de la Universidad de Bristol, en Inglaterra, se percataron de que una partícula alfa «activa» al atravesar una emulsión fotoeléctrica depositaba sobre una placa de cristal las moléculas que caían en su trayectoria. Al procesar la película, se ve una traza definida por los granos de bromuro de plata, que se discierne con facilidad mediante un microscopio de poco poder de resolución. El grupo de Bristol envió en globo lotes de emulsiones muy espesas hasta la parte más alta de la atmósfera, donde la intensidad de los rayos cósmicos es mucho mayor que a nivel del mar. Esta fuente de radiación producida «naturalmente» aportaba una energía que excedía en mucho a las insignificantes alfas de 5 MeV de Rutherford. En esas emulsiones expuestas a los rayos cósmicos, Cesare Lattes, brasileño, Giuseppe Occiallini, italiano, y C. F. Powell, el profesor residente en Bristol, descubrieron, en 1947, el pión.

El más llamativo del trío era Occiallini, a quien sus amigos conocían por Beppo. Espeleólogo aficionado, bromista compulsivo, era la fuerza que movía al grupo. Instruyó a una legión de mujeres jóvenes para que hiciesen el penoso trabajo de estudiar las emulsiones con el microscopio. El supervisor de mi tesis, Gilberto Bernardini, muy amigo de Beppo, le visitó un día en Bristol. Como le señalaban a dónde tenía que ir en perfecto inglés, idioma que le parecía muy difícil, Bernardini se perdió enseguida. Finalmente, fue a parar a un laboratorio donde varias señoras muy inglesas miraban por unos microscopios y maldecían en un argot italiano que se habría prohibido en los muelles de Génova. «Ecco! —exclamó Bernardini con su acento característico— es el laboratorio de Beppo!».

Lo que las trazas de esas emulsiones mostraban era una partícula, el pión, que entra a gran velocidad, se frena gradualmente (la densidad de los granos de bromuro de plata aumenta a medida que la partícula se frena) y acaba por pararse. Al final de la traza aparece una nueva partícula; lleva mucha energía y sale a toda velocidad. El pión es inestable y se desintegra en una centésima de microsegundo en un muón (la nueva partícula al final de la traza) y algo más. Ese algo más resultó que era un neutrino, que no deja trazas en la emulsión. La reacción se escribe:

π → μ + ν

Es decir, un pión da (termina por dar) lugar a un muón y un neutrino. Como la emulsión no ofrece información sobre la secuencia temporal, había que efectuar un análisis meticuloso de las trazas de media docena de esos raros acontecimientos para saber de qué partícula se trataba y cómo se desintegró. Tenían que estudiar la nueva partícula, pero el uso de rayos cósmicos ofrecía sólo un puñado de sucesos así por año. Como pasaba con las desintegraciones nucleares, se requerían aceleradores que tuvieran una energía lo bastante alta.

En Berkeley, el ciclotrón de 467 centímetros de Lawrence empezó a producir piones, como la máquina de Nevis. El pión en sus interacciones fuertes con los neutrones y los protones pronto fue estudiado por los sincrociclotrones de Rochester, Liverpool, Pittsburgh, Chicago, Tokio, París y Dubna (cerca de Moscú), así como la interacción débil en la desintegración radiactiva del pión. Otras máquinas, en Cornell, en el Cal Tech, en Berkeley y en la Universidad de Illinois, utilizaban electrones para producir los piones, pero las máquinas que tuvieron más éxito fueron los sincrociclotrones de protones.

Ahí estaba yo, en el verano de 1950, con una máquina que pasaba por las penalidades del parto y mi necesidad de unos datos con los que pudiera obtener un doctorado y ganarme la vida. Se jugaba a los piones. Dale a un trozo de algo —carbón, cobre, cualquier cosa que contenga núcleos— con los protones de 400 MeV de la máquina de Nevis, y deberías generar piones. Berkeley había contratado a Lattes, y éste enseñó a los físicos la manera de exponer y procesar las emulsiones muy sensibles que se utilizaron con tanto éxito en Bristol. Insertaron una pila de emulsiones en el tanque de vacío del haz y dejaron que los protones diesen en un blanco próximo a la pila. Sacad las emulsiones por una cámara hermética, procesadlas (una semana de trabajo) y sometedlas por fin a estudio microscópico (¡meses!). Tanto esfuerzo sólo le dio al equipo de Berkeley unas pocas docenas de sucesos de pión. Tenía que haber un camino más sencillo. El problema era que había que instalar los detectores de partículas dentro de la máquina, en la región del potente imán acelerador, para registrar los piones, y el único dispositivo práctico era la pila de emulsiones. De hecho, Bernardini planeaba un experimento de emulsiones en la máquina de Nevis similar al que la gente de Berkeley había realizado. La gran, elegante cámara de niebla que yo había construido para mi doctorado era un detector mucho mejor, pero era imposible que encajase entre los polos de un imán dentro de un acelerador. Y no sobreviviría como detector de partículas en la intensa radiación que había dentro del acelerador. Entre el imán del ciclotrón y el área experimental había un muro de hormigón de tres metros de espesor que encerraba la radiación descarriada.

Había llegado a Columbia un nuevo posdoctorado, John Tinlot, procedente del afamado grupo de rayos cósmicos de Bruno Rossi en el MIT. Tinlot era la quintaesencia del físico. Poco antes de cumplir los veinte años había sido violinista con calidad de concertista, pero abandonó el violín tras tomar la agónica decisión de estudiar física. Fue el primer doctor joven con el que trabajé, y aprendí muchísimo de él. No sólo física. John llevaba el juego, a las cartas, a los dados, a los caballos, en los genes: long shots, blackjack, craps, ruleta, póquer, mucho póquer. Jugaba durante los experimentos, mientras se tomaban los datos. Jugaba en las vacaciones, en los trenes y en los aviones. Era una manera moderadamente cara de aprender física; mis pérdidas las moderaban los demás jugadores, los estudiantes, técnicos y guardas de seguridad que John reclutase. No tenía piedad.

John y yo nos sentábamos en el suelo del acelerador, que-todavía-no-funcionaba-en-realidad, tomábamos cerveza y hablábamos de lo habido y por haber. «¿Qué les pasa realmente a los piones que salen del blanco?», me preguntaba de pronto. Yo había aprendido a ser cauto. John jugaba en física como a los caballos. «Bueno, si el blanco está dentro de la máquina [y tenía que estarlo, no sabíamos cómo sacar los piones acelerados del ciclotrón], el imán es tan potente que los desperdigará en todas las direcciones», respondí con cautela.

John: ¿Saldrá alguno de la máquina y dará en el muro protector?

Yo: Seguro, pero por todas partes.

John: ¿Por qué no los encontramos?

Yo: ¿Cómo?

John: Hagamos una delineación magnética.

Yo: Eso es trabajo. [Eran las ocho de la tarde de un viernes.]

John: ¿Tenemos la tabla de los campos magnéticos medidos?

Yo: Se supone que tengo que irme a casa.

John: Usaremos esos rollos enormes de papel marrón de embalar y dibujaremos las trayectorias de los piones a una escala uno a uno…

Yo: ¿El lunes?

John: Tú te encargas de la regla de cálculo [era 1950] y yo dibujo las trayectorias.

Bueno, a las cuatro de la madrugada del sábado habíamos hecho un descubrimiento fundamental que cambiaría la manera en que se usaban los ciclotrones. Habíamos trazado los caminos de unas ochenta partículas ficticias o así que salían de un blanco introducido en el acelerador con direcciones y energías verosímiles; usamos 40, 60, 80 y 100 MeV. Para nuestra estupefacción, las partículas no iban «a cualquier sitio». Por el contrario, a causa de las propiedades del campo magnético cerca y más allá del borde del imán del ciclotrón, se curvaban alrededor de la máquina en un haz apretado. Habíamos descubierto lo que se vendría a conocer con el nombre de «enfoque del campo por el borde». Girando las grandes láminas de papel —es decir, escogiendo una posición concreta del blanco—, conseguimos que el haz de piones, con una generosa banda de energía en torno a 60 MeV, fuera derecho a mi flamante cámara de niebla. La única traba era la pared de hormigón que había entre la máquina y el área experimental donde estaba mi principesca cámara.

Nadie había caído antes en la cuenta de lo que nosotros habíamos descubierto: El lunes por la mañana nos acomodamos ante el despacho del director para echarnos encima de él en cuanto apareciese y contárselo. Teníamos tres sencillas peticiones que hacer: 1) una nueva colocación del blanco en la máquina; 2) una ventana mucho más delgada entre la cámara de vacío del haz del ciclotrón y el mundo exterior de forma que se minimizase la influencia de una placa de acero inoxidable de dos centímetros y medio sobre los piones que emergieran; y 3) un nuevo agujero de unos diez centímetros de alto por veinticinco de ancho, calculábamos, abierto en el muro de hormigón de tres metros de espesor. ¡Todos esto de parte de un humilde estudiante graduado y de un posdoctorado!

Nuestro director, el profesor Eugene Booth, era un caballero de Georgia y un académico de Rhodes que raras veces decía «mecachis». Hizo una excepción con nosotros. Razonamos, explicamos, engatusamos. Pintamos visiones de gloria. ¡Se haría famoso! ¡Imagínese un haz de piones externo, el primero que haya habido jamás!

Booth nos echó fuera, pero después del almuerzo nos llamó de nuevo. (Habíamos estado sopesando las ventajas de la estricnina con respecto al arsénico). Bernardini se había dejado caer, y Booth le colocó nuestra idea a tan eminente profesor visitante. Mi sospecha es que los detalles, expresados con la musiquilla georgiana de Booth, fueron demasiado para Gilberto, que una vez me confió: «Booos, Boosth, ¿quién puede pronunciar esos nombres norteamericanos?». Sin embargo, Bernardini nos apoyó con una exageración típicamente latina, y caímos en gracia.

Un mes más tarde, todo funcionaba bien y salía justo como en los bosquejos del papel de embalar. En unos pocos días mi cámara de niebla había registrado más piones que todos los otros laboratorios del mundo juntos. Cada fotografía (tomamos una por minuto) tenía seis o siete bellas trazas de piones. Cada tres o cuatro fotografías mostraban un rizo en la traza del pión, como si se desintegrase en un muón y «algo más». Las desintegraciones de los piones me sirvieron de tesis. En seis meses habíamos construido cuatro haces, y Nevis estaba en plena producción en cuanto fábrica de datos sobre las propiedades de los piones. A la primera oportunidad, John y yo fuimos al hipódromo de Saratoga, donde, con su suerte de siempre, consiguió un 28 a 1 en la octava carrera, contra la que se había jugado nuestra cena y el dinero de la gasolina para volver a casa. Quería de verdad a ese tipo.

John Tinlot hubo de tener una intuición extraordinaria para sospechar la existencia del enfoque del campo por el borde, que a todos los demás que se dedicaban al negocio del ciclotrón se les había escapado. Tendría luego una distinguida carrera como profesor de la Universidad de Rochester, pero murió de cáncer a los cuarenta y tres años de edad.

La segunda guerra mundial marcó una divisoria crucial entre la investigación científica de antes y después de la guerra. (¿Qué tal como afirmación polémica?). Pero marcó además una nueva fase en la búsqueda del á-tomo. Contemos algunos de los caminos. La guerra generó un salto adelante tecnológico, en muy buena parte centrado en los Estados Unidos, que no fue aplastado por el potente sonido de las cercanas explosiones que Europa sufría. El desarrollo en tiempo de guerra del radar, la electrónica, la bomba nuclear (por usar el nombre más propio) fue en cada caso un ejemplo de lo que la colaboración entre la ciencia y los ingenieros podía hacer (mientras no la maniatasen las consideraciones presupuestarias).

Vannevar Bush, el científico que dirigió la política científica de los Estados Unidos durante la guerra, expuso la nueva relación entre la ciencia y el gobierno en un elocuente informe que remitió al presidente Franklin D. Roosevelt. Desde ese momento en adelante, el gobierno de los Estados Unidos se comprometió a apoyar la investigación científica básica. El apoyo a la investigación, básica y aplicada, ascendió tan deprisa que podemos reírnos de la subvención de mil dólares por la que tan duro trabajó E. O. Lawrence a principios de los años treinta. Aun ajustándola a la inflación, esa cifra se queda en nada ante la ayuda federal a la investigación básica en 1990: ¡unos doce mil millones de dólares! La segunda guerra mundial vio además cómo una invasión de refugiados científicos procedentes de Europa se convertía en una parte fundamental del auge de la investigación en los Estados Unidos.

A principios de los años cincuenta, unas veinte universidades tenían aceleradores con los que se podían realizar las investigaciones de física nuclear más avanzadas. A medida que fuimos conociendo mejor el núcleo, la frontera se desplazó al dominio subnuclear, donde hacían falta máquinas mayores —más caras—. La época pasó a ser de consolidación: fusiones y adquisiciones científicas. Se agruparon nueve universidades para construir y gestionar el laboratorio del acelerador de Brookhaven, Long Island. Encargaron una máquina de 3 GeV en 1952 y una de 30 GeV en 1960. Las universidades de Princeton y de Pennsylvania se unieron para construir una máquina de protones cerca de Princeton. El MIT y Harvard construyeron el Acelerador de Electrones de Cambridge, una máquina de electrones de 6 GeV.

A lo largo de los años, según fue creciendo el tamaño de los consorcios, el número de máquinas de primera línea disminuyó. Necesitábamos energías cada vez mayores para abordar la pregunta «¿qué hay dentro?» y buscar los verdaderos á-tomos, o el cero y el uno de nuestra metáfora de la biblioteca. A medida que se fueron proponiendo máquinas nuevas, se dejaron de construir, para liberar fondos, las viejas, y la Gran Ciencia (expresión que suelen usar como insulto los comentaristas ignorantes) se hizo más grande. En los años cincuenta, se podían hacer quizá dos o tres experimentos por año con grupos de dos a cuatro científicos. En las décadas siguientes, la escala de los proyectos en colaboración fue cada vez mayor y los experimentos duraban más y más, llevados en parte por la necesidad de construir detectores que no dejaban de ser más complejos. En los años noventa, solo en la Instalación del Detector del Colisionador, en el Fermilab, trabajaban 360 científicos y estudiantes de doce universidades, dos laboratorios nacionales e instituciones japonesas e italianas. Las sesiones programadas se extendían durante un año o más de toma de datos, sin más interrupciones que las navidades, el 4 de julio o cuando se estropeaba algo.

Las riendas de la evolución desde una ciencia que se hacía sobre una mesa a la que se basa en unos aceleradores que miden varios kilómetros las tomó el gobierno de los Estados Unidos. El programa de la bomba durante la segunda guerra mundial dio lugar a la Comisión de Energía Atómica (la AEC), institución civil que supervisó las investigaciones relativas a las armas nucleares y su producción y almacenamiento. Se le dio, además, la misión, a modo de consorcio nacional, de financiar y supervisar la investigación básica que se refiriese a la física nuclear y lo que más tarde vendría a llamarse física de partículas.

La causa del á-tomo de Demócrito llegó incluso a los salones del Congreso, que creó el Comité Conjunto (de la Cámara de Representantes y del Senado) para la Energía Atómica con la finalidad de que prestase su supervisión. Las audiencias del comité, publicadas en unos densos folletos verdes gubernamentales, son un Fort Knox de información para los historiadores de la ciencia. En ellos se leen los testimonios de H. O. Lawrence, Robert Wilson, I. I. Rabi, J. Robert Oppenheimer, Hans Bette, Enrico Fermi, Murray Gell-Mann y muchos otros que responden pacientemente las preguntas que se les hacían sobre cómo iban las investigaciones acerca de la partícula final… y por qué requería otra máquina más. El intercambio de frases reproducido al principio de este capítulo entre el espectacular director fundador del Fermilab, Robert Wilson, y el senador John Pastore está tomado de uno de esos libros verdes.

Para completar la sopa de letras, la AEC se disolvió en la ERDA (la Oficina de Investigación y Desarrollo de la Energía), que pronto fue sustituida por el DOE (el Departamento de Energía de los Estados Unidos), del que, en el momento en que se escribe esto, dependen los laboratorios nacionales donde funcionan los estrelladores de átomos. Actualmente hay cinco laboratorios de este tipo en los Estados Unidos: el SLAC, el de Brookhaven, el de Cornell, el Fermilab y el del Supercolisionador Superconductor, aún en construcción.

Por lo general, el propietario de los laboratorios de los aceleradores es el gobierno, pero de su funcionamiento se encarga una contrata, que puede corresponder a una universidad, como la de Stanford en el caso del SLAC, o a un consorcio de universidades e instituciones, como es el caso del Fermilab. Los adjudicatarios nombran un director, y se ponen a rezar. El director lleva el laboratorio, toma todas las decisiones importantes y suele permanecer en el puesto demasiado tiempo. Como director del Fermilab de 1979 a 1989, mi principal tarea fue llevar a la práctica el sueño de Robert R. Wilson: la construcción del Tevatrón, el primer acelerador superconductor. Tuvimos además que crear un inmenso colisionador de protones y antiprotones que observase colisiones frontales a casi 2 TeV.

Mientras fui director del Fermilab me preocupó mucho el proceso de investigación. ¿Cómo podían los estudiantes y los posdoctorados jóvenes experimentar la alegría, el aprendizaje, el ejercicio de la creatividad que experimentaron los alumnos de Rutherford, los fundadores de la teoría cuántica, mi propio grupito de compañeros mientras nos rompíamos la cabeza con los problemas en el suelo del ciclotrón Nevis? Pero cuanto más me fijaba en lo que pasaba en el laboratorio, mejor me sentía. Las noches que visitaba el CDF (y el viejo Demócrito no estaba allí), veía a los estudiantes excitadísimos mientras realizaban sus experimentos. Los sucesos centelleaban en una pantalla gigante, reconstruidos por el ordenador para que a la docena o así de físicos que estuviesen de turno les fueran inteligibles. De vez en cuando, un suceso daba a entender hasta tal punto que se trataba de una «física nueva», que se oía con claridad una exclamación.

Cada proyecto de investigación en colaboración a gran escala consta de muchos grupos de cinco o diez personas: un profesor o dos, varios posdoctorados y varios estudiantes graduados. El profesor mira por su camada, para que no se le pierda en la multitud. Al principio no hacen otra cosa que diseñar, construir y probar el equipo. Luego viene el análisis de los datos. Hay tantos datos en uno de esos experimentos de colisionador, que una buena parte ha de esperar a que algún grupo complete un solo análisis antes de pasar al siguiente problema. Cada científico joven, quizá aconsejado por su profesor, escoge un problema específico que recibe la aprobación consensuada del consejo de los jefes del grupo. Y los problemas abundan. Por ejemplo, cuando se producen partículas W+ y W− en las colisiones de protones y antiprotones, ¿cuál es la forma precisa del proceso? ¿Cuánta energía se llevan los W? ¿Con qué ángulos se emiten? Y así sucesivamente. Esto o aquello podría ser un detalle interesante, o un indicio que conduzca a un mecanismo fundamental de las interacciones fuerte y débil. La tarea más apasionante de los años, noventa es hallar el quark top y medir sus propiedades. Hasta mediados de 1992 se encargaron de esa búsqueda, en el Fermilab, cuatro subgrupos del proyecto en colaboración CDF, a cargo de cuatro análisis independientes.

Ahí los físicos jóvenes actúan por su cuenta y se las ven con los complejos programas de ordenador y las inevitables distorsiones que genera un aparato imperfecto. Su problema es sacar conclusiones válidas acerca de la manera en que la naturaleza funciona, poner una pieza más del rompecabezas del micromundo. Tienen la suerte de contar con un grupo de apoyo enorme: expertos en programación, en el análisis teórico, en el arte de buscar pruebas que confirmen las conclusiones tentativas. Si hay una anomalía interesante en la forma en que los W salen de las colisiones, ¿se trata de un efecto espurio del aparato (metafóricamente, de una pequeña grieta en la lente del microscopio)? ¿Es un gazapo del programa informático? ¿O es real? Y si es real, ¿no habrá visto el compañero Henri un fenómeno similar en su análisis de las partículas Z, o quizá Marjorie al analizar los chorros de retroceso?