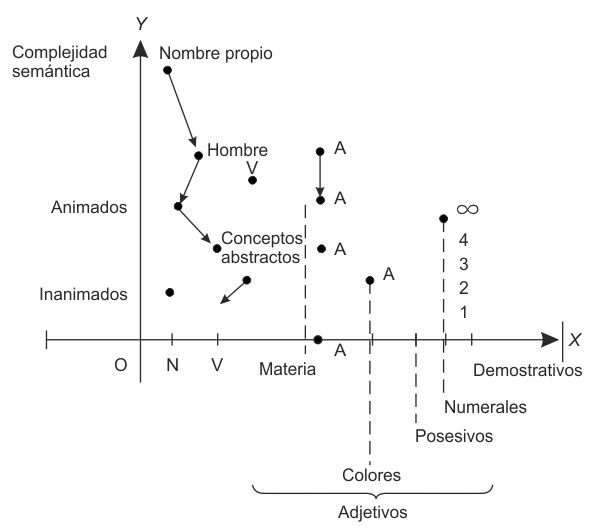

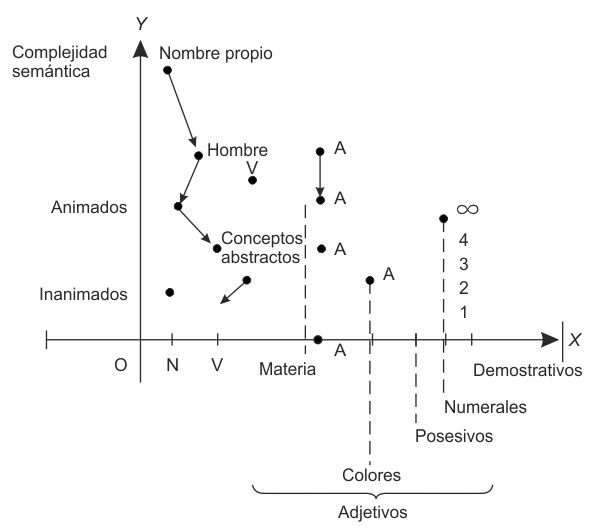

FIG. 12. La doble dimensión de la gramática universal. N, V, A abrevian, repectivamente, nombre, verbo, adjetivo.

La teoría de las catástrofes ha sido portadora de ideas aceptadas tal vez con dificultad en el ambiente científico tradicional. Éste es un problema de sociología de la ciencia planteado en sus términos generales por Thomas Kuhn sobre todo, quien en La estructura de las revoluciones científicas[125] ha mostrado, en particular, las dificultades con que tropiezan las nuevas ideas para penetrar en la educación. ¿Qué piensa usted al respecto?

Aprecio mucho el libro de Kuhn. La idea de paradigma es una idea muy justa.[126] Un paradigma tiene larga vida y sobrevive con mucho a su eficacia, sobre todo por motivos sociológicos. Desde este punto de vista, pues, las ideas de Kuhn pueden perfectamente incluirse en un esquema de tipo catastrofista. Quizá la aproximación sea un poco audaz, pero creo que los mecanismos básicos son bastante próximos. La inercia de un paradigma se debe a la miopía dejos científicos que trabajan en su ámbito, entregados a la «solución de rompecabezas», como dice Kuhn.[127] Está claro que cuando uno se dedica a la solución de un rompecabezas no se acuerda de todo lo que queda fuera del rompecabezas que tratamos de resolver: precisamente por esta razón, un paradigma puede verse, con el tiempo, amenazado desde el exterior, sin que los investigadores que trabajan en su interior tomen conciencia de ello. Se encuentran, pues, en una situación metaestable, incluso antes de darse cuenta. Una situación que es por completo análoga a la que se da, en el terreno político, en los períodos prerrevolucionarios. A menudo los regímenes se encuentran en dificultades porque los dirigentes no tienen conciencia clara de los peligros que les amenazan. Viven en un universo cerrado, separado de la realidad, y la revolución se desencadena, siempre que un grupo o un jefe más o menos carismático asuma la dirección de la revuelta. Si el fermento de las ideas logra sintetizarlo un «jefe», entonces se elabora una contradoctrina, un contraparadigma, que se contrapone al paradigma existente. En una situación prerrevolucionaria, con frecuencia las ideas son al principio un poco utópicas, casi milenarias: agitan los espíritus, aún sin tener un alcance concreto.

En todo caso, basta que estas ideas cristalicen en un principio de organización para que, en poco tiempo, se conviertan en una gran fuerza de atracción en torno a la cual se organiza la oposición que llevará luego a la revuelta. Por otra parte, una revolución se lleva a cabo cuando los mismos dirigentes dejan de estar convencidos de la validez del viejo paradigma. El análisis histórico de algunas situaciones revolucionarias muestra que, en muchos casos, si el gobierno hubiese utilizado la fuerza militar en el momento oportuno hubiese podido abortar la revolución antes de nacer. Pero lo que probablemente ocurre es que los mismos jefes están vencidos por las dudas y no saben utilizar la fuerza con la suficiente decisión: es entonces cuando están perdidos. Quizá en la evolución de las ciencias ocurre lo mismo: en un momento determinado, los mantenedores de un viejo paradigma se sienten vencidos por las dudas, y en ese momento queda abierto el camino para un nuevo paradigma.

Revoluciones políticas y revoluciones científicas: se trata de algo más que de un parecido superficial. En ambas, como por otra parte ha subrayado también Kuhn, el elemento básico suele ser una situación de «crisis» en la comunidad política o científica. El término «crisis» ¿no hace referencia, como «catástrofe», a un cambio de régimen cualitativo?

Existe en primer lugar una diferencia radical. Una «catástrofe» (en el sentido más amplio del término) es un fenómeno visible, una discontinuidad observable… La crisis, por su parte, puede ser algo latente. Muy a menudo se manifiesta sólo a través de una perturbación cuantitativa (y no cualitativa) de un proceso de regulación; pensemos, por ejemplo, en una crisis económica vinculada a la inflación…

También las «crisis» de la comunidad científica, las crisis de los paradigmas kuhnianos, pueden ser «invisibles»…

Sí, también aquí, como en otros terrenos, se da una relación clara entre crisis y catástrofe. La crisis anuncia con frecuencia la catástrofe a la que precede y a veces provoca. Son situaciones ya familiares para la física y la química: pensemos en los fenómenos de cambio de estado. Las situaciones caracterizadas por una morfología local fluctuante se presentan también en la sociedad, precisamente cuando se preparan los grandes cambios…

Sin embargo, hace falta una ulterior cualificación. Una definición formal de «crisis» no es lo que se busca necesariamente a nivel morfológico; no se puede reducir expeditivamente la «crisis» a la simple prevención de una catástrofe. La «crisis» se define a otro nivel, el de la subjetividad.

Los sistemas mecánicos, físicos, etc., tienen «puntos críticos», no auténticas «crisis». Las crisis tienen un carácter eminentemente subjetivo. En resumen, se encuentra en «crisis» cualquier «sujeto» cuyo estado, que se manifiesta con un debilitamiento —aparentemente sin causa— de sus mecanismos de regulación, es percibido por el mismo sujeto como una amenaza a su existencia…

Veamos algún ejemplo.

Basta observar las crisis económicas: ¿qué quedaría de tales crisis si se pudiesen eliminar los efectos psicológicos de las «situaciones de crisis» sobre los agentes económicos?

Pero si por esta componente subjetiva la noción de crisis escapa del cuadro conceptual de la dinámica, ello no quiere decir que concierna exclusivamente al sector de la psicología humana. En mi opinión, el contexto adecuado es el de la biología. De hecho, se puede hablar de organismo animal en crisis, teniendo en cuenta la rudimentaria subjetividad que podamos reconocer en los animales… En los animales, el ego no subsiste de forma permanente; se reforma, vuelve a cobrar forma de nuevo cada vez que pone en juego un gran reflejo regulador que involucra algún «objeto» externo. Pensemos, por ejemplo, en el mecanismo de depredador/presa. Se trata de situaciones ambiguas en las que al sujeto se le sustrae un objeto que «normalmente» le es habitual o se le ofrece una pluralidad de objetos entre los que escoger. Un caso del primer tipo es la llamada «privación sensorial», que puede llevar al sujeto a la angustia y a la alucinación. Un caso paradigmático del segundo tipo es el célebre asno de Buridán…[128]

Otro ejemplo posible: el pájaro fascinado por la serpiente. En este caso se podría pensar que la forma de la serpiente evoca en el pájaro la forma arquetípica del gusano, por lo tanto de su presa. Pero el tamaño de la serpiente hace de ella el depredador, y de ahí la parálisis del «juicio» del pájaro.

¿Y qué pasa cuando la individuación de las causas de la crisis permite resolverla?

En todos los casos que he citado, la crisis se produce en el sujeto debido a una carencia o a una ambigüedad de su objeto «normal» (no hay, hay demasiados, etc.) debida a la presencia de una situación conflictiva en el ambiente. Resolver la crisis significa escoger un objeto oportuno, en el que el sujeto vuelve a encontrar el objeto «habitual» y sobre el que el sujeto puede actuar (por ejemplo, mediante la captura). Este mecanismo de extinción de la crisis —que reporta al sujeto una especie de «credo»[129] que le da seguridad— es tan eficaz que el sujeto, incapaz de captar la verdadera causa del mal, se forja un falso objeto sobre el que actuar, con el resultado de eliminar (tan sólo) los aspectos psicológicos de la crisis en cuestión. En biología y también en sociología son numerosísimas estas «pseudosoluciones». Pensemos sólo en los chivos expiatorios a los que recurre demasiado a menudo la comunidad social en crisis (es típico el caso de las persecuciones y de las guerras promovidas por los nazis). Ahora bien, las pseudosoluciones tienen con frecuencia una eficacia local innegable, pero insistir en estas pseudosoluciones más allá de un determinado límite no tarda en generar una situación análoga a las de las crisis debidas a hybris: un mecanismo que se ha mostrado ventajoso hasta cierto punto se manifiesta desastroso más allá de un determinado umbral.

En todo caso, en no pocas situaciones, las crisis tienen un carácter beneficioso…

Una crisis en un ser vivo está siempre relacionada con un defecto de sus mecanismos de regulación. El análisis de la constitución del esquema de regulación de un animal muestra que estos defectos son inevitables, en cuanto están ligados a vínculos de naturaleza topológica (o morfológica). Así, un animal no puede vigilar permanentemente la totalidad del ambiente circundante con su aparato sensorial —su piel, por ejemplo, no puede estar en su totalidad cubierta de ojos—. Existen, necesariamente, lagunas, imperfecciones en la simulación del mundo exterior que hace el cerebro: si un enemigo utiliza en su propia ventaja estas lagunas, entonces se desencadena la crisis. Finalmente, el propio desarrollo «normal» comporta etapas «indeterminadas» que generan crisis, normalmente superadas…

Así pues, la crisis es inevitable y, por lo general, beneficiosa: puede hacer que el sujeto cobre conciencia de sus propias limitaciones e impulsarle a una «retirada estratégica» que le permite ganar tiempo y readaptarse mejor al propio «ambiente». La metáfora biológica resulta extremadamente útil, pues, para el estudio de la comunidad social y de las mismas comunidades científicas. Naturalmente, la elección por parte del «sistema» (o del «sujeto») de una pseudosolución puede desarrollar «tendencias aberrantes»…

La misma tensión entre «estado normal» y «estado de crisis», examinada en detalle, revela una notable concurrencia entre «crisis» y «normalidad», lo cual nos remite al modelo de desarrollo diseñado por Kuhn: la ciencia «progresa» a través de sus propias «crisis».

Como ya he dicho, el modelo kuhniano de la dinámica de la empresa científica me parece convincente desde más de un punto de vista. Si el asno de Buridán no quiere perecer, elige por fin entre heno y cereal: lo mismo ocurre en la comunidad científica en los grandes períodos de «crisis» en el sentido kuhniano, cuando se trata de optar entre dos paradigmas rivales. Pero también el modelo kuhniano tropieza aquí con algunas dificultades. Sigue abierto el problema de saber si la evolución histórica de las ciencias ha de depender de conflictos puramente sociológicos, dejando a un lado en un cierto sentido el problema de la confrontación con la experiencia. En otros términos: ¿cuál es el papel de la confrontación con la exigencia teórica de inteligibilidad por un lado y con la experiencia y el éxito a nivel práctico por otro, ante el éxito relativo de dos teorías en competencia? Se puede estar tentado de pensar que el papel de estos dos factores —exigencias teóricas y éxito en la práctica— es en realidad bastante importante. Evidentemente, puede suceder que el mismo campo experimental pueda explicarse por dos teorías en competencia de un modo, digámoslo así, bastante «complementario»: una teoría explica bien una parte del campo y mal la otra, mientras otra teoría explica mal la primera parte y bien la segunda. En este caso sería legítimo dudar entre las dos teorías y el éxito de una se debería probablemente a factores de índole sociológica o histórica. Pero en situaciones en las que una teoría es mejor que otra desde el punto de vista de la economía intelectual, del rigor, de la inteligibilidad y de la eficacia práctica, no cabe duda de que esta teoría acabará preponderando. Quizá precisamente por eso no he impulsado nunca demasiado la teoría de las catástrofes, porque estoy convencido de que tiene el valor suficiente por sí misma para tener éxito, aún no existiendo fuerzas sociológicas que la impongan. La mejor prueba de ello es que, por ejemplo, en «Mathematical and biological papers» se han publicado artículos de investigadores que establecen modelos de las diversas situaciones hablando de la cúspide como de algo cuyas propiedades se conocen muy bien, sin hacer referencia necesariamente a la teoría de las catástrofes. Esto prueba que la teoría ha arraigado entre los investigadores.

En su artículo «Rôle et limites de la mathématisation en sciences»[130] opone usted lenguaje matemático y lenguaje natural. ¿Por qué?

Se trata de una contraposición bastante clara. Se puede objetar que el lenguaje matemático exige también la utilización del lenguaje natural, pero ciertamente en el lenguaje matemático hay algo específico que lo opone al lenguaje natural. Lo que hay en él de específico es, creo, la posibilidad de definir variaciones continuas, que no son descriptibles lingüísticamente. Antes hablábamos de un oscilador lineal, que oscila en torno a un punto y he dado de él una descripción lingüística. Pero si introduzco el espacio de las fases (p > q) y si considero las relaciones H(p > q) = E, con E como constante,[131] tengo inmediatamente una descripción infinitamente más precisa que la puramente lingüística. Existe en el formalismo matemático una posibilidad por lo menos virtual de descripción que, de algún modo, introduce el infinito «actual» (ya que si existe en el continuo es precisamente un infinito actual). Por el contrario, la descripción lingüística común es una descripción por elementos discretos, una combinatoria.

«La utilización del lenguaje natural en la ciencia escribe usted [132] conlleva un problema epistemológico grave. ¿En qué medida los conceptos asociados a las palabras del lenguaje natural tienen un alcance universal (y, por eso mismo, son susceptibles de “cientificidad”)?». Nada asegura a priori que una palabra de una lengua tenga un equivalente exacto en otra lengua: ¿hay que traducir la palabra «razón» por Verstand o Vernunft en alemán? Si se le quiere garantizar a la ciencia una pretensión (por cuanto es relativa) de universalidad e intemporalidad, es necesario que los conceptos que utiliza puedan definirse y traducirse a todas las lenguas del mundo. Este problema de la cientificidad del concepto no parece haber recibido solución alguna satisfactoria. Pero ¿no es ésta una condición excesiva? ¿No se corre el riesgo, al ser demasiado exigente, de negar toda «cientificidad» a demasiados conceptos comúnmente utilizados hoy en las ciencias?

El problema de la traducción es muy intrincado. Creo, sin embargo, que los conceptos que se pueden considerar científicos son los conceptos a los cuales se puede dar una traducción unívoca en todas las lenguas del mundo y ello es posible porque, en mi opinión, se puede especificar su significado mediante la referencia a transformaciones que pueden considerarse transformaciones espaciales. El concepto de velocidad, por ejemplo, es científico en cuanto definimos la velocidad como la derivada de la posición con respecto al tiempo. Si se acepta que la posición, y asimismo el tiempo, es una referencia espacio-temporal universal, entonces también la velocidad tiene una definición intrínseca. Creo que los únicos conceptos que pueden considerarse racionalmente definidos de una forma intrínseca son los conceptos susceptibles de ser finalmente definidos, tras unas etapas intermedias, sólo mediante consideraciones vinculadas a la localización espacio-temporal. Desde este punto de vista, los únicos conceptos verdaderamente «científicos» son los conceptos relacionados con la geometría del espacio-tiempo.

Pero si, según Comte, se reconoce a cada disciplina el derecho a recurrir a una conceptualización específicamente suya, ¿no resulta este «criterio» demasiado riguroso?

Si es posible una tal conceptualización «científica», lo es en cuanto queda comprobada la posibilidad de disponer de conceptos intersubjetivos, una intersubjetividad que debe trascender la lengua en la que se formulan los conceptos. Las ciencias humanas, en particular, plantean problemas muy difíciles desde este punto de vista: los problemas de sociedad, de clase, de poder, etc., ¿son conceptos universales? Intuitivamente, uno se sentiría tentado a responder en forma afirmativa, pero no hay que estar demasiado seguro de eso…

Soy de la opinión de que si se llevase hasta el extremo esta exigencia de universalidad nos veríamos llevados a admitir que sólo los conceptos que se pueden geometrizar y llevar al espacio-tiempo son susceptibles de universalización y, por tanto, de cientificidad. Se podría proceder de una manera, por así decirlo, inferencial: se comprueba la cientificidad de un concepto a, que puede describirse mediante una determinada forma geométrica en un espacio sustrato; si en este espacio substrato se pueden operar combinaciones geométricas definidas que conduzcan al concepto b, entonces se podrá decir que la cientificidad del concepto a implica la cientificidad del concepto b. Así, desde este punto de vista, existe la posibilidad de una construcción inferencial de la cientificidad. No sé si este procedimiento se ha aplicado nunca, pero creo que sería teóricamente aceptable. Aquí se ve reaparecer la diferencia entre Frege y Russell: Frege sostenía que un sistema axiomático exige la verdad de los axiomas; según Russell, por el contrario, la verdad de los axiomas es algo que se postula, y lo que importa es la inferencia, a partir de los axiomas, de las proposiciones deducidas. En algunas cuestiones de cientificidad se puede muy bien aceptar una posición como la de Russell y preguntarse: supongamos que un cierto concepto sea científico, ¿podemos deducir de ahí que otro lo es?… sin que se pueda llegar nunca a una definición completamente intrínseca de la cientificidad de los conceptos. Una vez dicho esto, creo que hay conceptos de carácter subjetivo muy abstractos —como el concepto de sociedad, de idéntico, diferente, etc.— que probablemente podrían considerarse como universales. Pero éste es un problema muy amplio…

Parece que en las ciencias de la naturaleza se da también un problema similar. Muchos conceptos utilizados (orden, desorden caos, mensaje, información y etc.) con creciente entusiasmo por los investigadores tienen un claro carácter local. Las mismas entidades «derivadas» de la física, como velocidad —y también fuerza, energía, etc.— no están necesariamente localizadas…

Estas entidades derivadas presentan de hecho una naturaleza lingüística parecida a la de un predicado, de un adjetivo… Por ejemplo, el adjetivo «rojo» no está localizado espacialmente, participa de hecho —en cierto sentido— de todas las cosas rojas del universo, está localizado en el espacio (subjetivo) de las impresiones. En el fondo, hay aquí un poco de magia. Como ya he dicho, los más grandes éxitos científicos de la humanidad —empezando por los de la física— aparecen como en función de un acto de magia, una especie de acción a distancia. Así ha ocurrido con la gravitación newtoniana y, después, con la misma mecánica cuántica. Pero se trata de una magia rigurosamente controlada. Ha hecho falta Einstein para hacer de la gravitación una teoría local. Con la mecánica cuántica la cuestión es todavía más ardua…

La cuestión de la «cientificidad» de los conceptos nos ha llevado otra vez a la contraposición local/global…

De hecho, yo estoy entre los que piensan que una teoría no local no puede llegar a considerarse científica en un sentido estricto: conocemos —y actuamos— tan sólo localmente. Pero en lo que se refiere a la cientificidad de los conceptos, aquí el papel capital es el cumplido por la matematización (y la formalización). En la medida en que la deducción teórica puede efectuarse «formalmente», es decir mediante una confrontación local con formas asumidas como axiomas, adquiere con certeza una validez universal…

Pero el recurso a esta especie de combinatoria que sostiene la idea de la cientificidad inferencial ¿permite en realidad superar las dificultades relativas a la confrontación de «paradigmas» rivales? Examinemos un ejemplo específico, sobre el que tanto han insistido Thomas Kuhn y Paul Feyerabend. Kuhn por ejemplo, escribe: «¿Es realmente posible hacer derivar la dinámica newtoniana de la dinámica relativista? ¿Qué aspecto presentaría semejante derivación? Imaginemos una serie de proposiciones E1, E2, …, En las cuales en su conjunto constituyen el corpus de leyes de la teoría de la relatividad. Estas proposiciones contienen variables y parámetros representando la posición en el espacio, el tiempo, la masa en reposo, etc. De ello es deducible, mediante las reglas de deducción de la lógica y de la matemática, un conjunto de proposiciones adicionales, entre las cuales hay algunas que pueden ser verificadas por la observación. Para demostrar que la dinámica newtoniana puede ser considerada un caso especial, debemos añadir, a los precedentes Ei, nuevas proposiciones, como (v/c)2 < 1 lo cual restringe la amplitud de los parámetros y de las variables. Este conjunto ampliado de proposiciones se manipula hasta producir un nuevo conjunto N1 N2, …, Nm, que es idéntico en la forma a las leyes newtonianas del movimiento, a la ley de gravitación, y así sucesivamente. Por lo que parece, la dinámica newtoniana se ha derivado de la einsteiniana, bajo unas pocas condiciones restrictivas. Pero en todo caso la derivación es espúria…».[133]

Esta «derivación» se encuentra por otra parte citada en muchos manuales de teoría de la relatividad… En cierto sentido es lícito afirmar que la teoría de Newton es como un «caso especial» de la relatividad einsteiniana.

Pero la concordancia entre una y otra es sólo numérica, no «cualitativa». Como subraya Kuhn, las variables y los parámetros que en las Ei de la teoría einsteiniana representaban la posición en el espacio, el tiempo, la masa, etc., están también presentes en las Nj y siguen representando el espacio, el tiempo y la masa einsteiniana. Pero los referentes físicos de estos conceptos einsteinianos no se ven afectados de la misma manera que los conceptos newtonianos que tienen el mismo nombre.

Está claro que Newton no podía imaginar que un día la masa iba a transformarse en energía, ni nada parecido. Kuhn tiene razón substancialmente: para aparecer como un «caso especial» de la relatividad, la mecánica newtoniana debe ser «oportunamente transformada»; pero la simple posibilidad de transformaciones de este tipo —que frecuentemente funcionan en un solo sentido (es decir, en nuestro ejemplo, de la teoría de Newton a la de Einstein y no viceversa, por lo menos con éxito)— pone de manifiesto cuan exagerado resulta sostener que las teorías científicas se destruyen sin que haya progreso. Una vez aclarada la acepción particular de «caso especial», se puede afirmar que una teoría «contiene» la teoría precedente a la que, por decirlo así, ha «destronado». Según mi opinión, hay un único contraejemplo: la revolución galileana anuló por completo la problemática misma del aristotelismo.

Las ideas de generación y corrupción, por ejemplo, fundamentales en Aristóteles, desaparecen por completo en la perspectiva galileana (como, por otra parte, en Descartes). Así, los problemas relativos al nacimiento y a la destrucción de las formas han quedado drásticamente arrinconados.

De este modo, para decirlo con Feyerabend, «el procedimiento de Galileo reduce drásticamente el contenido de la dinámica: la dinámica aristotélica era una teoría general del cambio que comprendía el movimiento local, el cambio cualitativo, el cambio cuantitativo y el cambio de substancia (generación y corrupción). La dinámica de Galileo y de sus sucesores se interesa sólo por la locomoción».[134]

Precisamente considerando el caso histórico de la «ruptura galileana» es como Feyerabend encuentra los argumentos más interesantes en defensa de su «anarquismo metodológico». Pero para darle una valoración general, me parece que antes que nada hay que hacer alguna aclaración sobre lo que es modelización científica. No es difícil explicar lo que es un modelo en ciencia: coloquémonos ante una situación que presenta unas características sorprendentes para el observador, porque se desenvuelve de una manera imprevisible; hay elementos aleatorios o aparentemente indeterminados y factores que actúan de una forma no local —acciones a distancia, por ejemplo—. Se trata de dominar estas situaciones mediante la modelización, es decir, construyendo un sistema material o mental que simule las situaciones naturales de partida, a través de una cierta analogía. En este punto, se formula una cuestión acerca de la situación natural, se la transfiere al modelo, por analogía, y se hace que el modelo evolucione de forma que se llegue a una respuesta. Aplicando la analogía en sentido inverso se consigue una respuesta para la situación natural, que se confronta finalmente con los datos de la experiencia. La construcción de modelos tiene dos tipos de justificación: una justificación a priori y una justificación a posteriori. La justificación a priori deriva de una teoría de la analogía entre el sistema natural y el modelo, que sin embargo no se ha formulado todavía: la teoría de las catástrofes constituye, en cierto sentido, sus prolegómenos. En todo caso, hay casos en que puede darse una cierta justificación de la analogía (construyendo, por ejemplo, una maquette, se pueden encontrar correspondencias entre los datos de la maquette y los datos reales). Así pues, en la medida en que la analogía entre la situación natural y el modelo está justificada científicamente, el modelo queda justificado a priori. La justificación a posteriori es la confrontación con la experiencia, la confrontación de la respuesta del modelo con los datos experimentales. En mi opinión, la característica principal de la ciencia moderna es que exige con frecuencia una experimentación muy costosa y, por este motivo, se exige que los modelos propuestos estén a priori ampliamente justificados. No resulta tolerable aventurarse en una experimentación costosa si la modelización que la exige está mal fundada. Así, en la medida en que la experimentación resulta cara, hay que apelar a modelos muy bien justificados a priori. Pero la construcción de modelos es una apuesta, una apuesta y una ganancia: la apuesta es la justificación a priori, la ganancia lo es a posteriori. Ahora bien, en la ciencia moderna las cosas funcionan exactamente a la inversa: la justificación a posteriori es prácticamente despreciable con respecto a la justificación a priori. Ya que se requiere hacer experimentaciones costosas, la máquina experimental debe funcionar a toda costa. En mi opinión, ésta es precisamente una de las causas principales de la esterilidad de la ciencia moderna, esterilidad entendida como carencia de concepciones teóricas generales. Casi todos los resultados que se consiguen son ya previsibles desde el principio. Por tal razón, me sentiría tentado de sostener que los modelos más extravagantes y peor fundados son los que dan los mejores resultados. Ya me doy cuenta de que este tipo de afirmación puede parecer paradójica respecto al modo de pensar tradicional, pero me parece que muchos científicos estarían dispuestos a admitir que la mayor parte de los resultados verdaderamente significativos e interesantes, incluso en disciplinas muy experimentales como la biología, se han conseguido a partir de experimentos que no costaban nada.

Si es cierto que la inflación experimental de la ciencia moderna ha llevado a una desarrollo considerable de la producción científica, hay que admitir sin embargo que gran parte de esta producción carece hoy de interés. Basta echar una ojeada a periódicos científicos como Nature o Science para darse cuenta de la escasez de consecuencias que se derivan de los resultados principales que se nos comunican. Desde este punto de vista, la experimentación a ultranza lleva a una total devaluación del «hecho» científico. A fuerza de proceder a experimentos insuficientemente motivados, la investigación científica acaba perdiendo valor y es probable que dentro de poco la comunidad no acepte subvencionar investigaciones que no tengan motivaciones prácticas o teóricas ciertas.

Para decirlo con Lenin, entonces, «¿qué hacer?»

Habría que volver, como dice Habermas, a la idea de que junto a la verdad propiamente dicha de un resultado se debe considerar también su interés. Es la famosa fórmula que tantas veces he utilizado: «lo que limita lo verdadero no es lo falso, sino lo insignificante». Y la ciencia moderna, en el punto en que se encuentra, es un auténtico torrente de insignificancia.

¿Está usted de acuerdo, entonces, con la «proliferación de teorías» auspiciada por Feyerabend?[135]

Sí, siempre que esta proliferación no resulte demasiado costosa. Es preciso reconocer, evidentemente que hay sectores de la investigación experimental que por necesidad resultan muy caros. Las investigaciones sobre altas energías y sobre las partículas elementales, por ejemplo, exigen situaciones extremas, completamente marginales, en las que se aplica una concentración enorme de energía en un volumen muy pequeño. En cualquier caso, el problema consiste en saber si los conocimientos que se espera derivar del estudio de estas condiciones extremadamente marginales merecen todo el esfuerzo que se les consagra.

Los adeptos dirán siempre que sí…

Claro. Los especialistas se muestran unánimes al decir que sus investigaciones sirven para «penetrar cada vez con más profundidad» en el enigma de la materia y de la radiación, por lo cual se puede esperar que se llegue a saber más sobre su comportamiento y su constitución… pero esta actitud procede de un postulado de difícil demostración: que el estudio de condiciones cada vez más marginales, cada vez más extremas, lleve a una mejor comprensión de la situación normal. Éste es un postulado que resulta verdaderamente difícil de sostener, y yo me pregunto si en efecto vale la pena seguir insistiendo con tanta tenacidad en el estudio de las partículas elementales y de las altas energías.

¿Una mayor libertad teórica?

No cabe duda de que un cierto «abandono» a las consideraciones teóricas, a la especulación teórica, a la proliferación de las ideas más que de los experimentos, presentaría la ventaja de no resultar costoso. El pensamiento especulativo podría producir al cabo de poco tiempo ideas que conducirían a aplicaciones interesantes incluso desde un punto de vista práctico y experimental. Sería entonces seguramente útil, en mi opinión, una cierta «redistribución» de la orientación de la actividad científica, que en los últimos años se ha visto demasiado canalizada hacia las experiencias concretas. Según este planteamiento, también la distinción tradicional entre fines de la ciencia y fines de la filosofía podría en cierta medida desaparecer. Una investigación de tipo teórico, de hecho, podría tener a la vez implicaciones científicas y filosóficas. Y por otra parte, ¿por qué no iba a poder la especulación filosófica inspirarse en técnicas de orden científico?

¿Por ejemplo?

Se podrían dar ejemplos con la argumentación del primer motor de Aristóteles y con otros casos que preceden al divorcio histórico entre ciencia y filosofía. El problema, sin embargo, es el de cubrir esta distancia en los años futuros. Resulta bastante curioso que los filósofos de hoy pongan el acento casi exclusivamente en los métodos de la lógica formal: existen otros métodos científicos que podrían someterse a examen y es precisamente según esta óptica que habría que reconsiderar ciertas especulaciones de la lingüística, de la semántica o de la gramática universal. En cuanto a esta última, se podría decir que no es ni filosofía ni ciencia: no es filosofía, porque utiliza técnicas de carácter científico, y no es ciencia porque no se puede controlar mediante la experiencia.

Ya hemos hablado del control empírico y, más en general, del papel de la experiencia en la actividad científica cuando se ha subrayado que puede ser más relevante, en ciertos aspectos, el interés de una teoría que su «confirmación» empírica. Pero ¿en qué consiste, según usted, este interés?

A propósito de la tendencia a minimizar el papel de la experiencia y respecto a lo que se refiere a la cuestión del interés, ya he dicho en otro lugar que tenemos, por ejemplo, un conocimiento implícito de las leyes de la mecánica. Nuestro organismo está construido de tal manera que cada vez que actuamos espacialmente con nuestros músculos y nuestros huesos, satisfacemos automáticamente las leyes de la mecánica, de las que tenemos, por tal razón, un conocimiento implícito. Pero el problema, en realidad, consiste en pasar de estos conocimientos implícitos a un conocimiento explícito. Desde este punto de vista, pues, la investigación científica puede considerarse como una especie de «desvelamiento» de las estructuras que existen ya en el interior de nosotros mismos: una especie de psicoanálisis…

La pena es que el conocimiento explícito se ve por la general dificultado por mecanismos que, en términos psicoanáliticos, podríamos denominar de «censura». La simple introspección no puede liberar estas estructuras implícitas sin resistencia. La experimentación podría cumplir un papel importante al consentir, mediante el conflicto con el dato experimental exterior, que cayese la censura que nos impide ver nuestras estructuras. Por tal motivo, una experiencia será tanto más interesante cuanto más capaz sea de apartar estas censuras.

¿Por ejemplo?

Tomemos la famosa experiencia de Arquímedes. Mientras estaba en la bañera, sólo con su cuerpo como instrumento, Arquímedes[136] descubrió una ley fundamental de la estática; es decir que se dio cuenta, mediante la observación unida a la reflexión, de que somos mucho menos pesados en el agua que en el aire. En este caso no procedió tan sólo por instrospección, sino que intervino también una situación experimental particular, mediante la cual se produjo la generalización. Ahora bien, la gran debilidad del pensamiento filosófico tradicional se da precisamente en esta voluntad suya de limitarse siempre a métodos de introspección o de pura autorreflexión, que se detienen ante una especie de «muro», una censura que nos impide comprender nuestra estructura. Por el mismo motivo somos conscientes de los mecanismos de la digestión o del latir del corazón, pero únicamente en condiciones patológicas. En cierto modo, la aportación de la experiencia externa, cuando es significativa, consiste precisamente en hacer posible una experiencia interna que dé nueva información acerca de nuestra estructura y sobre nuestras posibilidades de conocer.

Una concepción del papel de la experiencia bastante diferente de la positivista tradicional…

La concepción positivista contiene, en mi opinión, un grave error: puede llegar a la insignificancia. Si nos limitamos a describir la realidad, no se plantea ningún obstáculo. Pero el problema no es describir la realidad, sino aislar en ella lo que tiene sentido para nosotros, lo que es sorprendente en el conjunto de los hechos. Si los hechos no nos sorprenden, no aportarán ningún elemento nuevo a la comprensión del universo. Lo mismo da ignorarlos.

Los experimentalistas a ultranza podrían rebatir que, a fuerza de hacer más y más sutil la investigación, cabe esperar que por fin se llegue a un elemento sorprendente…

Sí, pero entonces habrá que ser capaz de reconocerlo, es decir de ver en él el carácter sorprendente, lo cual no es posible si no se tiene ya una teoría disponible. Yo mismo me quedo estupefacto ante el modo en que los biólogos actúan, por ejemplo, en las cuestiones de biología molecular. El comportamiento de las macromoléculas es algo extraordinariamente sorprendente, y sin embargo, cuando se lee lo que normalmente publican los biólogos, da la sensación de que lo encuentran perfectamente natural. En la duplicación del DNA, en la forma en que la doble hélice se escinde y los dos filamentos se separan para situarse luego en dos membranas nucleares distintas,[137] etc., en todo eso no ven más que el trabajo de las enzimas, con las que creen explicarlo todo. Pero las cosas no suceden de esta manera, porque si dos enzimas llevan a cabo acciones contrastantes, hay que saber que una funciona en un cierto momento y la otra en otro. En otros términos, todo el problema de la organización espacio-temporal de estos procesos queda silenciado en esta «mitología enzimática». Así, pese a las concepciones suficientemente teóricas de que disponen, los biólogos no tienen conciencia del carácter sorprendente de estos procesos… y por otra parte, el carácter sorprendente de los hechos aparece, como decía antes, sólo a condición de disponer de una teoría que atraiga la atención sobre ello. Pero me parece que ya hemos hablado lo suficiente de todo esto. Quisiera pasar ahora a ciertas aplicaciones de la teoría de las catástrofes que considero especialmente «interesantes» en el sentido que he explicado…

Precisamente es la frontera de las aplicaciones más audaces lo que mejor contribuye a iluminar los rasgos generales de un «paradigma», especialmente si es centro de controversias…

Quisiera dar un primer ejemplo aportado por la geología. También aquí tiene valor la distinción entre aproximación «reduccionista» y «estructural», de la que ya hemos hablado[138]. Si una larga tradición —desde Aristóteles hasta D’Arcy Thompson— ha propuesto explicar las formas vivas recurriendo a «arquetipos» de naturaleza abstracta, también es cierto que en geofísica, en tectónica, en geomorfologia, no carecería de interés una aproximación de este tipo.

Recientemente (1978) he publicado algo sobre la tectónica de placas,[139] donde he interpretado las líneas de discontinuidad de la simetría de la corteza terrestre como un lugar de catástrofes, proporcionando un principio bastante parecido al principio de las catástrofes elementales.

En particular, he propuesto una teoría del vulcanismo que trata de explicar la presencia de volcanes en las fronteras entre placas (¡el vulcanismo en el interior de las placas me parece aún más difícil!).

Se trata de la intrusión de una metodología cualitativa en un campo que con frecuencia se plantea en términos de modelos cuantitativos…

Eso es. Muchos investigadores intentan una descripción global y exhaustiva del globo terrestre, con una evaluación cuantitativa «precisa» de parámetros como la presión, la temperatura, la composición química del magma, su viscosidad, etc., y no pocos estudiosos explican los efectos de éste o aquel agente erosivo sobre éste o aquel mineral utilizando modelos matemáticos muy refinados. Otros sin embargo, son menos ambiciosos: se esfuerzan por clasificar los accidentes morfológicos observados en una especie de taxonomía que no se arredra ante los fenómenos de convergencia: el mismo accidente morfológico puede observarse en los sustratos más diversos (por ejemplo: el punto triple entre placas se ve en la disposición en lastre de los suelos poligonales en un medio periglacial exactamente como las células de un epitelio en biología). Ante estos accidentes de naturaleza «ubicuista» importa, para mí, remontarse al tipo analógico de los mecanismos que los generan…

¿No se encuentra también aquí el dilema de toda teoría morfológica, el problema de la causalidad? Los accidentes morfológicos observados ¿desempeñan en realidad un papel causal en la evolución global del proceso, o son más bien simples síntomas planteados por los vínculos de la situación global?

Éste es el gran dilema de la física (interpretación de materia y radiación en relación con el espacio), en biología (los órganos son creados a menudo por una situación local, como en los fenómenos de regeneración, mientras en otras circunstancias la integridad funcional de los órganos es indispensable para el mantenimiento del equilibrio orgánico), etc. Hay que ser cauteloso con la causalidad: la idea de causa es engañosa, parece intuitivamente clara, mientras la realidad siempre está formada por una sutil red de interacciones. La aproximación «estructural», casi diría «platónica», trata de reintroducir la causalidad cada vez que consigue formarse una idea de los mecanismos subyacentes a los fenómenos, pero es muy prudente: a menos que se vea obligada, considera la morfología empírica tal como es, sin recurrir a una teoría causal externa al campo empírico dato o a «átomos» que pertenecen a un nivel de organización más pequeño. Por el contrario, los reduccionistas son gente con prisa: quieren predecir de inmediato, es decir «localizar» la causa para actuar sobre ella…

La referencia a «arquetipos», tanto en embriología como en geología, suena un poco como un desafío a la racionalidad contemporánea. Después de tanto hablar de la «ruptura epistemológica» de Galileo, Descartes, Newton, ¿no se vuelve a una especie de «filosofía de la naturaleza»?

Precisamente con Goethe y los Naturphilosophen apareció la tendencia a designar con el término «arquetipo» la imagen original (Urbild) de complejas estructuras concretas acabadas tanto en el mundo orgánico (la pata, el ala, la hoja, etc.) como en el inorgánico. En el psicoanálisis junguiano, más adelante, los arquetipos se han tratado casi como individuos dotados de subjetividad.

Está claro entonces que, si queremos devolver a la noción de arquetipo un estatuto científico, debemos definirla ante todo en situaciones simples, más bien abstractas… Aristóteles decía que en el desarrollo embriológico las estructuras se desarrollan de lo abstracto a lo concreto…

Veamos el ejemplo.

He aquí un caso bastante típico. La mayor parte de los animales presenta una embriología «triblástica»: el desarrollo se produce a partir de tres tejidos fundamentales: endodermo, mesodermo, exodermo.[140] El endodermo da lugar a la mucosa intestinal y a diversas glándulas digestivas, como el hígado; el mesodermo constituye huesos, músculos, sangre, corazón, sistema vascular y órganos de secreción; el exodermo da origen a la piel, a los órganos sensoriales y al sistema nervioso. Estoy tentado de identificar esta estructura ternaria de la embriología, que se da en particular en los vertebrados, con la estructura ternaria —sujeto, verbo, objeto— de la frase transitiva, del tipo «el gato se come al ratón». Ya que el mesodermo constituye huesos y músculos, su identificación con la categoría gramatical del verbo es inmediata; se mantiene, sin embargo, una cierta ambigüedad en lo que respecta a la correspondencia entre sujeto/objeto y endodermo/exodermo, pero me parece legítimo finalmente, hacer del endodermo el sujeto, asimilando toda acción a una depredación: es la mucosa intestinal, de origen endodérmico, la que asimila la presa después de la digestión. Por otra parte, la asociación objeto (presa) —exodermo queda justificada por el hecho de que es el exodermo el que fabrica el tejido nervioso; ahora bien, en los vertebrados, el sistema nervioso es un órgano que, por así decirlo, simula la situación del mundo exterior y contiene, como moldes, las formas de las presas.

Se trata en todo caso, de una metáfora…

Sí, pero una metáfora que tiene sentido. Puede hacer viable una embriología comparada de los vertebrados y de los insectos, por ejemplo. Entre los insectos no hay prácticamente endodermo. La estructura ternaria de la síntesis sujeto-verbo-objeto debe aquí identificarse al principio de la embriología con exodermo-mesodermo-vitelio…[141]

¿Cómo interpretar esta diferencia? En mi opinión hay que adoptar un cambio total de estrategia en materia de regulación. Mientras el insecto se encierra en su caparazón, de origen exodérmico, sin componente mesodérmica, como rechazando el mundo externo —como si se viese afectado por una especie de complejo «línea Maginot»—, el vertebrado exhibe una «filosofía de la vida» completamente distinta: consagra la parte principal de su tejido periférico (exodérmico) a la simulación del mundo exterior. La pared que lo separa del exterior, la piel, tiene una componente mesodérmica: su piel es, pues, la frontera fluctuante, continuamente regenerada en que se desencadena el conflicto entre el organismo y el mundo exterior.

Así pues, ¿debemos concluir con Goethe y Geoffroy Saint-Hilaire[142] que existe un plan general de la naturaleza?

Un plan, no el plan. La idea de un plan general del organismo conserva hoy su validez, no debemos abandonar la unicidad de tal plan. Los grandes planes de la organización animal corresponden a grandes opciones de la regulación del ser vivo. Tal regulación le permite al animal ser algo distinto de sí: éste es el llamado vínculo de la alienación primitiva.

Entre los insectos este vínculo cumple una función muy secundaria, pero entre los vertebrados se impone inmediatamente y alcanza su máximo en el hombre. La conciencia, de hecho es siempre conciencia no del ego, de este fantasma filosófico, sino de algo externo, localizado en el espacio y en el tiempo.

De este modo, invirtiendo una tendencia bastante consolidada, la explicación se vuelve «analógica»…

Así es. Creo que en cierto sentido la teoría de las catástrofes podría entenderse como una primera sistematización, bastante general, de la analogía…

Es decir, una teoría de la analogía, quizá la primera desde Aristóteles…

Es lo que he dicho en muchas ocasiones, y es una afirmación que Smale me ha reprochado mucho en un artículo suyo. Sin embargo, creo que se trata de un punto de vista que, históricamente, se puede defender. No ha habido una auténtica teoría de la analogía después de Aristóteles, mientras la teoría de las catástrofes permite abarcar la analogía en muchas formas. La analogía por ejemplo, sobreentiende, en cierto sentido, las categorías y las funciones gramaticales: cuando se definen las grandes categorías gramaticales, como el nombre o el verbo, lo que crea la unidad de las categorías es precisamente un cierto tipo de analogía. El verbo describirá, en general, un proceso en el tiempo; el nombre, a su vez, describirá un objeto atemporal. Ya en la definición de las grandes categorías gramaticales opera una cierta teoría de la analogía que yo me esfuerzo en explicitar, haciendo, donde es posible, consciente lo que actúa de una forma no consciente en los mecanismos de la analogía. Sigo ocupándome de estos problemas, y también de problemas de lingüística general, pero confieso que no he hecho grandes progresos en esta dirección, porque el problema no es simple. He propuesto a los lingüistas ideas que consideraba muy interesantes, pero no he conseguido convencer a los especialistas. Pensaba, a priori, que los lingüistas serían más receptivos que los biólogos, pero he tenido una desilusión, por lo menos en lo que se refiere a Francia (fuera, sin embargo, las cosas han ido de otra manera).

¿Por qué? ¿Qué opinión le merecen los lingüistas franceses?

La situación de la lingüística en Francia, sobre todo desde el punto de vista sociológico, es un auténtico desastre. Hay una miríada de pequeñas «iglesias»: los chomskianos, los funcionalistas, y así sucesivamente… Parroquias que tienen sus revistas, en las que se publican artículos cuyo único propósito es demoler las tesis de las «sectas» rivales. Lo peor es que, en realidad, están de acuerdo en las cuestiones de fondo, por lo cual las únicas diferencias se refieren a cuestiones de terminología o de notación. Esta situación testimonia el hecho de que la lingüística, a pesar de sus pretensiones de cientificidad, no se ha consolidado de hecho en este sentido.

Siempre me ha sorprendido este carácter «feudal» de la mayor parte de las ciencias humanas. Una situación que no es ni de lejos comparable a la de las matemáticas: en este campo, afortunadamente, no existe feudalismo alguno; hay rivalidades, evidentemente, entre las distintas especialidades, pero no tienen el carácter de «lucha organizada» que es característico de las ciencias humanas.

Pero ¿qué razones específicas ve usted en el rechazo de su propuesta por parte de este «nuevo feudalismo»?

Es una reacción bastante parecida a la de los biólogos de los que hablábamos antes, y creo que también las razones son las mismas. Los biólogos están interesados por los mecanismos visibles, los mecanismos de superficie —aunque parezca raro hablar de los cromosomas o del DNA como mecanismos de superficie. Del mismo modo, los lingüistas se interesan por la morfología lingüística tal como aparece en un análisis inmediato. Pero las llamadas «estructuras profundas», incluso en la teoría transformacionista, no resultan ser tan profundas. No son más que clases de equivalencia entre estructuras de superficie a través de transformaciones relativamente banales. Por el contrario, según mi opinión, sería mucho más interesante poner en evidencia la dinámica generadora de las estructuras profundas, exactamente como en biología sería interesante poner en evidencia los procesos dinámicos que generan las morfologías bioquímicas que estudian los biólogos.

Desgraciadamente falta, sin embargo, un bagaje conceptual adecuado. Creo que es una cuestión de tiempo: ¡es normal que las ideas encuentren dificultades para abrirse camino!

¿Excluye entonces convergencias, por ejemplo, con los chomskianos, sobre puntos específicos de la gramática transformacional?

Acepto los formalismos de las gramáticas transformacionales, aunque no comparto la presentación.

Se trata de una cuestión técnica: en una frase transitiva del tipo sujeto-verbo-objeto la gramática transformacional clásica distinguirá un sintagma correspondiente al sujeto y un sintagma verbal que se descompone en verbo y objeto. Pues bien, pienso que este tipo de descomposición es bastante arbitrario. Estoy de acuerdo con Tesnière[143] en decir que el sujeto y el objeto son entidades de la misma naturaleza; cumplen papeles que pueden ser asimétricos con respecto al verbo y que, de algún modo, conducen a ponerlas en un mismo plano frente al verbo. Por tal razón, subordinar el objeto al verbo de forma mucho más rigurosa que el sujeto me parece más bien arbitrario. Me parece que en esta forma de proceder hay un residuo del viejo logicismo, que consiste en decir que una proposición resulta de la atribución de un predicado a una substancia. Cuando se dice, por ejemplo, «Pedro pega a Pablo» habría que entender «Pedro está pegándole a Pablo»: una transformación, ésta, que no me parece del todo justificada. Creo que el verbo «pegar» es un verbo que exige un sujeto y un objeto y que no hay razón para pensar que haya un predicado global que califique el nombre «Pedro».

En la lógica formal, sin embargo, hay teorías de las relaciones que parecen adecuadas a este propósito.

Es verdad; se puede pensar que un verbo define algo como una relación, pero entonces el problema consiste en comprender por qué estas relaciones se ven tan limitadas en el número de puntos que rigen. Tesnière había propuesto en los años cincuenta una teoría en la que sostenía que todo verbo tenía una valencia. Existen según ella los verbos de valencia cero, los impersonales (como «llueve»); los verbos monovalentes, con un sujeto y sin complemento, (como «correr»); los verbos bivalentes (como «pegar»); los verbos trivalentes, con un sujeto y un complemento de atribución relativo (como «dar»); etc. Con esta idea de valencia, Tesnière podía clasificar los tipos sintácticos de los verbos de una forma razonable. Yo estoy de acuerdo con su teoría y creo que las relaciones discretas de los verbos se asocian con morfologías espacio-temporales bien definidas, que se pueden justificar en términos de catástrofes elementales.

Además, su misma estabilidad interna puede justificarse desde el punto de vista de las catástrofes. Claro que el universo lingüístico tiene su propia especificidad, es distinto del mundo físico.

Esta manera de ver las cosas es, en todo caso, bastante satisfactoria, ya que conduce a una buena teoría de las declinaciones, de los casos.

Se podría pensar que existe una teoría universal de la declinación que comporta, digamos, un cierto número de casos fundamentales (generalmente siete), eventualmente modulados por consideraciones localizadoras que, en determinadas lenguas, permiten construir un número mayor de casos. En las lenguas caucásicas, por ejemplo, parece que hay una cincuentena (pero sería un abuso poner este ejemplo en la base de la definición de los casos). Se trata más bien de modulaciones de superficie de casos fundamentales que se encuentran en las lenguas indoeuropeas: nominativo, acusativo, dativo, genitivo, ablativo, instrumental y locativo. Quizá pueda parecer un poco egocéntrico plantear las cosas de este modo, pero estoy convencido de que hay algo bastante universal en este elenco. Una vez dada esta teoría de la declinación verbal, queda por ver si permite, de hecho, el desarrollo de una teoría de la analogía.

La primera definición aristotélica de la analogía es una proporción de cuatro términos, del mismo tipo de la proposición matemática A/B = C/D.

Tomemos un ejemplo simple, la analogía aristotélica[144] en forma de proporción: vejez/vida = noche/día. Ésta se puede concentrar en la metáfora «la vejez es la noche de la vida». La relación que une los términos de esta proporción es una relación de carácter verbal, vinculada al verbo «finalizar»: la vejez es el fin de la vida y la noche es el fin del día. Aquí tenemos una relación expresada gramaticalmente con un genitivo que, de algún modo, contiene implícitamente el verbo «finalizar». Y por otra parte es sabido que un genitivo contiene un vínculo verbal implícito, como ha demostrado Emile Benveniste.[145] En el caso particular de esta proporción aristotélica, el verbo implícito es «finalizar», un verbo evidentemente relacionado con las catástrofes elementales… Desde este punto de vista, opino que los grandes casos que aparecen en la declinación pueden estar relacionados con ciertas trayectorias del despliegue de las catástrofes elementales, trayectorias que presentan a la vez propiedades de estabilidad y de especificidad ligadas a vínculos lingüísticos.

En el ejemplo considerado la analogía se encuentra en el concepto de fin, de muerte. ¿Cómo es posible geometrizarlo?

Podemos representar geométricamente este concepto con la extremidad (o borde) de un segmento llevado sobre el eje del tiempo. Tenemos entonces un ente geométrico-algebraico (el borde definido en la parte negativa del eje Ox por la desigualdad x ≤ 0) que viene situado en dos substratos diferentes, por una parte la vida, el día por otra, en forma de tiempo.

En mi opinión, una amplia clase de analogías pueden representarse de este modo: un ente geométrico-algebraico —un logos, un «arquetipo» si se quiere— se sitúa en dos substratos diferentes; define así un reparto de los espacios substratos en dominios que lingüísticamente definen los «actuantes»; las respectivas disposiciones de éstos en dos substratos, resultan, finalmente, geométricamente isomorfas. Este último hecho es el que expresa precisamente la analogía.

Entonces, ¿qué es un logos?

Es esencialmente una situación dinámica de conflicto entre «actuantes» que han de repartirse un espacio substrato. Cualquier morfología es el resultado de un conflicto.

He propuesto ver en las estructuras sintácticas del lenguaje (la estructura en forma de árbol de la gramática generativa) una imagen, simplificada y empobrecida, de las interacciones dinámicas más usuales del espacio-tiempo. El lenguaje se reduce así al resultado de una intrusión en el microcosmos a través de una especie de espejo-filtro simplificador de los conflictos más habituales que se desarrollan en el macrocosmos.

El propósito de la teoría de las catástrofes es, así, la clasificación de estos logoi, es decir de todos los posibles tipos de situaciones análogas. Pero debo decir inmediatamente que por ahora sólo tenemos el esbozo de un programa: los únicos logoi arquetipos bastante conocidos son los de las «catástrofes elementales», relacionados con aquellos entes algebraicos relativamente simples que son las singularidades de un potencial que se despliegan en un espacio substrato.

Estos arquetipos corresponden siempre a la categoría gramatical del verbo (como el verbo finalizar del ejemplo de Aristóteles que hemos recordado antes). Pero ciertas analogías apelan a la categoría lingüística del substantivo, como en el caso de la tan conocida analogía spenceriana que asimila la sociedad a un organismo viviente.[146]

El problema que se plantea en una situación de este tipo es el de aclarar lo que hace que estos substantivos tengan, por así decirlo, mecanismos de regulación en cierta medida comparables entre sí.

En mi opinión, un substantivo corresponde mentalmente a un concepto y un concepto debe considerarse como una especie de ser vivo, como un organismo que vive de algún modo, con un determinado cuerpo, en el espacio semántico. Este «cuerpo» tiene una frontera y el concepto tiene mecanismos de regulación, de homeóstasis, que le permiten resistir frente a las «agresiones» de los conceptos circundantes. En general, son precisamente estos mecanismos los que son destruidos por los verbos y el conjunto de estos procesos de regulación es lo que permite definir la naturaleza semántica del concepto. Más precisamente, la naturaleza semántica del concepto, es decir su significado, proviene por una parte de la totalidad de los mecanismos de regulación del concepto y por otra de la naturaleza del espacio substrato, que es un espacio semántico específico.

Así pues, para definir el significado de un concepto hay que dar su espacio substrato —en la totalidad de los espacios semánticos que nuestro espíritu es capaz de conocer— y el conjunto de los mecanismos de regulación que actúan en tal espacio substrato. Se puede decir entonces que dos conceptos, aunque dispuestos en espacios semánticos diferentes, presentan una analogía si sus mecanismos de regulación son isomorfos o apelan a estructuras isomorfas. Evidentemente es lo que sucede en la relación spenceriana organismo-sociedad a que antes aludía. En este caso las analogías resultan bastante evidentes: el organismo, por ejemplo, regula su forma espacial por regeneración, así como la sociedad mantiene o trata de mantener su territorio contra las agresiones de elementos exteriores. También hay analogías en cuanto a la organización interna: así como el organismo está formado por órganos distintos, cada uno de ellos dotado de una función, asimismo una sociedad presenta, en general, una estructura subdividida en clases, cada una de las cuales tiene una función económico-política diferente, y así sucesivamente.

¿Hasta qué punto se puede llevar una analogía de este tipo?

Hay unos límites. Por ejemplo, un organismo vivo se reproduce espacialmente, mientras que una sociedad no se reproduce de un modo sistemático. Así pues, la analogía existe, pero es muy difícil explicitarla, por lo menos a falta de una descripción suficientemente precisa de la totalidad de los mecanismos de regulación de los conceptos. Ahí es donde aparece en toda su amplitud el problema de la semántica. Este problema, en mi opinión, es doble: ante todo hay que dilucidar la naturaleza de los espacios substratos que contienen los conceptos y en segundo lugar hay que estar en situación de especificar cómo se generan, cómo se construyen las estructuras de regulación que garantizan la homeóstasis de estos conceptos. Es evidente que se trata de un problema inmenso, pero si se quiere hacer frente al problema de la semántica no se pueden rehuir cuestiones de este tipo: tarde o temprano, habrá que pasar por ahí.

Añadamos en un inciso que es un camino a recorrer también en epistemología; pensemos en el papel de la analogía en la investigación científica.

Sí, claro, pero muchos científicos desconfían de la analogía, que consideran gratuita o demasiado audaz. Otros, como K. Lorenz, no dudan en afirmar que, en todo caso y por definición, cualquier analogía es verdadera. ¿Cuál es, pues, la respuesta? En mi opinión, una analogía, una vez formalizada, es decir vinculada a un logos arquetipo bien definido, es necesariamente verdadera. Pero entonces interesa bien poco, aparte de la posibilidad de hacer metáforas más o menos poéticas. Si, por el contrario, la analogía no se puede formalizar, entonces es necesariamente conjetural y audaz. Precisamente por eso puede llevar a consecuencias nuevas e imprevistas. No existe sin embargo certeza alguna de que la analogía funcione: o la analogía es verdadera, y entonces es estéril; o es audaz, y entonces puede ser fecunda. Sólo corriendo el riesgo del error se puede dar con lo nuevo.

Pero, volvamos a esta ciencia que no es ciencia, la lingüística, es decir a la gramática universal…

En lo que se refiere a la gramática universal he propuesto inicialmente ordenar las categorías gramaticales según ciertos parámetros continuos, como, por ejemplo, la densidad semántica. En un artículo primerizo mío, «Sur la typologie des langues naturelles»[147] sugería considerar nombre, adjetivo, verbo, etc., como categorías ordenables «por densidad semántica decreciente». En un artículo posterior,[148] y gracias también a algunas observaciones de Hans Jakob Seiler, de la Universidad de Colonia, me declaré convencido de que cualquier sistematización de categorías gramaticales pasa a través de un doble sistema de dos parámetros que se deben poder aplicar en un plano. A eso es a lo que llamé «la doble dimensión de la gramática universal» (véase fig. 12).

FIG. 12. La doble dimensión de la gramática universal. N, V, A abrevian, repectivamente, nombre, verbo, adjetivo.

Puede ser interesante saber cuáles son los gradientes que aparecen: por una parte, el eje Ox, que va desde la cosa en sí al emisor, por otra, el eje Oy, que representa la complejidad semántica de los conceptos.

En el eje Ox están representados los aspectos que el lingüista Kenneth L. Pike llama respectivamente émico y ético; el aspecto émico es el aspecto de la cosa en sí, mientras que el ético es el aspecto de la cosa tal como la entiende el hablante. La idea que está en la base de este eje Ox, brevemente, es ésta: un concepto, como ya he dicho, es una especie de organismo que tiene su propia regulación; defiende su significado de las agresiones del ambiente a través de mecanismos bastante parecidos a los de un ser vivo. El significado de un concepto, por lo tanto, es algo autónomo, temporalmente invariable y no localizado. Otras funciones gramaticales, sin embargo, tienen características opuestas. Si se consideran, por ejemplo, los demostrativos en «esta mesa» o en «este individuo», está claro que la palabra esto se ve siempre acompañada idealmente por el gesto indicativo; digo «esta mesa» y la mesa se encuentra en la prolongación del índice con el cual señalo el objeto. Así, el significado de «esto» (y de formas gramaticales del mismo tipo) no es algo vinculado de una forma canónica a la palabra (como ocurre en ocasiones en el caso del substantivo), sino que más bien es un significado ligado a una situación específica, a una posición específica de nuestro cuerpo; es algo, pues, que depende de la actividad lingüística del hablante.

Estos dos polos opuestos constituyen precisamente los extremos del eje Ox. En el origen están los nombres, los substantivos, que tienen un significado intrínseco independiente de la actividad del locutor; en el otro extremo están los demostrativos, cuyo significado depende de manera fundamental de tal actividad. Entre los dos extremos se sitúan las formas gramaticales intermedias, cuyo aspecto émico y ético se combinan en diversa medida; los verbos, que tienen en general significado intrínseco y que están temporalmente localizados (como ya he dicho, la acción verbal se desarrolla en el tiempo y por eso está más cerca de la situación vivida por el hablante); los adjetivos, que ponen en juego la apreciación subjetiva del locutor y que, en general, son susceptibles de gradación (en muchos casos, una cualidad puede estar más o menos «marcada»), resultando aún más próximos a la actividad inmediata del lenguaje; y después los números, los artículos y, finalmente, los demostrativos. Se podrían añadir las cópulas lógicas como o e y, que tiene un significado puramente combinatorio, ligado a situaciones lingüísticas preexistentes, pero creo que la disposición de las formas gramaticales en el eje Ox, que va de la cosa en sí al locutor, queda ya bastante clara.

Pasemos al eje Oy…

El eje Oy representa la «complejidad semántica» de los conceptos. Un concepto es tanto más complejo cuantos más espacios fibrados, unos sobre otros, se requieren para su regulación. Tomemos uno de los ejemplos más complejos de concepto, el concepto de «hombre».

La regulación del hombre, como ser viviente, requiere ante todo la regulación biológica —las actividades fisiológicas como dormir, respirar, beber, etc.—; y por encima de este espacio fisiológico hay que considerar el espacio de las actividades mentales, como pensar, meditar, creer, reír, llorar, etc. Está claro que para organizar todas estas actividades hace falta una gran número de espacios que, por otra parte, son muy difíciles de definir.

«Hombre» es, pues, un concepto extremadamente complejo, y para expresar todos los significados asociados a él hay que utilizar un gran número de verbos. Por el contrario, si se toma un concepto extremadamente simple y abstracto como «unidad», se ve enseguida que puede describirse geométricamente con un «pozo» parabólico de potencial. Entre «hombre» y «unidad» están todos los demás conceptos: partiendo de lo concreto, como por ejemplo los nombres propios, se va descendiendo hacia lo abstracto: éstos son los dos extremos del eje Oy.

¿Cuál es, pues, el sentido comprehensivo de esta representación Ox, Oy?

Aristóteles ha diferenciado dos tipos de predicado, legetai tinos y einai en tini; nuestros dos ejes Ox y Oy están directamente vinculados a ellos. El predicado del primer tipo no aporta ningún elemento nuevo de información, sino que explícita más bien la estructura del lenguaje: así ocurre, por ejemplo, cuando decimos «Pablo es un hombre» o cuando Aristóteles decía «la gramática es una ciencia». Por el contrario, al considerar un predicado del tipo «el cielo es azul», está claro que en este caso atribuimos un accidente a la substancia «cielo» y, por tanto, una predicación de este tipo tiene un alcance ontologico, dice algo acerca de la realidad.

En mi esquema general (véase fig. 12), este último tipo de predicación puede quedar representado por una flecha horizontal paralela al eje Ox, que va desde la cosa en sí hasta el hablante. A través de una especie de túnel, la cosa en sí se sitúa en un cráter de potencial y el hablante en un cráter situado en el otro extremo. El «túnel» que permite pasar de uno a otro es precisamente el predicado; los predicados son «umbrales» que permiten la comunicación de la cosa en sí con el hablante, y precisamente por esta razón el hablante recibe un quantum de información que puede utilizar para su propia regulación. Dicho brevemente, éste es mi esquema de la actividad lingüística.

El esquema que ha propuesto para los conceptos del lenguaje ¿puede aplicarse también al lenguaje científico?

Creo que sí. Yo diría que funciona también en matemáticas. ¿Por qué no?

¿Un ejemplo?

He aquí un ejemplo que aprecio mucho, aunque no se trata de un concepto sino de una operación: la suma aritmética. Los lógicos han definido la aritmética inductivamente, mediante la definición axiomática de los sucesores de 1…

El sistema de Peano…

Eso es, el sistema de Peano.[149] Creo sin embargo, que se trata de una presentación artificiosa. La definición de la suma, como yo la entiendo, corresponde a la situación en que se da la catástrofe elemental de captura de un pozo de potencial por parte de otro, como en la cúspide. En todo pozo de potencial hay objetos que se pueden considerar como sólidos, en el sentido de que no pueden mezclarse. En el proceso de captura, pues, los objetos contenidos en un pozo de potencial penetran en el otro y no hay que hacer más que contar el número de los objetos que hay después de la captura. Es en parte como aquello que se les enseñaba a los niños: para sumar los huevos de dos cestos se pone el contenido de uno en el otro.

Todo está ahí ya: la adición se define recurriendo a un proceso fundamentalmente continuo y sólo artificialmente se realiza una operación definida de forma abstracta y discreta. El proceso generador subyacente es continuo. Y, por otra parte, esto no sirve sólo para la adición. En general, creo que las únicas estructuras matemáticas interesantes, dotadas de una cierta legitimidad, son las estructuras que tienen una realización natural en el continuo. Las estructuras discretas, pues, no son interesantes para mí más que en la medida en que pueden quedar inmersas, de algún modo, en el continuo. Lo que hace, por ejemplo, que el infinito numerable tenga sentido, pese al hecho de que se trata de un infinito que no se puede agotar, es el hecho de poder sumergirlo de una forma canónica en un segmento de longitud finita; ello queda muy bien expresado en las conocidas paradojas de los eleatas.

Tomemos la serie 1/2 + 1/4 + 1/8 + …, es decir ∑∞n=11/2n que notoriamente converge en 1. De este modo se obtendrá el segmento limitado [0, 1]; se podrá sumergir canónicamente el infinito numerable en tal segmento y dar así una justificación al infinito numerable.

Un punto de vista bastante diferente del tradicional…

Una auténtica inversión, diría yo… Según el punto de vista tradicional, el continuo se construye a partir del numerable por compleción o mediante el procedimiento de Dedekind.[150] Pero yo pienso que es al revés: el infinito numerable es lo que queda justificado por su inmersión en el continuo.

Pero entonces la operación de contar es una operación que tiene una estructura continua subyacente…

Es cierto. Y la mejor prueba de ello es que se trata de una operación que se desarrolla en el tiempo; y el tiempo es continuo. Antes se hablaba de complejidad semántica, pero en el caso de los números cardinales la complejidad semántica del entero n es su propio valor, por lo menos desde el punto de vista de la escala aritmética normal. Es verdad que la belleza de la teoría de los números es que esta escala normal —1, 2, 3, 4, …— puede sustituirse con muchos otros órdenes diferentes, como por ejemplo los números primos u otros de este tipo. Por otra parte, toda la teoría de los números gira alrededor de las relaciones entre los distintos tipos de orden que se pueden atribuir a los números enteros. También en este caso estoy convencido de que las estructuras más discretas surgen a partir de una especie de generación continua subyacente. Como se ve muy bien, por lo demás, en teorías puramente algebraicas, como la teoría de los grupos abstractos, en que se dan grupos más o menos extraños que aparecen como grupos de automorfismos de figuras continuas.

¿Cómo explica entonces la tendencia de los matemáticos a interesarse por la matemática finita?

No me parece, por ejemplo, que la teoría de los grafos (finitos) tenga mucho peso dentro del corpus matemático. Basta utilizar uno de los criterios preferidos por Dieudonné para darse cuenta de que el porcentaje de artículos publicados acerca de la teoría de los grafos no es superior al 1%. Lo que siempre me ha sorprendido, por otra parte, es que en la teoría de los grafos —y más ampliamente en el llamado análisis combinatorio— no exista un problema central.

Lo que hay más bien es una miríada de rompecabezas que con frecuencia no son más que curiosidades (como el problema del viajante de comercio o el de los grafos hamiltonianos).[151] No conseguimos comprender si hay o no un principio generador; tengo la impresión de que de hecho no lo hay.

¿Qué es lo que piensa entonces de la mecánica combinatoria?[152]

Pienso que en mecánica combinatoria hay problemas interesantes, problemas legítimos y naturales. Basta pensar en los problemas suscitados por la mecánica estadística: cuando se desea estudiar las colisiones de las moléculas, su configuración, se usa estadística, grafos, y no cabe duda de que se hacen consideraciones interesantes. Entre otras cosas, no queda excluido que se den analogías más bien profundas entre la teoría de las singularidades y algunos problemas de la teoría de los grafos. Pero no es cuestión de que nos detengamos ahora en cuestiones técnicas.

Pero grafos, redes y árboles le interesan ahora en más de un aspecto…

Aprovecho la ocasión para hablar de algunas investigaciones que no he publicado nunca y que quizá podrían tener aplicaciones interesantes.

Se trata de métodos que consisten, dado un proceso descrito lingüísticamente, en asociarles un grafo orientado. Más precisamente: en un proceso descrito lingüísticamente hay unos actuantes; en el proceso espacio-temporal cada actuante es una esfera abierta del espacio; las interacciones entre actuantes se pueden definir como contactos entre estas esferas abiertas.[153] Si en un momento dado se contrae alguna esfera abierta en un cierto número de puntos, se puede describir un gran grafo en el que se dan zonas de contacto entre interagentes, cada una de las cuales corresponde a un cierto tipo de interacción descrita por un verbo, como «amar a alguien», «matar a alguien», etc. He sugerido que se pueden asociar grafos a los verbos que describen procesos espacio-temporales, y estos grafos, a los que he dado el nombre de «grafos arquetipos», existen en número finito: alrededor de dieciséis.

Sin entrar en detalles, lo interesante es que se puede intentar aplicar este tipo de técnica al análisis del recuento, al análisis de las tramas complejas. Es algo que me propuso un grupo de jóvenes investigadores: analizar las tramas complejas, como, por ejemplo, las de los «folletines» que en el siglo pasado se publicaban por capítulos, historias de las que se daba un capítulo diario y que seguían así durante años. La trama se seguía por capítulos y para mantener el interés había que inventar cada vez nuevos incidentes. Precisamente del análisis de este tipo de enredo he tratado de crear un procedimiento que permitiese analizar los argumentos en términos de un gran grafo. Cada personaje corresponde a una línea del grafo y las interacciones entre los personajes se describen mediante contactos entre las líneas. Si se quiere hacer un análisis completo de este tipo de argumentos, hay que distinguir dos tipos de relaciones entre los actuantes; las interacciones circunstanciales, definidas mediante los contactos a los que antes aludía, que son relaciones temporales y locales descritas por el verbo; las relaciones institucionales, como por ejemplo los lazos de parentesco (Juan hijo tic Pablo), de dependencia o de empleo (Pedro servidor de Andrés); y otras del mismo tipo.

Una vez efectuada esta distinción, se descompone el grafo así obtenido en una familia de subgrafos, cada uno de los cuales tiene una cierta autonomía semántica en tanto que narración: cada grafo es una especie de subhistoria que mantiene su independencia con respecto a las demás. El esquema general de la subhistoria es el reconocimiento: dos individuos que se han conocido en la infancia se ven separados por las circunstancias de la vida, se pierden de vista y sólo mucho tiempo después vuelven a encontrarse, pero sin reconocerse. La historia acaba con el reconocimiento como catástrofe final. Éste es el tipo de enredo elemental que se encuentra con mucha frecuencia en el folletín. De lo que se trata es de dar de él una tipología: se descompone la historia en un conjunto de subhistorias, cada una de las cuales es una célula narrativa, y todas estas células forman, metafóricamente, una gran planta que se ramifica; en la base están los héroes principales (que en general aparecen los primeros y mueren los últimos) y luego, a partir de la base, se elaboran los actuantes secundarios, mediante un proceso de generación de las células secundarias que están ligadas entre sí por vínculos institucionales (si por ejemplo Pedro es el actuante principal de la célula A, la célula A podrá dar origen a la célula B, cuyo actuante principal será el hijo de Pedro), hasta llegar, siguiendo con nuestra metáfora, a las hojas del árbol, que constituye lo que denominaría la couche extremale de la historia. Ésta es una metáfora que me sugirió un botánico de Montpellier, de quien no recuerdo el nombre, que propuso una clasificación de la morfología de los árboles en un cierto número de tipos, observando que el árbol alcanza su forma adulta por ramificaciones sucesivas, hasta el momento en que la sexualidad, es decir la aparición de las flores, detiene el crecimiento. Pues bien, yo creo que en una historia ocurre exactamente lo mismo: la historia se detiene cuando aparecen las células (extremas) que contienen, de algún modo, su mensaje. O mejor aún: la historia no se detiene, sino que refluye, volviendo a descender, si así puede decirse, hacia la célula central en que se inició.

El mismo esquema sirve también para la novela policíaca: un individuo marginal, con su actividad egocéntrica, produce daños a su alrededor; desarrolla de este modo su esfera de influencia en la sociedad hasta chocar con ésta, la cual, por fin, con la intervención de la policía, le destroza. Es cierto que la novela policíaca puede considerarse como una historia moral desde el momento en que la policía es siempre buena; pero junto a este mensaje banal, en el que la sociedad prevalece sobre el marginado, hay otro mensaje, subyacente, que viene dado por el delito extremo llevado a cabo por el asesino, que precisamente desde ese momento entra en conflicto con la sociedad. Es precisamente en el conflicto de esta doble moralidad donde reside la fascinación de la novela policíaca.

En todo caso, es un intento que todavía hay que llevar a cabo…

La geometrización del significado de la que ha hablado en primer lugar, ¿se relaciona con esta tentativa?