La tecnología da forma a la música

Segunda parte: Digital

Recientemente asistí a una conferencia del experto en informática Jaron Lanier. Tras tocar varias piezas con un shen, una armónica china, explicó la sorprendente y prodigiosa historia de este instrumento. Dijo que era tal vez el primero en el que las notas tocadas eran elegidas por un mecanismo, un mecanismo precursor de la teoría binaria y por tanto de los ordenadores.

Ese antiguo utensilio llegó a Roma por la Ruta de la Seda, y el Imperio romano hizo construir una versión gigantesca de él (como los imperios acostumbran a hacer). El instrumento agrandado necesitaba un ayudante para soplar aire dentro —era demasiado grande para hacerlo sonar con la boca— y, más importante aún, una serie de palancas que seleccionaban las notas. Ese sistema fue la inspiración para lo que hoy conocemos por teclado; la serie de palancas con que se tocan las notas en los órganos (que son también un gran instrumento de viento) y en los pianos. Inspiró también al francés Joseph Marie Jacquard, que en 1801 construyó un telar cuyos complicados diseños eran guiados por tarjetas perforadas. Hilvanando las tarjetas se controlaba el dibujo del tejido.

Décadas después, el telar de Jacquard sirvió de inspiración a Charles Babbage, que poseía uno de los autorretratos de Jacquard donde este había usado ese sistema de tarjetas para tejer en seda su propia imagen. Babbage diseñó su máquina analítica, una máquina de cálculo que, de haber sido construida, habría funcionado con tarjetas perforadas.

En la versión de Babbage, las tarjetas ya no controlaban hilos, sino que daban el salto al concepto binario, al cálculo puro. Una joven amiga de Babbage, Ada Byron (hija del poeta), quedó fascinada por el aparato, y muchos años después se la reconoció como la primera programadora. Así, según Lanier, nuestro presente saturado de ordenadores le debe parte de su linaje a un instrumento musical. Y la informática, no mucho después de nacer, afectó también a la música.

La tecnología que posibilitó la digitalización de la información sonora (y, poco después, todo tipo de información) fue principalmente desarrollada por la compañía telefónica. Bell Labs, el área de investigación de Bell Telephone Company, recibió el encargo de encontrar una manera más eficaz y fiable de transmitir conversaciones. Antes de los años sesenta, todas las líneas de teléfono eran analógicas, y el número de conversaciones que podían manejar a la vez tenía un límite. La única forma de lograr que cupieran más llamadas en la línea era rebajar las frecuencias altas y bajas del sonido de la voz, y luego convertir el sonido de baja fidelidad resultante en ondas que pudieran correr en paralelo sin interferir unas con otras, de manera muy parecida a lo que ocurre con las transmisiones radiofónicas terrestres.

La división de Bell Labs era enorme y dio a luz a un montón de nuevas invenciones, como los transistores y semiconductores que forman los circuitos integrados de silicona (y hacen posible los minúsculos aparatos de hoy día), el láser, la tecnología de microondas, los paneles solares… la lista es infinita. Cuando tienes un monopolio te puedes permitir gastar en investigación y desarrollo, y ellos se dieron el lujo y tuvieron la previsión de planear a largo plazo. Científicos y técnicos podían trabajar en un proyecto que no mostraría resultados hasta diez años después.

En 1962, Bell Labs descubrió cómo digitalizar el sonido, para, en la práctica, muestrear una onda sonora y cortarla en diminutos pedazos que podían separarse en ceros y unos. Cuando pudieron hacer esto a un precio no prohibitivo y de una manera en que la voz humana siguiera siendo reconocible, aplicaron inmediatamente esa tecnología para hacer más eficaces sus líneas de larga distancia. Así se podían realizar más llamadas a la vez, con la voz convertida en un flujo de ceros y unos que podían comprimir (mediante codificación y transposición), junto con otras llamadas, en sus cables telefónicos. Esto era especialmente relevante considerando las limitaciones impuestas por los cables telefónicos submarinos de larga distancia: no podías simplemente instalar más líneas si de repente parecía que había más gente que quería hablar con Francia. Desde el punto de vista de Bell, la voz es, en un sentido abstracto, una especie de información. Por tanto, gran parte de su investigación respecto a qué hacía inteligible una telecomunicación, o a cómo lograr que se realizaran simultáneamente en mayor número, requería aplicar la ciencia de la información combinada con nociones extraídas de la ciencia de la psicoacústica: el estudio de cómo el cerebro percibe el sonido en todos sus aspectos. Entonces, comprender cómo percibimos el sonido se integró en la búsqueda de la forma más eficaz de transmitir información de todo tipo. Y fue incluso relevante en la metacuestión «¿Qué es realmente la información?».

La psicoacústica tiene aplicaciones en el sonido de las ambulancias (¿por qué nunca sabemos de dónde vienen?), la voz hablada y, por supuesto, la música. El prefijo «psico» está porque lo que oímos y cómo lo oímos no es simplemente mecánico, sino mental, en el sentido de que el cerebro «oye» tanto como el oído.

Por supuesto, gran parte de lo que oímos está parcialmente definido y limitado por el mecanismo de nuestros oídos. Sabemos que no podemos oír los sonidos agudos de los murciélagos o la gama entera de sonidos que oye un perro. Las ballenas producen unos sonidos de baja frecuencia que tampoco oímos, aunque son lo bastante fuertes como para causarnos daño físico si estamos demasiado cerca de su origen.

Pero hay cosas que «oímos» y no tienen nada que ver con la física del tímpano y del canal auditivo. Podemos, por ejemplo, aislar la voz de alguien que nos habla en un entorno ruidoso. Si escuchas la grabación de un restaurante ruidoso sonará como un caos acústico, pero de algún modo conseguimos distinguir palabras e incluso mantener una conversación precaria. Los sonidos repetitivos, como el ruido de las olas o del tráfico constante, se hacen inaudibles al cabo de un rato. Tenemos la habilidad de oír selectivamente lo que nos interesa y hacer que el resto quede en un distante segundo plano acústico. También tenemos la habilidad de percibir pautas en los sonidos. Tampoco esto tiene nada que ver con nuestros oídos. Podemos recordar tonos, y hay gente con un oído perfecto capaz de determinar con precisión notas oídas fuera de un contexto musical. Podemos distinguir si el chirrido de los frenos del metro y el tono más alto de un clarinete son la misma nota. Podemos recordar secuencias de sonidos —el canto de un pájaro o el crujido de una puerta seguido de un portazo— y el timbre exacto de los sonidos; a veces reconocemos la voz de un amigo con solo escuchar una palabra.

¿Cómo funciona esto? ¿Podemos recrear ese proceso mental con una fórmula matemática o con un programa de ordenador? Tal como podéis imaginar, tales cuestiones —cuál es el mínimo de información necesaria para reconocer la voz de un amigo, por ejemplo— eran de vital importancia para una compañía telefónica. Si conseguían descifrar qué es exactamente lo que hace comprensible e inteligible el habla, y aislar solo este aspecto —refinarlo, controlarlo—, entonces podrían aumentar la eficacia de su sistema telefónico mediante la eliminación de las partes superfluas de las transmisiones. El objetivo era llegar a comunicar más usando menos cantidad, o la misma, de material mecánico y eléctrico. Ese posible aumento en el flujo de información les haría ganar mucho dinero. La psicoacústica acabó llevando a un mejor entendimiento de la transmisión de información. De repente, esa ciencia enigmática se hizo tremendamente útil.

Una consecuencia imprevista de esa investigación relacionada con el teléfono fue la aparición de la tecnología de audio digital que más tarde se usaría en los estudios de grabación y en otros sitios. En los años setenta, un nuevo aparato, del tamaño de una maleta, apareció en los estudios de grabación. Se llamaba Harmonizer y podía cambiar el tono de un sonido sin alterar su velocidad o su tempo, tal como ocurriría si variabas el tono reproduciendo una cinta a más velocidad. Eso se lograba segmentando las ondas sonoras en partículas digitales, transponiendo matemáticamente lo que ahora eran simples números y luego reconstruyendo estos en sonidos de tono más alto o bajo. Las primeras versiones de esa máquina sonaban bastante mal, pero el efecto era de lo más llamativo, incluso cuando no funcionaba.

Por aquella misma época apareció otro aparato, llamado «retardo digital» (digital delay), que era de hecho un sampler primitivo. Las muestras digitales que creaba para imitar el eco acústico solían ser muy inferiores a un segundo y servían para producir efectos de retardo muy cortos.

Más aparatos siguieron: máquinas que podían captar y mantener muestras de sonido más largas con más resolución, y aparatos que podían manipular esos «sonidos» (en realidad no eran más que números) más ampliamente. Toda clase de rarezas resultaron de ello. Bell Labs se involucró en la producción de un procesador de sonido, el vocoder, que podía aislar ciertos aspectos de hablar (o cantar) como formantes del habla (la forma de los sonidos que usamos para formar palabras). Ese aparato podía eliminar estos aspectos de nuestro habla o de nuestro canto de la gama de frecuencias —como aislar solo las partes de percusión—, las tes o bes o el siseo de las eses o las efes. La máquina transmitía esos aspectos formantes de una voz separados del resto de una vocalización, y el galimatías resultante, al ser transmitido, era más o menos ininteligible. Pero los componentes del habla inteligente seguían allí. Los elementos del sonido del habla o del canto habían sido deconstruidos, y podían recuperar su sentido al ser restaurados.

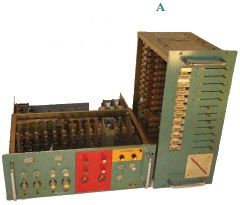

Maravilloso, pero ¿qué haces con esto? Un uso para esta tecnología fue una especie de criptografía para la voz: el incoherente guirigay podía ser «descifrado» desde el otro lado, si sabías qué había sido suprimido y dónde. Tales máquinas fueron adoptadas también para la producción musical. Abajo, el vocoder de la banda alemana Kraftwerk, hecho especialmente para ellos (fig. A).

El vocoder se usaba normalmente para aplicar esos formantes del habla aislados y separados al sonido de un instrumento de tono determinado. El instrumento parecía entonces hablar o cantar. La «voz» resultante solía sonar robotizada, aspecto que debía de ser del gusto de Kraftwerk. Una vez usé un vocoder como ese que me prestó Bernie Krause, músico y pionero del sintetizador, al que conocí cuando Brian Eno y yo hicimos el disco Bush of Ghosts. El vocoder estaba maravillosamente construido, pero era muy complicado de usar y terriblemente caro.

Los primeros Harmonizers (ese pitch shifter o modulador de tono digital) costaban miles de dólares. Por una buena unidad de reverberación digital, un estudio tenía que pagar quizá diez mil dólares, y un aparato de sampleo digital sofisticado, como el Fair-light o el Synclavier que salió poco después, costaba muchísimo más. Pero el precio de la memoria y de los procesadores bajó al poco tiempo, y la tecnología se hizo más asequible. Los económicos samplers Akai se convirtieron en la base del hip-hop y de las mezclas de DJ, reemplazando el anterior uso del vinilo, y los sonidos de batería sampleados o creados digitalmente tomaron el lugar del baterista en muchas grabaciones. Para bien o para mal, la gran carrera acababa de empezar.

La digitalización del sonido posibilitó la grabación digital y productos de consumo como el CD, y álbumes enteros fueron enseguida descompuestos en esos diminutos fragmentos de ceros y unos. Poco tiempo después, la capacidad y la velocidad de los ordenadores domésticos ya permitía grabar, archivar y procesar música. Todo esto derivó del deseo de Bell Labs de mejorar la eficacia de sus líneas de teléfono.

Bell Labs se convirtió más adelante en Lucent. A mediados de los años noventa visité su laboratorio y me enseñaron un procesador capaz de encajar en un ancho de banda minúsculo lo que al oído sonaba como música con calidad de CD. Creo que en esa época la codificación de música en MP3 ya había sido inventada en Alemania, así que esa compresión y codificación extremadamente eficiente no fue una sorpresa total. Y desde luego no tenía nada de sorpresa que el deseo de guardar más información sonora en menos espacio siguiera siendo una prioridad para la división de una compañía telefónica. Pero, como mucha otra gente, temí que ese proceso de «recorte» sacrificara de algún modo la calidad de la música.

Y tenía razón. Esos primeros archivos digitales con poco ancho de banda no acababan de sonar bien, como si faltara algo indefinible. No podías determinar por qué sonaban mal, pero era así. Todas las frecuencias parecían estar, pero era como si algo hubiera desaparecido en el proceso. Era música de zombis. Los MP3 han mejorado mucho desde entonces, y ahora escucho en este formato la mayor parte de la música que tengo. Creo que lo que Lucent desarrollaba acabó siendo usado en transmisiones por radiosatélite: meter sonido con «calidad de CD» en transmisiones con poco ancho de banda, para que un satélite pudiera enviar muchos canales de sonido con aparente alta calidad. Un procesamiento similar sería aplicado a fotografías y a señales de vídeo, lo cual nos permite ver películas en stream sin que aparezcan completamente llenas de grano o pixeladas.

En 1988 tuve ocasión de darle un vistazo anticipado a esa tecnología aplicada a la información visual, cuando el diseñador Tibor Kalman y yo visitamos un estudio de impresión en Long Island. El estudio tenía una máquina que podía digitalizar imágenes y luego manipularlas sutilmente (queríamos «mejorar» la imagen que iba a ser usada en la portada de un disco de Talking Heads). Igual que los primeros ordenadores y los equipos de grabación en estudio, esa máquina era increíblemente cara y rara de ver. Tuvimos que ir a donde estaba (no podía ser transportada al estudio de diseño) y tuvimos que reservar hora por adelantado. Sytex, creo que se llamaba la máquina. Por impresionados que nos quedáramos, su coste y escasez hizo que no nos planteáramos aprovechar sus posibilidades para futuros proyectos.

Un tiempo después, igual que con los samplers, el precio de escanear imágenes bajó y el retoque fotográfico con Photoshop se hizo común. Quedan defensores de la película, y no me cabe duda de que, igual que con el MP3, algo se ha perdido con las imágenes digitales, pero, bueno, para la mayoría de nosotros la contrapartida parece aceptable, e inevitable. No hace falta decir que, al ser digitalizadas, las imágenes entran en el flujo de los datos de conexión en red. Para nosotros, cada vez más, las imágenes son secuencias de ceros y unos; información, como el resto de las cosas. La digitalización de cualquier forma de medio posibilitó que internet sea lo que es, mucho más que una forma de transmitir documentos con base de texto. Ese fraccionamiento de contenido permitió que una extensa variedad de medios fluyera en ese río, y en cierto modo les debemos todas las imágenes, sonidos, canciones, juegos y películas que forman parte de nuestra experiencia en internet a la compañía telefónica, a la ciencia de la información y a la psicoacústica.

Los CD, que hicieron su debut en 1982, fueron desarrollados conjuntamente por Sony en Japón y Philips en Holanda. Antes se habían almacenado películas digitalizadas en laser-disc, que eran del tamaño de un elepé, y la posibilidad de codificar en un disco el contenido entero de un álbum parecía estar por tanto al alcance. Si se podía reducir el tamaño del disco, se podía ganar dinero con ello. Philips tenía la parte del láser en desarrollo y Sony aportaba su potencial manufacturador, así que acordaron trabajar juntos en ese nuevo formato. Fue un acuerdo inusual: lo normal era que una compañía desarrollara un formato propio y luego tratase de ejercer control sobre él para cobrar por su uso a las otras. El resultado fue que se evitaron muchas de las habituales majaderías de patente exclusiva que podrían haber entorpecido la aceptación y la difusión del CD.

Corrieron rumores de que la duración del CD estaba determinada por la de la Novena Sinfonía de Beethoven, porque esta era la pieza musical favorita de Norio Ohga, entonces presidente de Sony. Philips había diseñado un CD de 11,5 centímetros de diámetro, pero Ohga insistió en que un disco tenía que contener la grabación entera de Beethoven. La grabación más larga que el archivo de Polygram tenía de la sinfonía era de 74 minutos, de manera que el tamaño del CD aumentó a un diámetro de 12 centímetros para acomodar esa cantidad de información.

A diferencia de los elepés, cuyos surcos y agujas saltando limitaban el volumen, con la alta tecnología del CD las bajas frecuencias eran ilimitadas. La música ya no estaba en surcos físicos, sino codificada en una serie de ceros y unos. Aunque esos discos giraban como un elepé, eran técnicamente incomparables con los viejos discos. Su gama de audio extendida resultaba del hecho de que, al no haber un equivalente físico del sonido, los mensajes codificados le «decían» al lector de CD qué frecuencias tenía que reproducir. Los ceros y los unos podían dictarle al sistema estéreo que reprodujera cualquier cosa audible para el oído humano, a cualquier frecuencia y volumen deseado. En música digital, la gama sónica en realidad estaba solo limitada por los mecanismos de reproducción y muestreo que permitían grabar sonidos fuera del alcance del oído humano. La expandida e ilimitada gama de sonido era ya, o pronto iba a serlo, accesible para todo el mundo.

Inevitablemente, se abusó bastante de esta libertad sónica. Algunos discos (el escritor Greg Milner alude a la mayoría de los álbumes de Oasis y Californication de los Red Hot Chili Peppers) estaban tan artificialmente subidos de volumen que la música sonaba increíble en la primera escucha (sonaba más fuerte, y más consistentemente fuerte, que cualquier otra cosa), pero enseguida cansaba al oído. Milner afirma que esa «guerra del volumen» fue alentada por DJ y técnicos de radio, que querían que sus emisoras parecieran sonar más fuerte que las cercanas en el dial[1]. Para conseguir esto, el inventor Mike Dorrough desarrolló en los años sesenta un aparato llamado «procesador de audio discriminador», que tuvo gran aceptación años después, cuando todas las emisoras querían sonar más fuerte que nadie. Milner conjetura que los músicos y los productores de discos respondieron a esa competición encontrando cómo hacer que sus discos sonaran más fuerte y siguieran sonando fuerte durante el resto del disco[2]. La fatiga auditiva no tardó en ser general. No se le daba descanso al oyente; ya no había margen dinámico. Milner dice que ni los más furibundos fans de la música pueden escuchar una y otra vez esos discos, o siquiera llegar a escucharlos. El placer que producen es efímero y Milner supone que en esto podría haber una intención de apartar a los consumidores de la compra de música grabada. La tecnología que supuestamente tenía que popularizar más que nunca la música consiguió en cambio que todo el mundo la rehuyera.

Los primeros CD, igual que los MP3 que les siguieron, no tenían un sonido tan bueno. El doctor John Diamond trataba con música a sus pacientes psicóticos, pero en 1989 tuvo la sensación de que todo había empeorado. Según él, las cualidades terapéuticas y de curación natural de la música se perdieron debido a las prisas por digitalizar[3], y cree que ciertas piezas musicales pueden servir de alivio y de cura si son versiones enteramente analógicas, mientras que la versión digital tiene en realidad el efecto contrario. Ha hecho pruebas con pacientes que se han puesto nerviosos e inquietos al escuchar grabaciones digitales.

A lo largo de la historia de la música grabada hemos tendido siempre a supeditar la calidad a la conveniencia. Los cilindros de Edison no sonaban tan bien como los músicos en directo, pero te los podías llevar contigo y hacerlos sonar donde quisieras. Los elepés, que giraban más lento, no sonaban tan bien como los 45 rpm o los 78 rpm, pero no tenías que estar tan pendiente de ellos. ¿Y los casetes? ¿Bromeas? Nos dijeron que los CD durarían para siempre y que sonaban limpísimos, pero la verdad es que no suenan tan bien como los elepés, y su durabilidad está por ver. El espectro de sonido de los medios analógicos tiene un número infinito de gradaciones, mientras que en el mundo digital todo está seccionado en un número finito de fragmentos. Los pedacitos y los bits pueden hacerle creer al oído que representan un espectro auditivo continuo (la psicoacústica en acción), pero, por naturaleza, siguen siendo ceros y unos; peldaños, en lugar de una pendiente suave. ¿Y los MP3? Puede que sean el medio más conveniente hasta el momento, pero no puedo evitar pensar que la artimaña psicoacústica empleada en su desarrollo —la capacidad de hacerle creer y sentir a la mente que toda la información musical está ahí, cuando en realidad hay un gran porcentaje ausente— es una continuación de esa tendencia por la que nos dejamos seducir en aras de la conveniencia. Es música en formato de pastilla; proporciona vitaminas y funciona, pero le falta algo. A menudo nos ofrecen, y aceptamos gustosamente, medios prácticos, «suficientemente buenos», en lugar de los que en realidad son mejores.

¿Dónde termina esta serie de concesiones, e importa realmente si perdemos un poco de calidad por el camino? ¿No es la calidad o la fidelidad de una grabación más o menos irrelevante en el uso y disfrute de la música? Nos reímos a carcajadas con vídeos de payasadas borrosos y de atroz baja resolución, sacados de YouTube, y hablamos con nuestros seres queridos a través de redes telefónicas inalámbricas con una calidad de voz que haría que Alexander Graham Bell se revolviera en su tumba. La teoría de la información nos dice que la cantidad de bits necesarios para comunicar cierta clase de contenido —alguien hablando, por ejemplo, o las monerías de un gato— es mucho más baja de lo que pensamos. Si solo necesitamos entender el contenido verbal de alguien al teléfono, la calidad puede ser sorprendentemente mala y seguiremos sabiendo lo que nuestros amigos o familiares nos dicen. Parece no importar que la merma sea tanta. Quizá «suficientemente bueno» no esté mal.

O tal vez sí. Rechazando esa tendencia, algunos músicos han decidido volver a la grabación analógica, y algunos han llegado al extremo de empecinarse en grabar con tan baja fidelidad como puedan. ¿Por qué la baja calidad, la imprecisión y la distorsión deberían implicar que la música es más auténtica? La idea es que si uno acepta que las grabaciones nítidas y limpias son inherentemente frías e impersonales, entonces lo opuesto, lo áspero y sucio, debe de ser hondamente emocional. Quizá esto no suene lógico, pero es como pensamos. Es todo parte de la recurrente creencia que asocia las nuevas tecnologías a la falta de autenticidad. Lo malo —incluso lo falsamente malo, según esta manera de pensar— significa bueno. Es confuso, porque la mayor parte de la música digital no suena «mal». Cuando menos, suena convencionalmente bien; limpia, impecable, con una gama entera de frecuencias. Aunque no suena realmente tan rica como con anteriores tecnologías, le hace creer al oído que suena mejor. Es esta calidad brillante y pulida lo que muchos fans de la música consideran sospechoso. Como respuesta, sobrevaloran los fácilmente audibles inconvenientes de una era anterior: el siseo, el crujido y la distorsión. En mi opinión, la veracidad y el sentimiento están en la música en sí, no en las rayas y los saltos de los viejos discos. Así, aunque la pulcritud y la «perfección» de gran parte de la música actual no es garantía de una experiencia musical conmovedora, lo contrario tampoco lo es.

Si, siguiendo el ejemplo de la compañía telefónica, cuando hablamos de música estamos hablando de comunicación y de transmisión de información, quizá entonces parte de la riqueza sónica del elepé es también superflua y puede ser eliminada sin grandes pérdidas. ¿Funcionaría esto con el habla también? Sí y no. Para empezar, en la música pasan a la vez muchas más cosas que en el habla. Ver la reproducción de una pintura no es ciertamente lo mismo que tener la verdadera obra delante, pero incluso una copia puede comunicar gran parte de su emoción, ideas, intención y sensibilidad. De manera similar, una grabación horrible o una mala copia de una buena grabación puede arrancarme lágrimas de emoción. ¿Me conmovería aún más si la calidad fuera mayor? Lo dudo, así que ¿para qué molestarme?

Llega un momento, no obstante, en que la riqueza de la experiencia retinal o auditiva es tan reducida que la comunicación —el disfrute de la música, en este caso— se hace ininteligible. Pero ¿cómo podemos definir esto? Empecé a escuchar canciones de rock, pop y soul en un radiotransistor con un sonido de mierda, pero cambió mi vida completamente. La calidad de sonido era atroz, pero ese sonido metálico me comunicaba un montón de información. No era más que una transmisión de audio, pero el mensaje social y cultural incrustado en la música me excitaba tanto como el sonido. Esos componentes extramusicales que la música llevaba consigo no requerían una señal de alta resolución: bastaba con que fuera suficientemente buena. No estoy diciendo que ese sonido de lata deba ser considerado satisfactorio o deseable, o que no debamos nunca aspirar a más que «suficientemente bueno», pero es increíble cuánto puede comunicar una información de baja fidelidad o resolución. Tampoco las actuaciones en directo tienen un sonido perfecto, pero pueden conmovernos profundamente.

Ahora empiezo a preguntarme si la confusión y ambigüedad inherentes a las señales y reproducciones de baja calidad pueden ser en realidad un factor que le abran una puerta al espectador o al oyente. Escribir letras me ha enseñado que ciertos detalles —nombres, sitios, emplazamientos— son deseables; sitúan la pieza en el mundo real. Pero también lo son las ambigüedades. Dejando que el oyente o espectador rellene los espacios en blanco o complete la imagen (o la pieza musical), la obra se personaliza y el público puede adaptarla a su vida o situación; se involucra más en la obra y se hace posible una implicación y una intimidad que la perfección habría tal vez impedido. ¿Quizá esa gente de la música de baja fidelidad tenga algo de razón?

La composición de música cambió mucho con la llegada de la grabación digital. Tal como hemos visto, los primeros muestreos digitales eran muy cortos y los usaba principalmente la compañía telefónica. Se usaban para trucos y efectos especiales, pero esos primeros progresos no tuvieron gran influencia en la música. Sin embargo, poco después ya era posible capturar o samplear un compás entero de música, y aunque las muestras no eran de una calidad superalta, lo eran bastante. Los loops de ritmo se hicieron omnipresentes, y pistas rítmicas hechas de compases (o intervalos más cortos) sampleados componen ahora la base rítmica de muchas canciones. Puedes «oír» el empleo de Akai, Pro Tools, Logic y demás grabación digital y composición con sampler en la mayor parte de la música pop escrita en los últimos veinte años. Si comparas grabaciones recientes con otras de épocas anteriores, quizá no sepas qué las hace sonar diferentes, pero seguro que oirás la diferencia.

Los efectos de software no han influido solo en la calidad sónica, sino también en el proceso de composición. Quizá puedas también oír el efecto de los ceros y los unos que conforman la grabación digital, aunque quizá esto sea cada vez menos cierto, a medida que pasa el tiempo y la tecnología va superando los límites de la capacidad de diferenciar de nuestro oído. Lo que oyes, sin embargo, es un cambio en estructura musical alentado por la composición por ordenador. Aunque el software se promociona como herramienta imparcial que nos ayuda a hacer lo que queramos, todo software tiene peculiaridades propias que hacen que una forma de trabajar sea más fácil que otra. Con el programa de presentación PowerPoint de Microsoft, por ejemplo, tienes que simplificar tanto las presentaciones que a menudo se suprimen algunos matices sutiles en los temas que se debaten. No es que esos matices estén prohibidos, nada los impide, pero incluirlos suele dar lugar a una presentación menos lograda. Del mismo modo, los listados fáciles de visualizar funcionan mejor. Esto no significa que el sistema sea mejor; significa que una forma de trabajar es más fácil que otra. Con el software de música ocurre lo mismo. Seguir otro camino haría la composición musical un poco más tediosa y compleja.

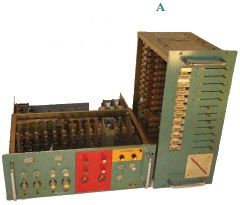

Un ejemplo obvio es la cuantificación. Desde mediados de los años noventa, la mayor parte de la música grabada con ordenador, los tempos y los ritmos han sido cuantificados. Esto significa que el tempo no varía nunca, ni siquiera un poquito, y las partes rítmicas tienden a la perfección metronómica. En el pasado, los tempos de las grabaciones siempre variaban ligeramente, acelerándose de manera imperceptible o quizá retardándose solo un poco, o había un redoble de batería que se demoraba para dar la señal de entrada a una nueva sección. Percibías un ligero tira y afloja, un estirón y luego un impulso, cuando músicos de cualquier estilo respondían unos a otros y fluctuaban, incluso inapreciablemente, por adelantarse o atrasarse respecto al compás de un metrónomo imaginario. Ya no. Actualmente, casi todas las grabaciones de música pop siguen un tempo estricto, lo cual hace que esas composiciones encajen más fácilmente en los confines del software de grabación y edición. Una sección de ocho compases grabada en una «cuadrícula» de ese tipo es exactamente el doble de larga que una sección de cuatro compases, y cada sección de ocho compases tiene siempre la misma duración exacta. Esto da lugar a una buena distribución visual en la pantalla del ordenador y facilita la edición, los arreglos y las reparaciones. La música ha acabado adaptándose al software, y tengo que admitir que se ha ganado mucho con el resultado. Puedo esbozar con mucha rapidez una idea para una canción, por ejemplo, y puedo cortar y pegar secciones para crear un arreglo casi instantáneamente. Las fluctuaciones excesivas o chapuceras, o los cambios de tempo mal tocados, pueden evitarse. Mi técnica tocando no es siempre firme como una roca, así que aprecio que esas inoportunas pifias o pequeños deslices en el ritmo puedan ser eliminados. El software facilita todo eso. Pero, hay que admitirlo, algo se pierde en el proceso. Empiezo ahora a aprender cómo escuchar, valorar y adaptar algunos de mis instintos musicales que no siempre se ajustan a la cuadrícula. Hace las cosas un poco más complicadas, pues sigo usando el software, pero tengo la sensación de que la música respira un poco más al no ceder yo siempre a lo que el software hace más fácil (fig. B).

A veces, tras haber empezado un proceso de composición con software de ordenador, me encuentro con que tengo que cantar o tocar apartándome de la grabación para liberarme de su tendencia normalizadora. Al cantar libremente una canción, por ejemplo, quizá descubra que la nota del clímax o del final de un arco melódico «pide» aguantar un poco más de lo que la cuadrícula de compases del ordenador indica como normal. El resultado es que una estrofa puede acabar teniendo nueve compases, en lugar de los ocho tradicionales. Por otro lado, medio compás de más puede ser percibido como una prolongación con carga emotiva, así como dar un breve espacio natural para respirar, y entonces añado ese medio compás a la cuadrícula del programa. En una colaboración reciente con Fatboy Slim descubrí que él añade a menudo compases «extra» para acomodar redobles de batería. Sonaba natural, igual que lo que una banda haría. Salirse de la cuadrícula es a veces beneficioso en otros aspectos también. Si el oyente adivina adónde va una pieza musical, empieza a desconectar. Salirse de las pautas establecidas mantiene el interés y el atractivo de las cosas, aunque a veces implica que tienes que evitar el camino de menor resistencia que los programas de grabación digital suelen ofrecer.

Cuantificar, componer y grabar en una cuadrícula son solo algunos de los efectos del software en la música. Otros efectos son creados por el uso del MIDI, o interfaz digital de instrumentos musicales. El MIDI es una interfaz de software y hardware mediante la cual las notas (tocadas en un teclado, generalmente) son codificadas como una serie de instrucciones, en lugar de ser grabadas como sonidos. Si tocas un la en el teclado, el código MIDI recuerda cuándo ha sido tocada esa nota en la secuencia de notas de la composición, cuán fuerte y rápido y por cuánto tiempo. Lo que queda registrado es la información y los parámetros (un poco como un rollo de pianola o los dientes de una caja de música), pero no el sonido en sí; de manera que al reproducir esa secuencia de instrucciones, el MIDI le dirá al teclado del instrumento que toque esa nota y las otras exactamente cuándo y cómo las tocaste previamente. Este método de «grabación» requiere mucha menos memoria del ordenador e implica también que la información grabada con las instrucciones es independiente del instrumento tocado, con lo que se le puede pedir a otro instrumento equipado con MIDI y con un sonido completamente diferente que toque la misma nota al mismo tiempo. Lo que empezó como sonido de piano puede transformarse después en cuerdas de sintetizador o en marimba. Con la grabación MIDI puedes decidir arreglos con facilidad y en cualquier momento.

El MIDI recuerda cómo de fuerte o rápido tocaste una nota dividiendo en 127 incrementos la velocidad del golpe en la nota. La velocidad de tu golpe será redondeada para que se ajuste a ese rango predeterminado. Naturalmente, si tocas una nota más rápido, más lento, o más sutilmente de lo que el programa MIDI y sus sensores pueden medir, tu «expresión» no será capturada o codificada con exactitud, sino que le será asignado el valor más cercano. Igual que con la grabación digital, la música es redondeada a su número entero más cercano, bajo la suposición de que un mayor detalle no será discernible para el oído y el cerebro.

Hay instrumentos razonablemente aptos para disparar el MIDI: teclados, algunos pads de percusión y cualquier cosa que se pueda traducir en interruptores y disparadores. Pero algunos instrumentos eluden la captura. Las guitarras no son fáciles de cuantificar de esta manera, como tampoco lo son los vientos, los metales o la mayoría de los instrumentos de arco. Hasta la fecha, los matices de esos instrumentos han resultado demasiado complicados de capturar. El empleo del MIDI suele por tanto disuadir a la gente de usar esos instrumentos y los tipos de expresión que les son exclusivos. Muchas grabaciones basadas en el MIDI suelen usar sonidos generados o activados por teclados, con lo que, por ejemplo, resulta más conveniente tocar series de acordes que se adapten bien a un teclado. Los mismos acordes en una guitarra suelen tener un orden diferente en las mismas notas. A su vez, entonces, esos acordes de teclado hacen que los compositores se inclinen por melodías vocales y armonías que encajan bien con esos acordes concretos, con lo que influencian no solo las partes e instrumentos MIDI, sino también la forma, la melodía y el arco de la canción. Tan pronto como la tecnología facilita una cosa, arroja un montón de alternativas a la basura.

La asombrosa perfección que las tecnologías de grabación y composición posibilitan resulta gratificante, pero la precisión metronómica resulta también demasiado fácil de conseguir con este método, y la simple perfección es a menudo obvia, omnipresente y en última instancia aburrida. Crear temas repetitivos solía ser laborioso y entretenido, y las ligeras variaciones humanas que inevitablemente asomaban cuando un músico trataba en vano de ser una máquina eran subliminalmente perceptibles, si no conscientemente audibles. Un tema de James Brown o de Serge Gainsbourg consistía a menudo en un riff tocado una y otra vez, pero no sonaba como un loop. Notabas de alguna forma que había sido tocado una y otra vez, no clonado. Imaginaos una hilera de bailarines moviéndose al unísono, con resultado de gran impacto emotivo y visual. Además de implicar trabajo duro, habilidad y precisión, funciona también como potente metáfora. Ahora imaginaos la misma hilera creada por una serie de espejos o con tecnología de imágenes generadas por ordenador. No es tan potente.

Durante muchos años, los DJ, mezcladores y artistas de hip-hop construyeron temas sampleando riffs y ritmos sacados de grabaciones previas. Algunos artistas fusilaban pasajes o estribillos enteros de canciones pop y las usaban como referencia o cita deliberada (P. Diddy lo hace mucho, igual que Kanye West), de la misma manera que citas una frase conocida con un amigo o una amiga para expresar tus sentimientos. ¿Cuántas veces se ha oído «put a ring on it» en una conversación? Las referencias a canciones son como atajos emotivos o acrónimos sociales.

En gran parte del pop contemporáneo, cuando oyes una guitarra o un piano, lo más probable es que sea un sampleo de esos instrumentos, sacado del disco de alguien. Lo que oyes en esas composiciones son montones de citas musicales, apiladas unas sobre otras. Igual que un cuadro de Robert Rauschenberg, Richard Prince o Kurt Schwitters hecho con imágenes tomadas en préstamo, entradas de conciertos o recortes de periódico, esa música es una especie de collage sónico. En algún sentido es metamúsica; música sobre otra música.

No obstante, muchos músicos no tardaron en darse cuenta de que con canciones creadas de esta manera tenían que compartir los derechos y los beneficios con las compañías de discos y los compositores originales de esos fragmentos y pasajes. La mitad del dinero de una canción suele ir al creador del pasaje o del estribillo. Algunas de mis canciones han sido sampleadas de esa manera, y es halagador y divertido oír a alguien dándole un sentido completamente nuevo a algo que escribiste años atrás. La cantante Crystal Waters sampleó un tema de Talking Heads («Seen and Not Seen», ¡qué extraña elección!) en su éxito «Gypsy Woman (She’s Homeless)», y su maravillosa canción (que incluso versioné una vez) no tiene ninguna relación con el original. Por lo que sé, ella o sus productores no aludían de forma intencionada a la canción original; simplemente encontraron algo en ella, el ritmo o la textura sónica, que les servía.

Además de que ser sampleado está bien pagado, no creo que perjudique al original. Todo el mundo ve que es una cita, un sampleo, ¿no? Bueno, depende. Trick Daddy, Cee Lo y Ludacris usaron otro tema de Talking Heads, la demo «Sugar on My Tongue», en su éxito «Sugar (Gimme Some)». En este caso la referencia al original era obvia, para mí, al menos. Usaron nuestro estribillo para hacer el suyo, pero dado que esa no fue nunca una canción conocida de Talking Heads (era una demo incluida en un estuche recopilatorio), ese aspecto de «cita» pasó probablemente desapercibido para la mayoría de los oyentes. (Para los que toman nota de este tipo de cosas, cobré y fui acreditado como compositor en ese tema; ¡una nada mala segunda vida para una canción que había sido originalmente una demo!) Puesto que el tema tenía ya algo de ingenua insinuación sexual, que esos tipos la llevaran un poco más lejos no suponía un problema, pero si alguien, hipotéticamente, se propusiera usar el estribillo de un tema mío en una nueva canción sobre matar mexicanos, dinamitar árabes o destripar mujeres, me opondría.

Muchos artistas empezaron pronto a darse cuenta de que el uso generalizado de sampleos limitaba considerablemente las ganancias de «sus» canciones, lo cual llevó a muchos de ellos a dejar de usar, o usar menos, la tecnología del sampler. A veces, incluso lo más fácil (sacar de un CD un golpe de batería, que se hace en pocos minutos) es algo que más vale evitar. Bandas como los Beastie Boys retomaron instrumentos que habían abandonado años antes, y los artistas de hip-hop disimularon mejor sus sampleos o encontraron otros más desconocidos o, la mayoría de las veces, empezaron a crear o comprar cortes hechos a partir de cero (a menudo con sintetizadores o cajas de ritmos). La tecnología, o más bien el aspecto de la tecnología que posibilitó el uso de material con derechos de autor, hizo que, gracias al esfuerzo de los que velaban por los derechos de autor, algunos músicos volvieran al punto de partida. Pronto apareció un grupo de entusiastas jóvenes programadores cuyo talento estaba en construir, para uso de terceros, ritmos creados a partir de cero. Con un equipo o programa de software relativamente barato podías contribuir a canciones importantes sin salir de tu habitación. En el hip-hop contemporáneo ya no hay a menudo relación entre la pista de acompañamiento de una composición y una simulación de músicos tocando en el sentido tradicional. En los inicios, los DJ en directo usaban vinilos para crear loops de cortes de batería, pero ahora todo —cualquier instrumento— es sampleado, procesado, o desvergonzadamente artificial.

Esa música escapa de toda referencia al mundo. La mayoría del resto de los géneros de pop retiene algún vínculo con la simulación de actuación en directo, o por lo menos con los instrumentos usados en ella, pero una canción construida con chasquidos de dedos, voces supercomprimidas o autoafinadas, sintetizadores zigzagueantes y graves increíblemente llenos e inidentificables, no se parece a ninguna banda en directo del mundo. En mi opinión, esto no es malo. Una nueva vía musical se ha abierto, una que quizá tuvo sus raíces en Kraftwerk y otros grupos de electrónica, pero ahora metamorfoseado en algo muy diferente. Es música concebida para afectar al cuerpo, muy sensual y física, aunque sus sonidos no reflejen ninguna música producida materialmente en el pasado. No puedes acompañar un disco de hip-hop contemporáneo tocando la guitarra aérea o haciendo que tocas cualquier otro instrumento. Incluso los sonidos que representan una «batería» no suenan como una batería de verdad. Esos artistas, por tanto, se enfrentan a una difícil decisión cuando tienen que actuar. Sus discos no contienen nada hecho con algo que suene como un instrumento «de verdad», de manera que la actuación se convierte en una especie de espectáculo de karaoke, con sonidos mayormente pregrabados; aunque a veces el artista y la banda deconstruyen la grabación para «tocar» las partes que la componen, de una forma que se parezca, visualmente al menos, a una banda tradicional. Esto puede sonar a crítica, pero tocar y actuar con sampleos y pistas pregrabadas le da al artista libertad para crear algo más teatral. La gira Light It Up de R. Kelly elevó el concierto tradicional de rhythm and blues al ámbito del teatro surrealista. En esos conciertos la música puede considerarse como la banda sonora de un espectáculo, una concentración de gente, una muestra de compañerismo con fastuosos efectos visuales y especiales. Hace algunos años, Grace Jones y los Pet Shop Boys hicieron eso. Eran básicamente bandas de dance club e iconos visuales, no bandas de directo, pero con una conciencia muy arty. Esa clase de espectáculo de karaoke ya es mayoritario. Aunque la voz solista sea en directo, al público no le suele importar si hay banda o no: la banda está para completar el decorado. Tengo que decir que en esos karaokes espectaculares hay un inevitable tope de emoción, al menos en lo musical, pues no existe la posibilidad de que la música supere su nivel preprogramado (no me refiero al volumen), pero si los elementos visuales y sociales son lo bastante buenos —y usar esta tecnología da más libertad para que lo sean—, la contrapartida puede ser aceptable.

Los artistas de hip-hop han hecho también resurgir la mixtape (o quizá nunca desapareció). Los ritmos sampleados y la grabación digital han permitido a los artistas de la mixtape crear fluidas secuencias de canciones, diálogo, ritmos y extravagancias varias, en maneras antes inalcanzables para una grabadora de casete. La mayoría de esas piezas se «editan» en CD, aunque el nombre remite a la era del casete. Pero tengo la sensación de que la era de la mixtape en CD está llegando también a su fin. Tengo mezclas digitales que consisten en una pieza musical de una hora seguida de duración, pero ahora, en el sentido técnico, no hay realmente límite. La extensión artificial que Sony impuso a los CD ya no procede. Puedes hacer un álbum descargable de diez horas de duración, o uno de solo diez minutos. Jem Finer creó recientemente una pieza musical que dura mil años. La comercialización y la promoción no son rentables para una sola canción cada vez, así que, por lo menos temporalmente, seguimos distribuyendo y comprando canciones en bloques (de una hora o menos, generalmente), tal como hemos hecho durante décadas. Pero no hay ninguna razón para que este estándar se mantenga indefinidamente.

En el extremo inferior de la gama de duración musical, los politonos no han sido aún reconocidas como forma válida y autónoma de creación musical, y quizá no lo sean nunca, pero la brevedad ya no debería importar. Se podría argumentar que el sonido de arranque del Mac es una composición musical, igual que el breve y misterioso crescendo de cinco segundos que indicaba el final de cada escena en la serie de televisión Perdidos. Los timbres de puerta, los zumbidos, las alertas de correo electrónico o las bocinas de coche son formas válidas de composición. Nuestro panorama musical se ensancha, pues la extensión ya no importa: lo breve, lo largo y lo intermedio coexisten.

El iPod, igual que el reproductor de casete Walkman antes que él, (fig. C) nos permite escuchar música donde queramos. Antes, la tecnología de grabación había desligado la música de la sala de conciertos, de la cafetería o del bar, pero ahora podemos llevar la música siempre con nosotros. Michael Bull, que ha escrito frecuentemente sobre el impacto del Walkman y del iPod, señala que muchas veces usamos estos aparatos para «estetizar el espacio urbano»[4]. Llevamos nuestra propia banda sonora allá donde vamos, y envolvemos con nuestra música el mundo que nos rodea. Nuestra vida se convierte en una película, y podemos modificar la partitura una y otra vez; en un solo minuto podemos pasar de una tragedia a una película de acción. Vivaz y fantasiosa, o siniestra e inquietante, cada uno lleva su propia película en la cabeza y todas son diferentes. Dicho esto, el filósofo del siglo XX Theodor Adorno, sempiterno quejica donde los hubiera, llamó a esa situación «soledad acompañada», una situación en la que, aun estando solos, la música nos ofrece la posibilidad de crear la ilusión de que no lo estamos[5]. Desde su punto de vista algo marxista, consideraba la música como un opiáceo, especialmente la música popular. (He conocido a varios firmes incondicionales de Wagner y me guardaría mucho de limitar solo al pop la acusación de que la música es un sedante adictivo). Adorno consideraba la máquina de discos un aparato que atrae a los «incautos» a los bares con la promesa de deleite y felicidad. Pero, igual que una droga, en lugar de proporcionar verdadera felicidad, la música de una máquina de discos solo crea más deseo de ella. Quizá Adorno tenía razón, pero quizá también fue una persona que nunca se lo pasó bien en un garito.

La audición privada podría ser considerada como la cota más alta del narcisismo, pues esos aparatos suelen excluir al resto del mundo de la experiencia de disfrutar de la música. En Un mundo feliz, Aldous Huxley imaginó una droga, llamada soma, que hacía flipar de gusto. Era como tomarse unas vacaciones, y con la dosificación podías regular la duración de las vacaciones. ¿Ha convertido la tecnología a la música en una droga parecida al soma? ¿Es como una píldora que garantiza una emoción deseada, como placer, ira o tranquilidad?

Algunos cantamos para nosotros mismos, o simplemente silbamos, cuando creemos que nadie escucha, y a menudo hay música «sonando» dentro de nuestra cabeza. Una parte del cerebro parece principalmente dedicada a la memoria sónica, y esto incluye no solo las melodías de teléfono, los gruñidos de perro o las sirenas de ambulancia, sino también fragmentos de canciones, grabaciones sobre todo, que hemos oído. Estos fragmentos sónicos funcionan como nodos en una red de recuerdos relacionados, que se extienden más allá de sus disparadores acústicos. Todos hemos sentido alguna vez que una canción nos «transporta» al vívido recuerdo de un antiguo romance o de cualquier otra experiencia de juventud. En esto, las canciones son como los olores; destapan mundos, lugares y momentos muy concretos. Otros sonidos hacen lo mismo también: la lluvia intensa, la voz de un actor famoso, un cuchillo en la tabla de cortar, un tren lejano…

¿Están los aparatos de música portátiles, y el mundo musicalmente sobresaturado en el que vivimos, empezando a sustituir a nuestra voz interior? ¿Estamos, poco a poco, dejando de cantar y silbar porque los profesionales ya cantan y tocan para nosotros, directamente en nuestros oídos? Un montón de asociaciones musicales nos dan vueltas por la cabeza, conectando con recuerdos y sensaciones recurrentes, que con el tiempo facilitan la creación y el afianzamiento de vías neuronales concretas. Esas vías nos ayudan a reconocer esas experiencias. Nos hacen lo que somos. ¿Está ahora ese espacio inhibido por la avalancha de música y de sonidos de otros? ¿Está nuestra voz interior, el parloteo inaudible que usamos para resolver quiénes somos y dónde estamos, siendo reemplazada por la voz de profesionales? Bueno, yo no he dejado de cantar para mí mismo, así que tal vez no.

Solo escucho música en momentos muy concretos. Cuando salgo a escucharla en directo, por supuesto. Cuando cocino o lavo los platos pongo música, a veces con otra gente presente. Cuando hago footing o voy o vuelvo del trabajo en bicicleta, por el carril bici del West Side de Nueva York, o en un coche de alquiler, en las raras ocasiones en que tengo que ir en coche a algún sitio, escucho música yo solo. Y cuando estoy componiendo o grabando música, escucho lo que estoy haciendo. Pero esto es todo. Esta lista relativamente corta define en gran medida dónde y cómo escucho música. En bares o restaurantes, la música me carga un poco. Quizá por mi implicación en ella, siento que tengo que escucharla con atención o desconectar. Generalmente desconecto, y muchas veces ni siquiera me doy cuenta de si una canción de Talking Heads suena en algún espacio público. Desgraciadamente, la mayor parte de la música se convierte (para mí) en una irritante capa sónica que se suma al ruido de fondo. Puede sonar a que soy un quisquilloso, pero la verdad es que escucho mucha música.

Al ser la música cada vez menos una cosa —un cilindro, un casete, un disco— y más algo efímero, quizá empecemos a darle otra vez un mayor valor a las actuaciones en directo. Tras años de acumular elepés y CD, tengo que admitir que ahora me estoy deshaciendo de ellos. De vez en cuando pongo un CD en el lector, pero casi me he convertido completamente al MP3, que escucho en mi ordenador o, glups, ¡en mi teléfono! Para mí, la música se está desmaterializando, está volviendo a un estado más fiel a su naturaleza, me parece. La tecnología nos ha devuelto al principio.

Por lo menos una vez a la semana voy a una actuación en directo, a veces con amigos, a veces solo. Allí me encuentro con otra gente. También suele haber cerveza. Después de más de cien años, estamos volviendo a donde empezamos. Un siglo de innovación tecnológica y la digitalización de la música han tenido el efecto involuntario de darle énfasis a su función social. No solo seguimos dándoles a los amigos copias de la música que nos entusiasma, sino que valoramos cada vez más el aspecto social de la actuación en directo. En algún sentido, la tecnología musical parece haber seguido una trayectoria que acabará en su propia destrucción y devaluación. Triunfará completamente cuando se autodestruya. La tecnología es útil y conveniente, pero finalmente ha reducido su propio valor y ha incrementado el de las cosas que nunca ha podido capturar o reproducir.

La tecnología ha cambiado cómo suena la música, cómo se compone y cómo la experimentamos. También ha inundado de música el mundo. El mundo está saturado de (sobre todo) sonidos grabados. Antes teníamos que pagar por la música o debíamos hacerla nosotros mismos; tocarla, escucharla y experimentarla era excepcional, era una experiencia rara y especial. Ahora escucharla es universal, y el silencio es la rareza por la que pagamos y que saboreamos.